Hadoop源代码深度解析:分布式云计算核心技术剖析

Hadoop源代码分析完整版深入探讨了Apache Hadoop这一分布式云计算领域的核心技术,特别关注的是其核心组件Hadoop Distributed File System (HDFS) 和 MapReduce 的工作原理与实现。Hadoop最初源于Google的五个关键项目——Chubby、GFS、BigTable和MapReduce,Apache社区将其开源并发展为Hadoop生态系统,其中Chubby对应ZooKeeper,GFS演变成HDFS,BigTable演化为HBase,MapReduce则是Hadoop的主要计算模型。

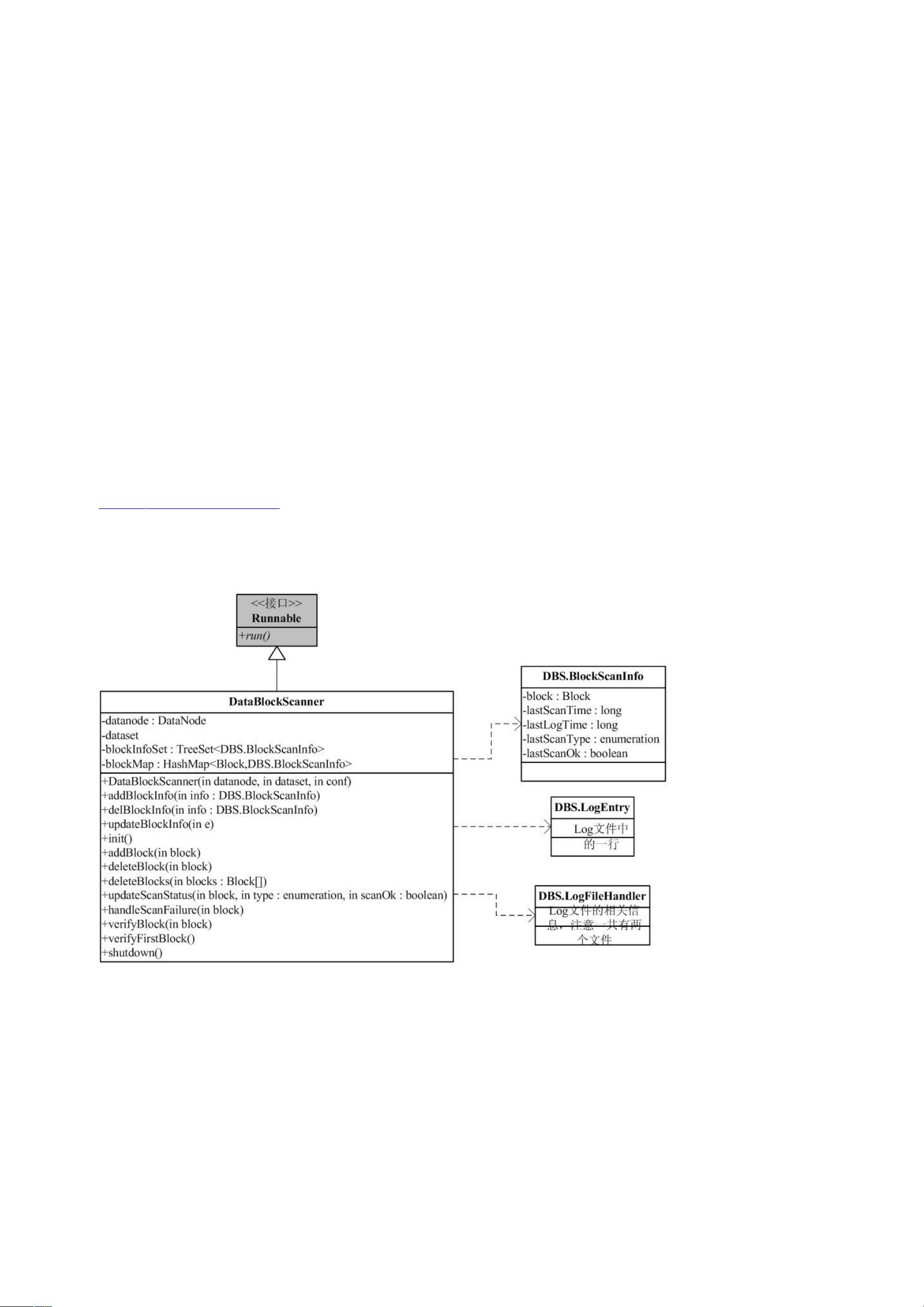

HDFS作为分布式文件系统,是Hadoop架构的基础,它解决了大数据存储和访问的问题。HDFS的设计目标是高容错性、高吞吐量以及数据的备份和恢复能力。HDFS通过将大文件分割成多个小块,并在多台机器上进行分布式存储,实现了数据的冗余和负载均衡。这种设计使得Hadoop能够处理PB级别的数据,非常适合大规模数据处理任务。

Hadoop的包结构复杂,反映出其模块化的开发思路。例如,conf包负责读取系统配置,依赖于fs包以访问文件系统,这表明了不同模块间的紧密协作。而fs包又封装了文件系统功能的抽象,使得代码能更好地隔离底层细节。蓝色部分代表Hadoop的核心组件,如HDFS的FsShell、Hadoop Distributed FileSystem (HDFS) Client、Hadoop Common等,这些都是后续分析的重点。

MapReduce是Hadoop的另一个核心组件,它是一种编程模型,允许开发者编写处理大规模数据集的应用程序。MapReduce将复杂的计算任务分解为一系列简单的Map和Reduce操作,分别执行在不同的节点上,从而实现并行化处理。这个模型简化了程序员编写分布式应用程序的复杂性,使其易于理解和维护。

Hadoop的源代码分析深入到了具体的包依赖和接口设计,这对于理解Hadoop的工作流程,优化性能,以及进行扩展和定制具有重要意义。通过学习和分析Hadoop源代码,开发者可以更好地掌握分布式计算的基本原理,提高在实际项目中的应用能力。同时,随着大数据和云计算的发展,掌握Hadoop技术对于数据科学家和工程师来说是至关重要的技能。

2024-06-26 上传

2024-09-04 上传

2024-09-03 上传

2024-09-25 上传

2024-10-26 上传

2023-09-05 上传

2023-07-27 上传

2023-07-25 上传

2024-09-20 上传

hugejiletuhugejiltu

- 粉丝: 5

- 资源: 111

最新资源

- TRANSCEND-SM32X-V2.03.50-L0105-by-tagaraz.zip

- 行业分类-设备装置-多媒体箱[3].zip

- react-truncate:React组件,用于截断多行跨度并添加省略号

- 通过java servlet实现了二进制转成十进制八进制功能(附页面效果)

- Adafruit_PlatformDetect-3.56.0-py3-none-any.whl.zip

- ionic-starter-sass-coffee:使用 sass、coffeescript 和 ng-classify 的离子状态器

- YKFilterBitmap:滤镜

- 小程序源码 OAuth认证以及使用网易微博开放平台实现聊天功能.rar

- 4352.4平米,五层框架办公楼(含计算书,建筑、结构图).rar

- ometrics:python的组织指标

- 锅炉安装施工组织设计方案封面

- 2020-future-of-web-dev-emberlondon:“2020

- TypeScript-2.3.1.tar.gz

- tdlSSim_secs,gem_trapqt3_SECSGEM_SECS_secdemo_源码.zip

- socketio-client-tool:该工具可帮助您测试socket.io服务器

- 通过 USRP、OFDM 进行视频传输的 GNURadio 流程图