29年历程:深度卷积神经网络的发展与应用概述

需积分: 50 24 浏览量

更新于2024-07-18

1

收藏 3.47MB PDF 举报

卷积神经网络(CNN)是一种深度学习架构,自1989年Yann LeCun首次提出以来,经历了显著的发展和优化。从最初的简单网络用于手写字符识别,到如今在机器视觉、自然语言处理和计算机图形学等多个领域取得显著成就,CNN已成为深度学习中最广泛应用的技术之一。

早期的卷积神经网络,如文献[1]中的模型,由卷积层和全连接层组成,接受16x16的归一化图像输入,目标是分类0-9的数字,共三层,其中H1和H2为卷积层,H3为全连接层。这一设计引入了权重共享和特征映射的概念,极大地减少了参数数量并提高了模型的效率。激活函数采用tanh,损失函数选用均方误差,权重通过随机初始化,使用反向传播算法计算梯度,并采用在线随机梯度下降进行权重更新。

文献[2]进一步展示了CNN在实际任务中的应用,如邮政编码识别,网络结构与文献[1]相似,但使用了4个卷积核和下采样层来提取不同尺度的特征。这种设计策略有助于降低过拟合风险,同时利用不对称的多通道卷积减少了参数量。

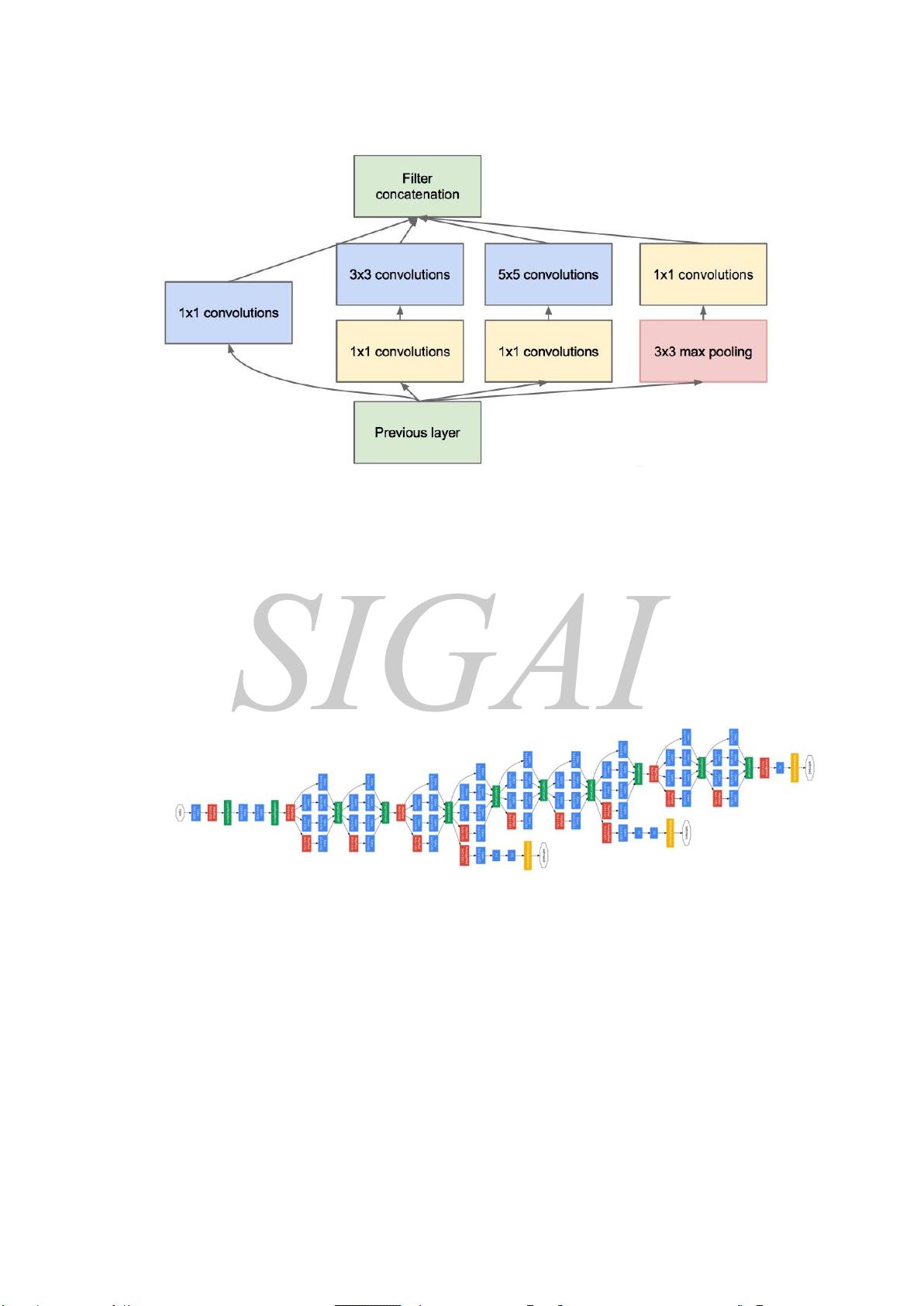

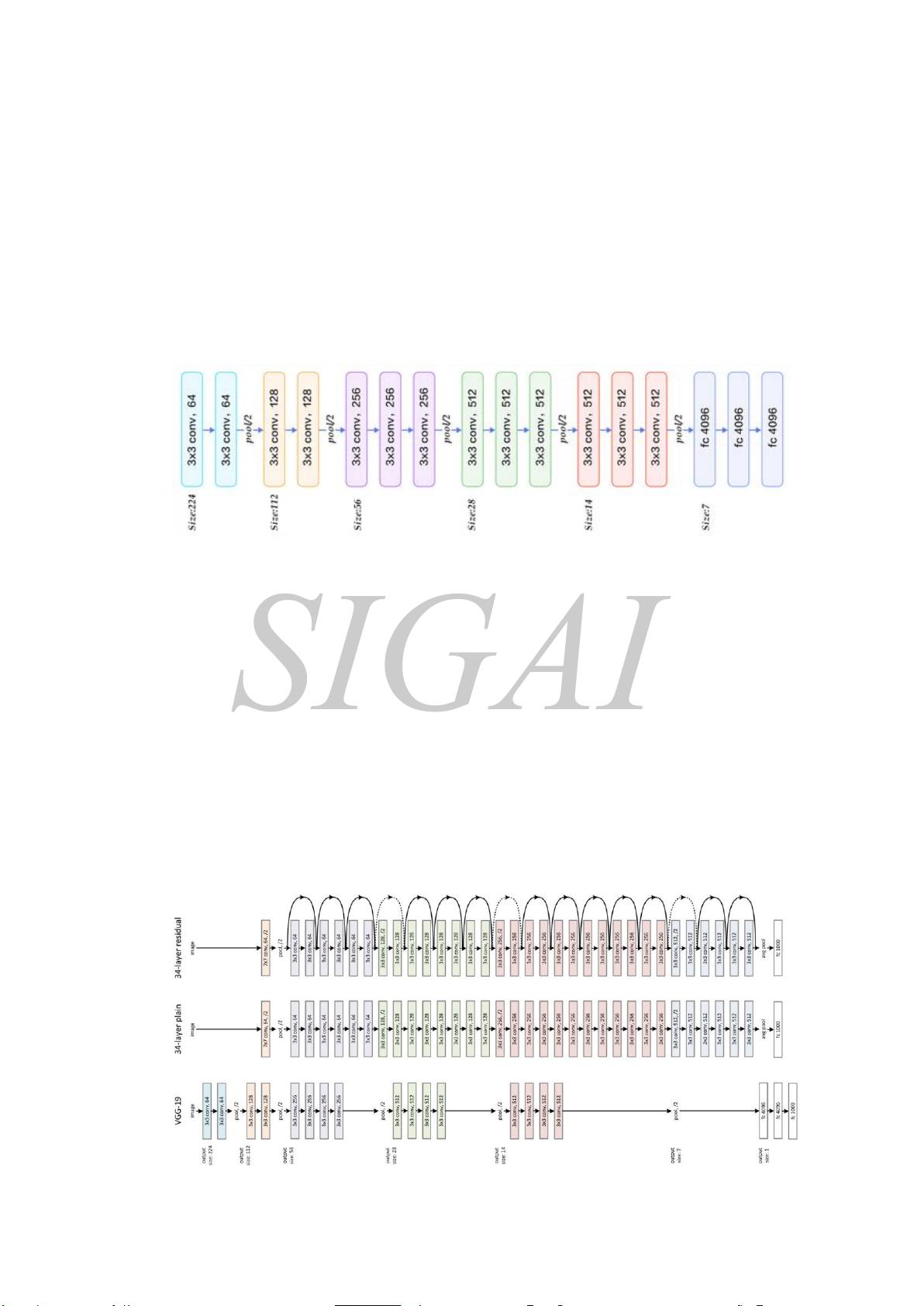

自AlexNet在2012年的ImageNet比赛中大放异彩以来,卷积神经网络经历了深度、宽度以及池化策略的不断扩展,如VGGNet的深而宽,GoogLeNet的Inception模块,以及ResNet的残差连接等。此外,批量标准化、dropout和数据增强等技术也极大地提升了模型的性能和泛化能力。

近年来,卷积神经网络在诸如物体检测、语义分割、图像生成、语音识别等领域取得了突破性进展,如YOLO(You Only Look Once)在实时物体检测上的高效,以及Transformer在自然语言处理中的革命性影响。同时,研究者还在探索更深层次的结构创新,如注意力机制和自注意力网络,以更好地捕捉复杂的数据依赖关系。

卷积神经网络的发展历程是一个不断演进的过程,从最初的简单模型到如今能够处理大规模、高维度数据的复杂网络,CNN已经成为了人工智能和机器学习领域的基石。SIGAI的文章全面回顾了这一历程,深入探讨了关键的理论进步和结构改进,对于理解卷积神经网络的原理及其在各领域的实际应用具有重要意义。

617 浏览量

906 浏览量

415 浏览量

385 浏览量

145 浏览量

141 浏览量

2021-09-26 上传

SIGAI_csdn

- 粉丝: 2352

最新资源

- 掌握PerfView:高效配置.NET程序性能数据

- SQL2000与Delphi结合的超市管理系统设计

- 冲压模具设计的高效拉伸计算器软件介绍

- jQuery文字图片滚动插件:单行多行及按钮控制

- 最新C++参考手册:包含C++11标准新增内容

- 实现Android嵌套倒计时及活动启动教程

- TMS320F2837xD DSP技术手册详解

- 嵌入式系统实验入门:掌握VxWorks及通信程序设计

- Magento支付宝接口使用教程

- GOIT MARKUP HW-06 项目文件综述

- 全面掌握JBossESB组件与配置教程

- 古风水墨风艾灸养生响应式网站模板

- 讯飞SDK中的音频增益调整方法与实践

- 银联加密解密工具集 - Des算法与Bitmap查看器

- 全面解读OA系统源码中的权限管理与人员管理技术

- PHP HTTP扩展1.7.0版本发布,支持PHP5.3环境