深度学习驱动的文本生成技术

需积分: 10 134 浏览量

更新于2024-07-17

收藏 9.81MB PDF 举报

"这篇资源是关于深度学习在文本生成中的应用,使用了开源的tf-seq2seq框架训练一个字符到字符的模型,处理E2E NLG Challenge数据集。模型不进行词汇化、小写转换或分词,输入语义直接是字符序列。根据人类评估,模型产生的输出语法完美,不会生成非单词内容。教程涵盖了文本生成的重要性、深度学习的应用,以及从不同意义表示到文本生成的过程。"

深度学习在文本生成中的应用是近年来自然语言处理领域的热点之一。通过利用如tf-seq2seq这样的深度学习框架,可以训练模型从输入数据(例如E2E NLG Challenge的数据)中学习复杂的模式,并生成连贯、准确的文本。在这个特定的例子中,模型直接处理原始的字符序列,而不是预处理过的词汇或词组,这有助于保持原文的语义完整性。

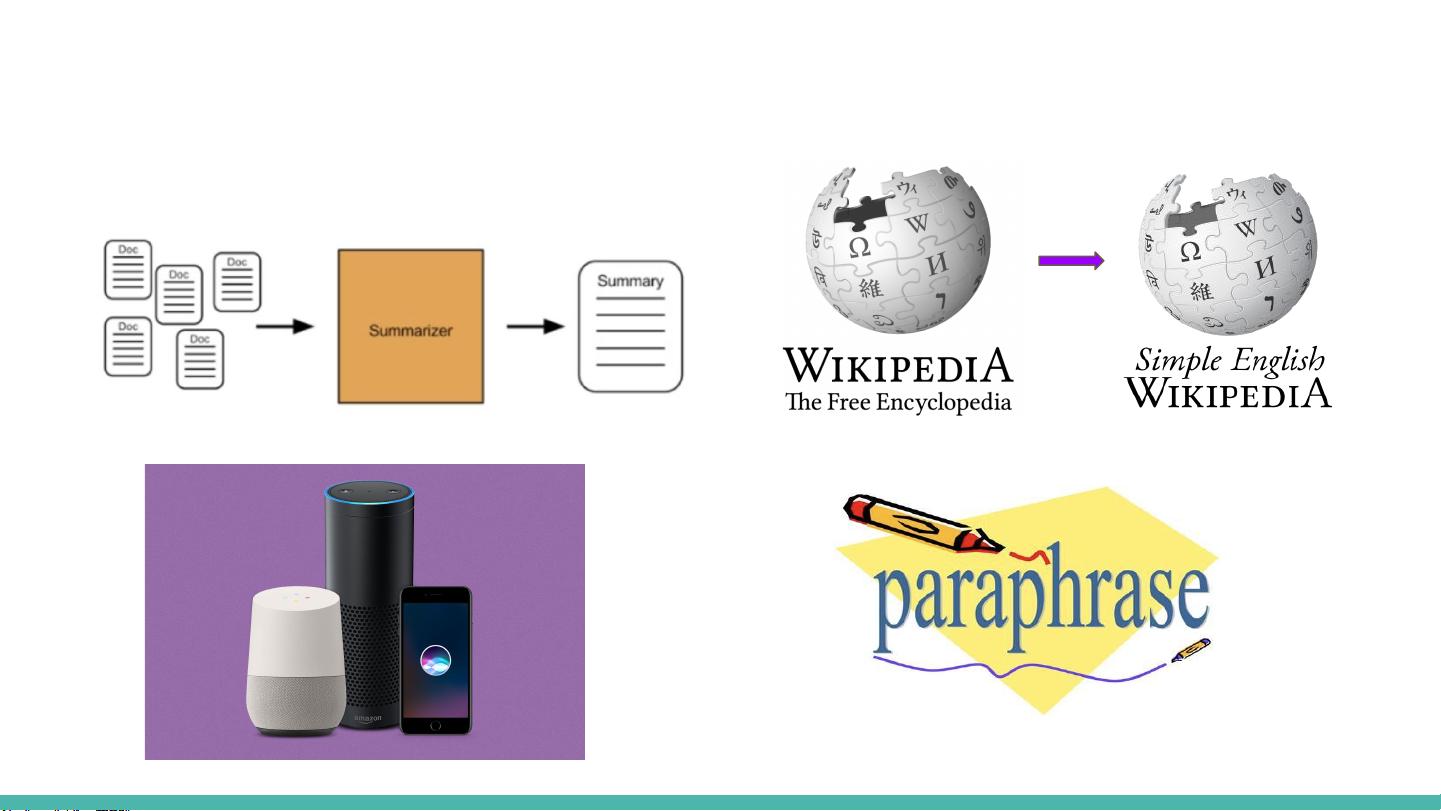

文本生成的目的是多样的,包括但不限于响应、总结和简化信息。它可以将数据库、知识库、对话行为等信息转化为可读的句子或文档。例如,对于对话系统,模型需要理解输入的语境(如对话行为),并生成合适的回应;在文本摘要中,模型则需要从长篇文档中提取关键信息,生成精炼的概括。

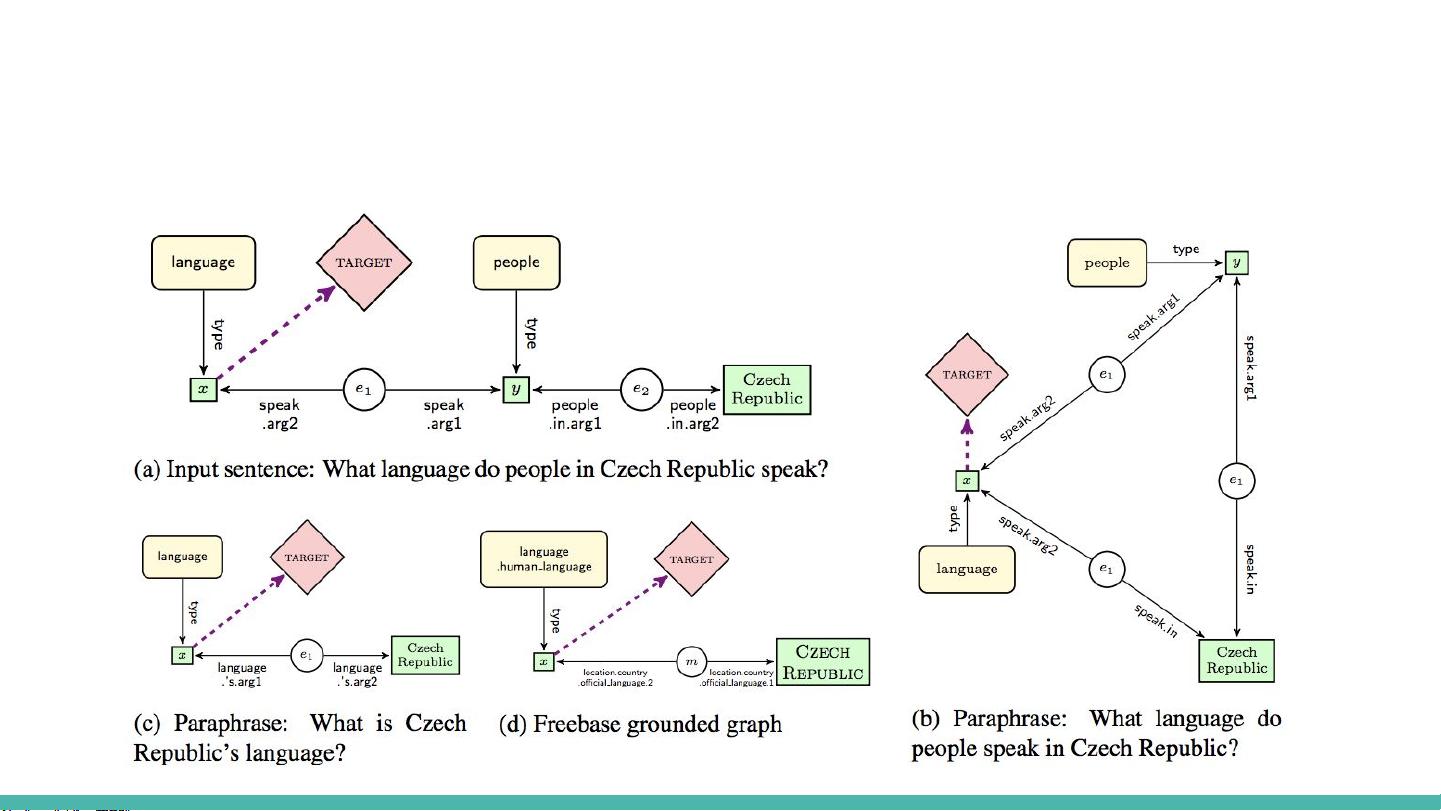

在从意义表示到文本生成的过程中,不同的表示方式有其独特的优势。依赖树可以捕捉句子的结构信息,适用于表面实现,即从结构信息生成实际的文本,但这也涉及到表面实现挑战,需要处理各种语法和词汇问题。抽象意义表示(AMR)则更注重语义,提供了独立于具体语言的表达,适用于跨语言的任务,如SemEval Shared Task 2017中的AMR生成和解析。

深度学习方法在这些任务中表现出色,能够学习到从底层表示到高级语义的映射。浅层方法可能只能解决表面结构问题,而深层神经网络则能捕获更复杂的语义关系。例如,通过递归神经网络或者Transformer架构,模型可以处理长距离依赖,并生成更加自然的语言。

这篇资源强调了深度学习在处理文本生成任务时的强大能力,以及如何利用不同的意义表示来提升生成文本的质量和准确性。它不仅展示了技术的实际应用,也提出了未来研究的方向,如如何更好地构建和利用意义表示,以及如何进一步优化深度学习模型以提高生成文本的多样性和创新性。

2018-03-12 上传

2018-04-04 上传

2020-03-12 上传

2023-09-16 上传

2023-04-03 上传

2023-06-02 上传

2023-05-14 上传

2023-03-22 上传

2023-03-30 上传

2023-06-09 上传

丁建睿

- 粉丝: 0

- 资源: 13