"MoE混合专家模型技术:AI前沿系列分析报告"

需积分: 0 149 浏览量

更新于2024-03-11

1

收藏 2.93MB PDF 举报

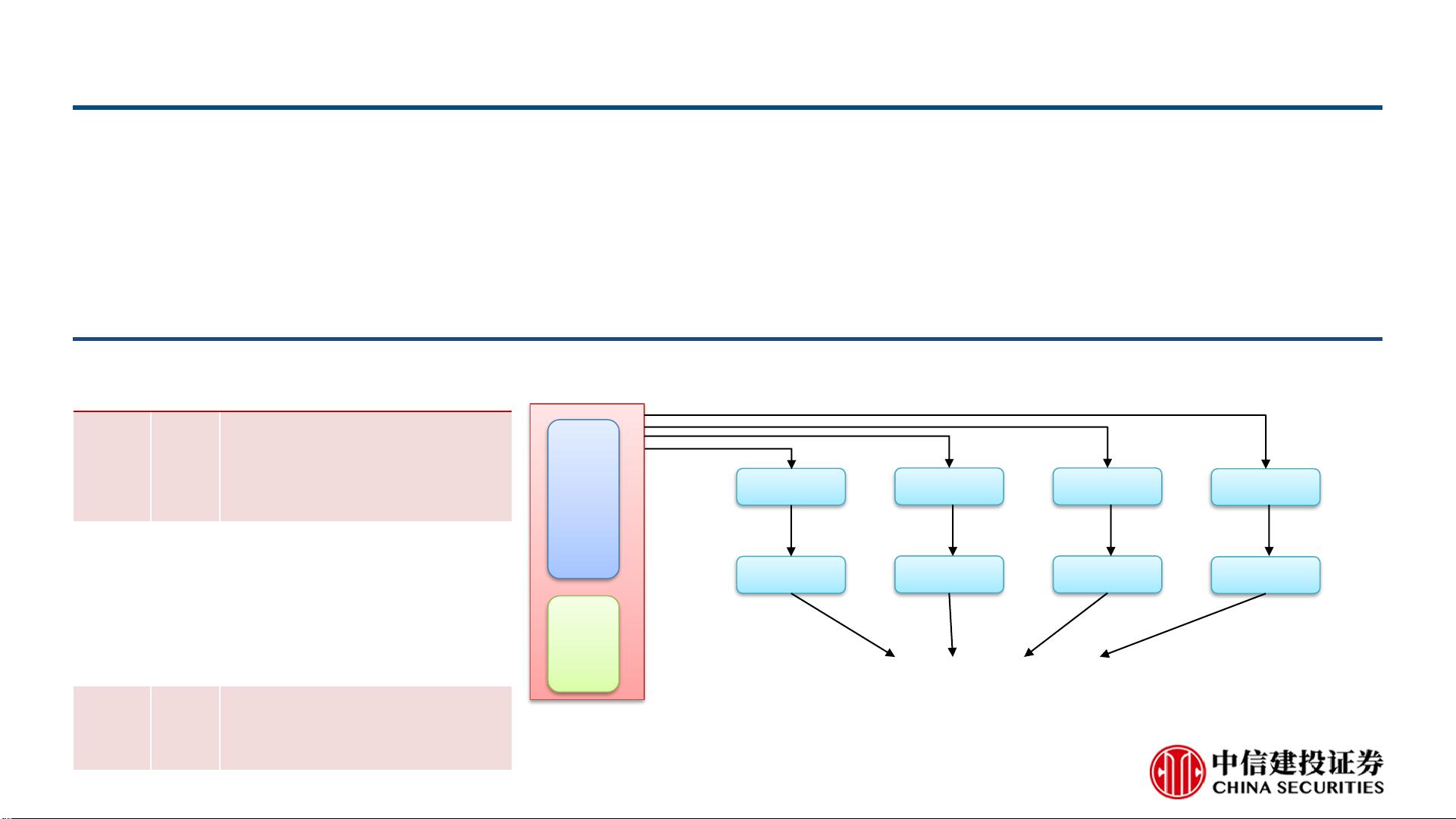

本报告详细介绍了混合专家模型技术(MoE)在计算机行业中的应用和发展。混合专家模型技术是一种由专家模型和门控模型组成的稀疏门控制深度学习技术。通过门控网络实现任务/训练数据在不同专家模型间的分配,让每个模型专注处理其最擅长的任务,进而实现模型的稀疏性。随着大模型参数量的持续提升,MoE在提升计算效率方面展现出强大的能力。同时,MoE逐渐与不同领域的模型相结合,包括自然语言、图像、推荐系统等领域。

MoE技术的核心观点是基于专家模型和门控模型的深度学习技术。专家模型是指针对特定任务或领域进行专门优化的模型,而门控模型则负责动态调整任务/训练数据在不同专家模型间的分配。这样,每个专家模型都能够专注处理其最擅长的任务,从而提高模型的性能和效率。

在近年来,MoE技术在计算机行业取得了显著的发展。随着人工智能技术的不断进步,大模型参数量的持续提升已成为一个普遍的趋势。而MoE技术正是针对这一趋势而生,能够有效提升大模型的计算效率。与传统的单一模型相比,MoE技术能够通过稀疏门控实现对计算资源的最大化利用,从而在处理大规模数据和复杂任务时具有显著的优势。

除了在计算效率方面的优势,MoE技术还在不同领域的模型相结合方面有着广阔的应用前景。在自然语言处理领域,MoE技术能够有效提高文本生成、机器翻译等任务的性能和效率;在图像识别领域,MoE技术则有望实现更精准的图像识别和分析;在推荐系统领域,MoE技术也能够帮助提升个性化推荐的准确性和效率。

总的来说,MoE技术作为一种新兴的深度学习技术,具有着广泛的应用前景和巨大的市场潜力。随着人工智能技术的不断发展和普及,MoE技术有望在未来成为人工智能领域的重要技术之一,为各种复杂任务和大规模数据的处理提供有效的解决方案。在未来的发展中,我们有理由相信,MoE技术将会在计算机行业以及其他领域发挥出越来越重要的作用,带来更多的技术创新和商业应用。

238 浏览量

264 浏览量

274 浏览量

2025-02-19 上传

1725 浏览量

640 浏览量

128 浏览量

111 浏览量

Shawshank.

- 粉丝: 4

最新资源

- 微信小程序开发教程源码解析

- Step7 v5.4仿真软件:s7-300最新版本特性和下载

- OC与HTML页面间交互实现案例解析

- 泛微OA官方WSDL开发文档及调用实例解析

- 实现C#控制佳能相机USB拍照及存储解决方案

- codecourse.com视频下载器使用说明

- Axis2-1.6.2框架使用指南及下载资源

- CISCO路由器数据可视化监控:SNMP消息的应用与解析

- 白河子成绩查询系统2.0升级版发布

- Flutter克隆Linktree:打造Web应用实例教程

- STM32F103基础之MS5单片机系统应用详解

- 跨平台分布式Minecraft服务端:dotnet-MineCase开发解析

- FileZilla FTP服务器搭建与使用指南

- VB洗浴中心管理系统SQL版功能介绍与源码分析

- Java环境下的meu-grupo-social-api虚拟机配置

- 绿色免安装虚拟IE6浏览器兼容Win7/Win8