变尺度支持向量回归:理论与应用

版权申诉

92 浏览量

更新于2024-07-02

收藏 1.43MB PDF 举报

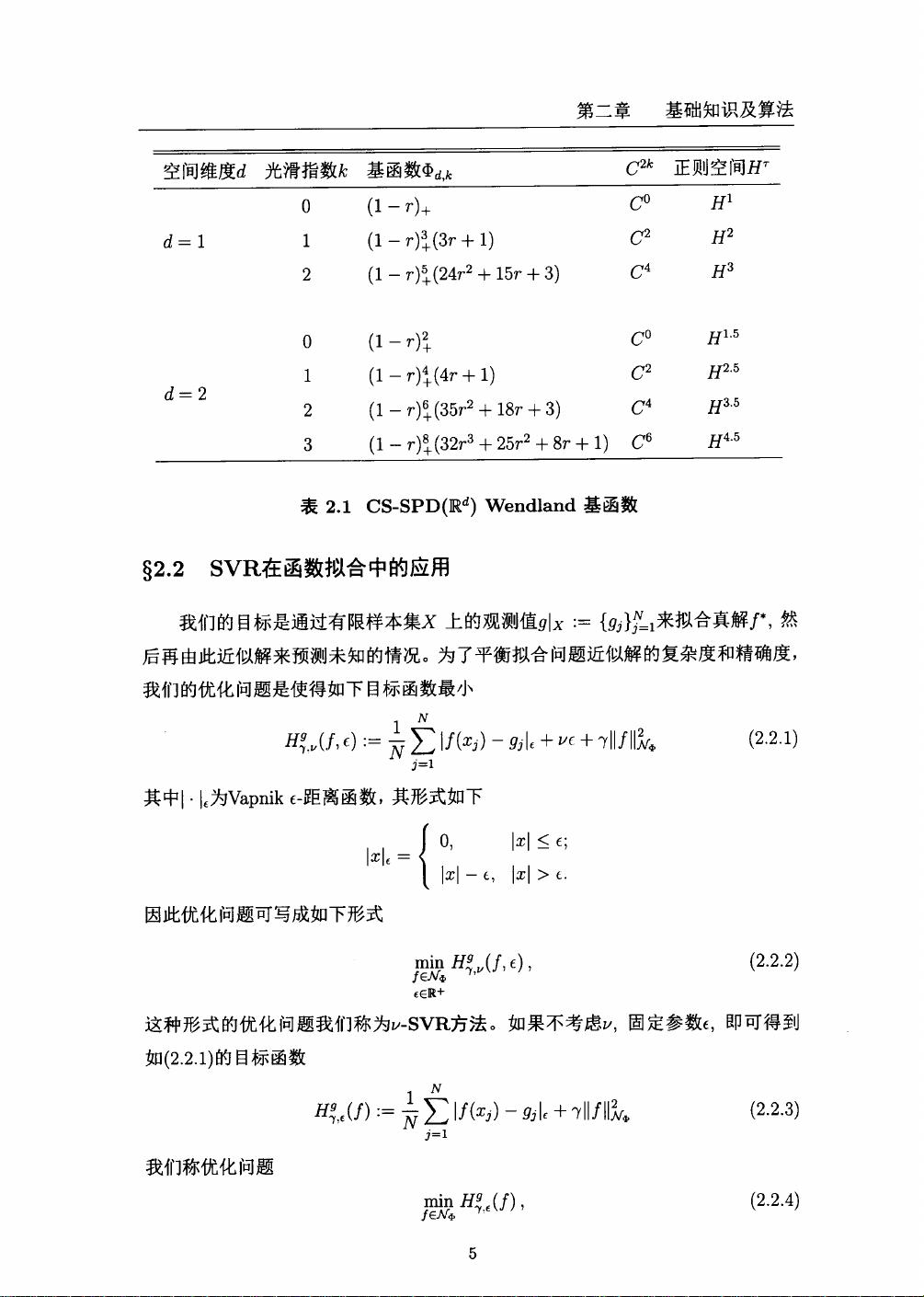

变尺度支持向量回归算法(Varying-scale Support Vector Regression, V-SVR)是一种强大的机器学习工具,特别是在处理非线性和高维数据的回归问题时。本文深入探讨了在Sobolev空间有界区域上利用径向基函数(Radial Basis Functions, RBFs)进行函数拟合的方法。Sobolev空间是一种数学框架,它考虑了函数的局部平滑性,这对于许多实际应用中的复杂函数建模非常关键。

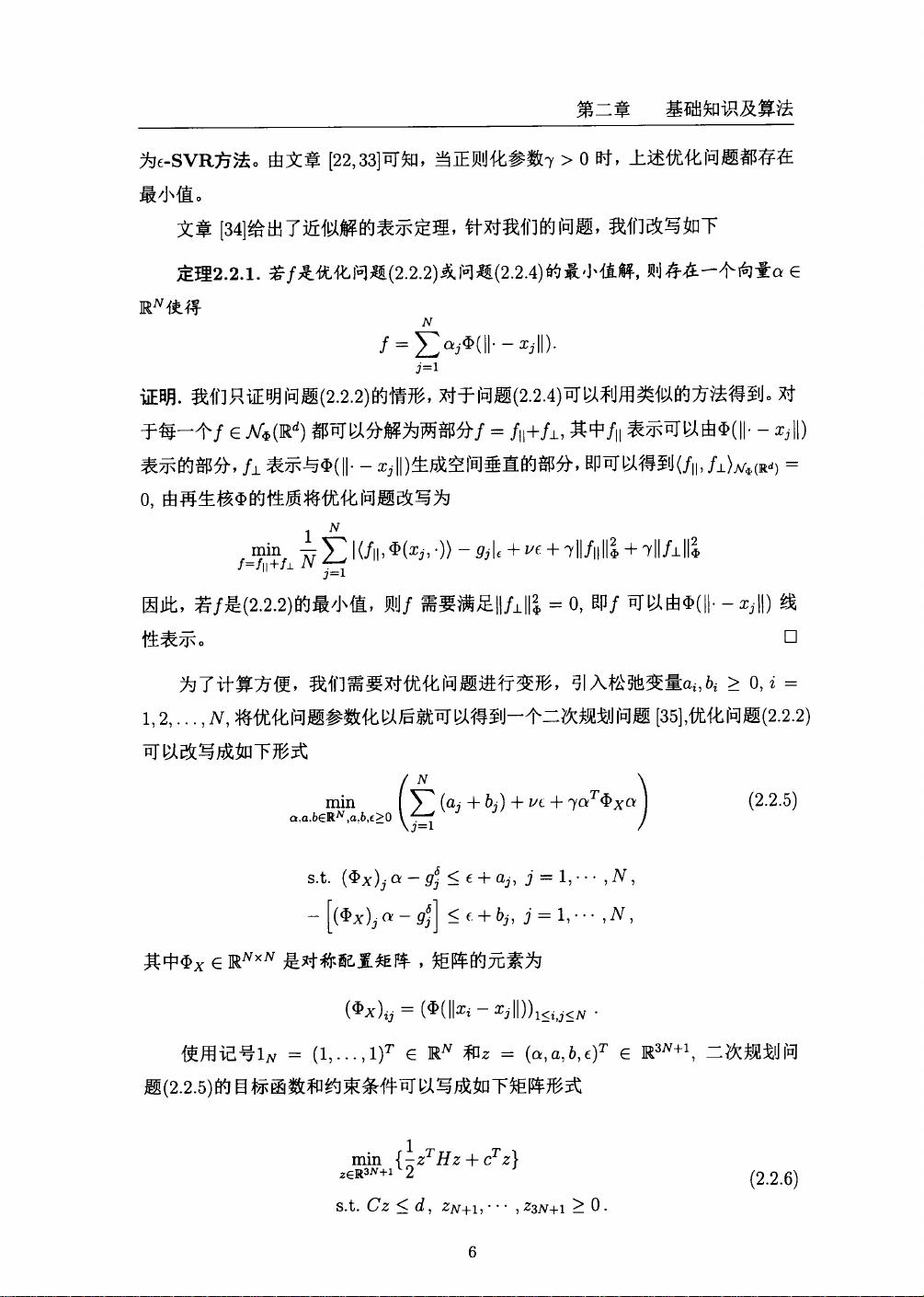

V-SVR算法的关键在于其适应性强,可以拟合任意维度和不同光滑程度的函数,这使得它在处理具有不确定性和噪声的数据集时展现出优越的性能。文章首先介绍了基本的E-SVR(epsilon-SVR),这是一种带有ε-内核宽度的选择策略的支持向量回归,它在噪声数据的处理中具有良好的泛化能力。

在本文中,作者进一步发展了变尺度E-SVR,通过调整数据的尺度,使得算法能够更好地适应输入特征的变化范围。这种变尺度方法有助于减少噪声的影响,提高模型的稳定性和准确性。此外,文章还扩展了这一概念到变尺度∥-SVR,这里的“∥”可能指的是某种度量或正则化项,旨在进一步优化模型的性能。

作者证明了变尺度E-SVR和变尺度∥-SVR在带噪声的非光滑函数拟合中的收敛性,即随着算法的迭代,模型能够逐渐接近真实函数,即使在存在噪声的情况下也能达到近似最优解。这是对算法稳健性和有效性的重要理论支撑。

数值例子部分是验证这些理论结果的重要环节,通过具体的实例分析,展示了变尺度∥-SVR在实际应用中的优异表现,证明了其对数据尺度变化的鲁棒性和对不同函数复杂性的适应性。结论部分可能会总结算法的优势,提出未来研究的方向,如如何进一步改进算法的效率或者扩展到其他类型的机器学习任务。

变尺度支持向量回归算法是一种创新的回归技术,它通过变尺度方法和径向基函数的优势,有效地解决了数据回归中的诸多挑战。对于从事数据科学、机器学习以及信号处理等领域的人来说,理解和掌握这一算法及其理论基础至关重要,因为它能提升预测精度,增强模型的鲁棒性,尤其在处理复杂数据集时有着显著的优势。

2022-06-25 上传

2021-11-16 上传

2021-07-14 上传

2021-10-15 上传

2024-07-16 上传

2021-09-26 上传

2021-09-25 上传

2022-06-24 上传

2021-09-29 上传

programxh

- 粉丝: 17

- 资源: 1万+

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载