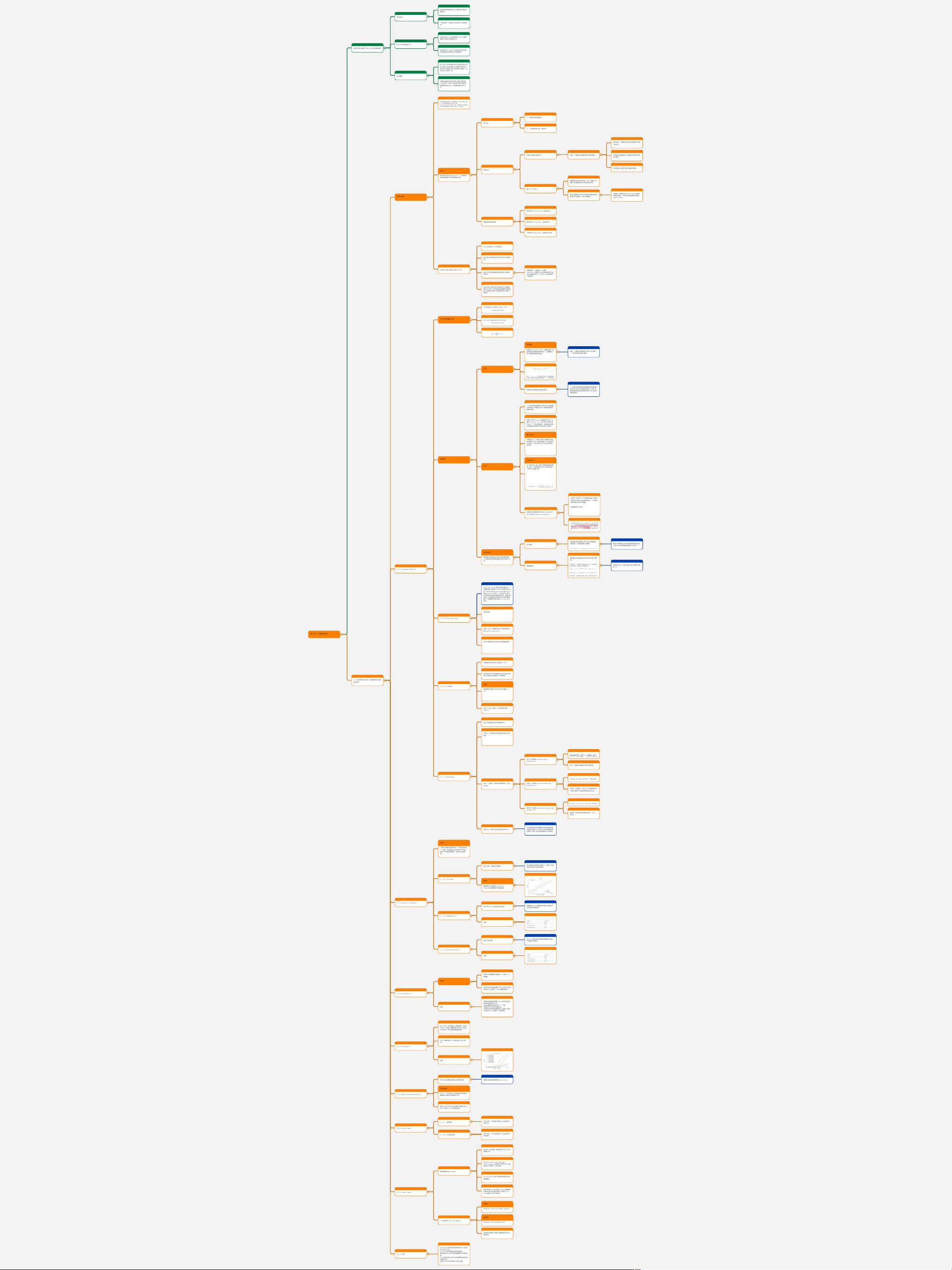

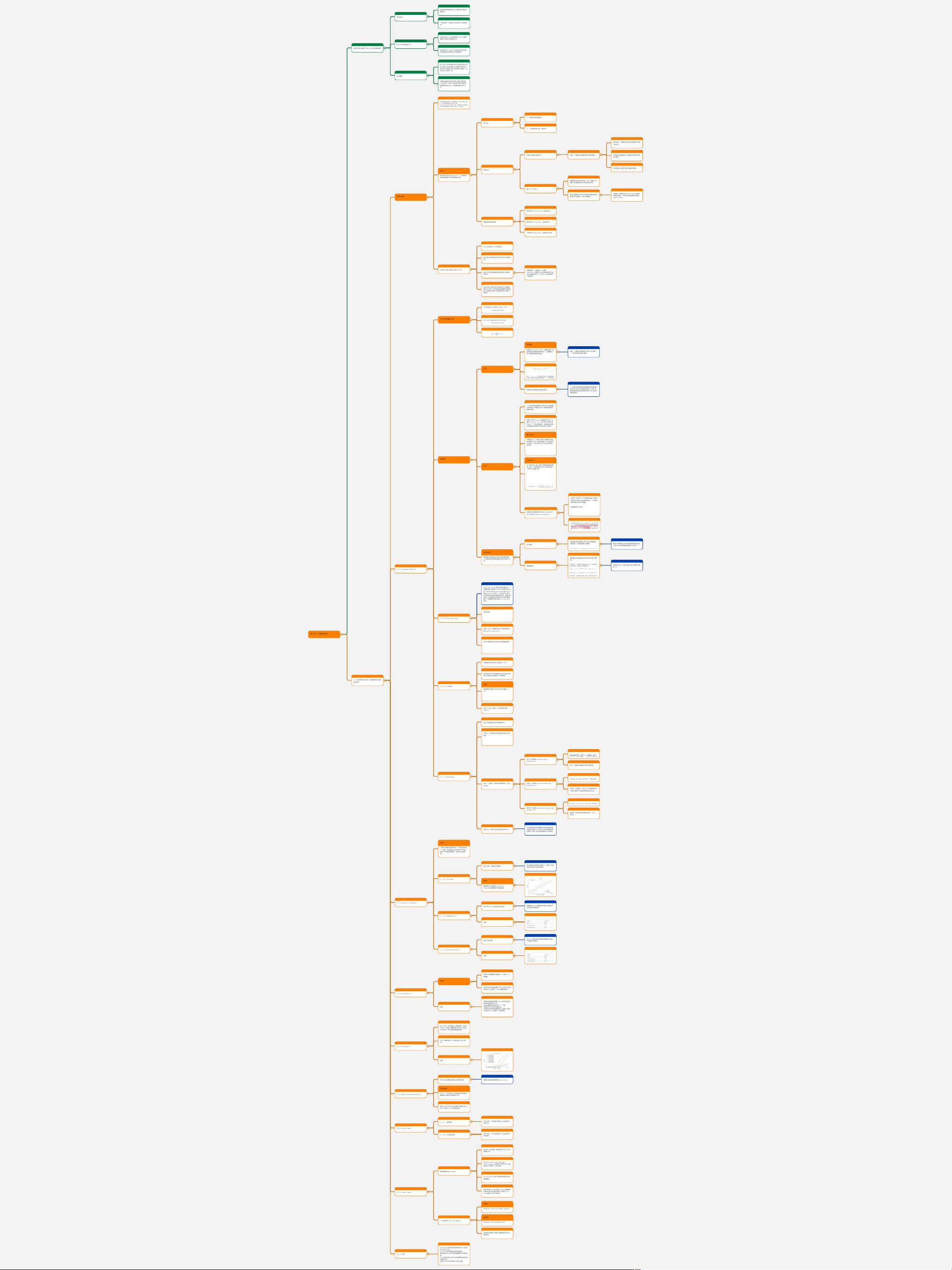

第⼆章:⼤模型的能⼒

我们的研究主要基于GPT-3论⽂中的基准测试

1

测试包括

1

标准的⾃然语⾔处理(NLP)基准测试,例如问

题回答;

1

⼀些特殊的⼀次性演示,例如在句⼦中使⽤新

词。

1

GPT-3的结果参差不⻬:

1

在某些任务上,⽐如语⾔建模,GPT-3⼤幅度

超越了现有技术的最⾼⽔平;

1

在其他任务上,GPT-3与训练有素,拥有⼤量

标签数据的系统竞争时,却明显落后。

1

如何理解

1

由于GPT-3并未特别针对任何这些任务进⾏训

练,因此它并未过度拟合,意味着它有很⼤的

潜⼒在许多其他任务上表现良好(就像在⼀次

性任务上的表现⼀样)。

1

如果你希望在任何特定任务(例如问题回答)

上表现良好, 原则上你应能够利⽤⼤量的标

签数据来适应GPT-3,并超越当前的技术⽔

平。

1

2.1 语⾔模型的适应性:从语⾔模型到任务模

型的转化

2

测试说明

2

适应

我们使⽤“适应(Adaptation)”⼀词来指代

将语⾔模型转化为任务模型的过程。

2

两个输⼊

2

1. 任务的⾃然语⾔描述

2

2. ⼀组训练实例(输⼊-输出对)

2

两种⽅式

2

训练(标准的有监督学习)

2

训练⼀个新模型,使其能将输⼊映射到输出。

2

通过创建⼀个新模型并利⽤语⾔模型作为特征

(探针法),

2

从现有的语⾔模型出发,根据训练实例进⾏更

新(微调),

2

在这两者之间找到平衡(轻量级的微调)。

2

提示(上下⽂学习)

2

根据描述和训练实例构建⼀个或⼀组提示,将

其输⼊到语⾔模型中以获取完成的序列。

2

提示的局限性在于我们只能利⽤少量的训练实

例(最多只能塞进⼀个提示的数量)。

3

这种输⼊的局限性由于Transformer⾃身的

局限性导致的, 其中提示和完成都必须适应

2048个tokens。

3

根据训练实例的数量

2

零样本学习(Zero-shot):训练样本为0

2

单样本学习(One-shot):训练样本为1

2

少样本学习(Few-shot):训练样本为少数

3

对于每个任务,我们会讨论以下⼏点:

3

定义:任务是什么,以及其动机?

3

适应:我们如何通过提示将任务简化为语⾔模

型?

3

结果:与任务特定的最先进模型相⽐,数量性

能如何?

3

结果将基于: 完整的GPT-3模型

(davinci),其拥有1750亿参数使⽤尽可能

多的训练实例进⾏上下⽂学习,这些实例都可

以塞进提示。

3

在此过程中,我们将进⾏消融实验,以查看模

型的⼤⼩和上下⽂训练实例的数量是否真的重

要。⽽结果告诉我们,答案是肯定的,更多总

是更好。

3

2.1.1 Language Modeling

4

词汇序列概率分布

4

4

4

困惑度

定义

困惑度

困惑度(Perplexity)是⼀个重要的指标,是

⾃然语⾔处理和语⾔模型中的⼀个重要概念,

⽤于衡量语⾔模型的性能。

4

模型在预测下⼀个词时的平均不确定性。

如果⼀个模型的困惑度较低,那么它在预测下

⼀个词的时候就会更加准确。

4

4

困惑度与语⾔模型的质量紧密相关。

5

⼀个优秀的语⾔模型应能准确预测测试数据中

的词序列,因此它的困惑度应较低。相反,如

果语⾔模型经常做出错误的预测,那么它的困

惑度将较⾼。

5

讨论

⼀个序列的联合概率取决于其⻓度,并且随着

⻓度的增⻓,其值趋近于零,这使得困惑度变

得难以追踪。

5

对每个词标记(token)的概率进⾏平均。这

⾥的 p(xi∣x1:i−1) 表示给定之前的词序

列后,下⼀个词出现的概率。这样做的⽬的是

评估模型在处理各种词标记时的平均性能。

5

算术平均

如果我们给⼀个词标记分配了0的概率(即我

们的模型认为这个词在特定的上下⽂中绝对不

可能出现),那么在算术平均中这会造成极⼤

的问题。

5

⼀个⾮常低的概率(如0)可能会被其他较⾼的

概率抵消。

⼏何平均

在⼏何平均中,每个词标记的概率都被同等看

待,并且⼀个极低的概率(如0)将会导致整个

⼏何平均⼤幅度下降。

5

更好地衡量模型在处理所有可能的词标记时的

性能,特别是在处理那些模型可能会出错的情

况。

这就是困惑度(perplexity)所做的。

困惑度可以被理解为每个标记(token)的平

均"分⽀因⼦(branching factor)"。

5

这⾥的"分⽀因⼦",可以理解为在每个特定的

词或标记出现后,语⾔模型预测下⼀个可能出

现的词或标记的平均数量。

5

如树模型的分⽀节点

实际上是度量模型预测的多样性和不确定性的

⼀种⽅式。

6

两类错误

两类错误:语⾔模型可能会犯两种类型的错

误,⽽困惑度对这两种错误的处理⽅式并不对

称:

6

召回错误

6

语⾔模型未能正确地为某个词符分配概率值。

这种情况下,困惑度是毫不留情的。

6

例如,如果模型为词组出现的概率预测为接近

0,那么对应的困惑度值将趋近于⽆穷⼤。

6

精确度错误

6

语⾔模型为某些错误的词序列过度分配了概率

值。

6

如果我们混⼊5%的垃圾信息,那么困惑度只增

加 5%。

7

2.1.1.1 Penn Tree Bank

7

Penn Tree Bank 是⾃然语⾔处理中的⼀个

经典数据集,最初是为了进⾏句法解析⽽标注

的。从Emami和Jelinek(2004)和Mikolov

和Zweig(2012)开始,⼀个只包含华尔街⽇

报⽂章的版本被⽤作语⾔模型评估。需要注意

的是,PTB语⾔模型基准测试涉及对原始数据

集的⼀些重要预处理(感谢John Hewitt的

指出)。

7

适应性测试

7

将整个⽂本作为提示输⼊到GPT-3中,并评估

其困惑度

结果: GPT-3⼤幅度的超过了⽬前的最好结

果(state-of-the-art)

7

那这个结果是否存在训练/测试泄露问题呢?

8

数据泄露是当前⼤型数据集的另⼀个复杂问

题:很难检查你的测试数据是否出现在你的训

练数据中,并被记忆下来。

2.1.1.2 LAMBADA

8

该数据的任务:预测句⼦的最后⼀个词。

8

动机:解决这个任务需要对较⻓的内容进⾏建

模,并对较⻓的内容具有⼀定的依赖。

8

问题

语⾔模型不知道它应该⽣成句⼦的最后⼀个

词。

8

需要更明确地将其构建为输⼊-输出映射,并

使⽤额外的示例进⾏上下⽂学习

结果:**GPT-3超过了v之前的最好结果

(GPT-2)

9

2.1.1.3 HellaSwag

9

动机:评估模型进⾏常识推理的能⼒

9

任务:从⼀系列选择中选出最适合完成句⼦的

选项

9

多项选择任务,所以最⾃然的做法是⽤语⾔模

型为每个候选答案打分,并预测“最佳”答案

给定⼀个问题 x,你如何对候选答案 y 进⾏

评分呢?

10

未归⼀化的概率(Unnormalized

probability)

10

10

未归⼀化概率的问题是它倾向于短答案。

10

⻓度归⼀化概率(Length-normalized

probability):

10

10

这修正了⻓度偏⻅。然⽽,对于⻓度相同的两

个答案,模型仍可能偏好更受欢迎的实体。

10

频率归⼀化概率(Frequency-normalized

probability)

10

10

这降低了恰巧很常⻅的答案(例如,“John”)

的得分。

10

结果:GPT-3接近但没有超过最先进的⽔平:

10

SOTA结果是在该数据集的训练集中微调得到

的结果,因此GPT-3在完全不在该数据集训练

的情况下获得了接近的结果是很令⼈惊喜的。

11

2.1.2 Question answering

11

任务

(闭卷)问答题,其中输⼊是⼀个问题,输出是

⼀个答案。语⾔模型必须以某种⽅式“知道”

答案,⽽⽆需在数据库或⼀组⽂档中查找信

息。

11

2.1.2.1 TriviaQA

11

任务:给定⼀问题后⽣成答案

11

我们根据训练实例和问题定义⼀个提示,并将

完成的内容作为预测的答案:

11

结果

增加模型⼤⼩和增加in-context

training实例都有助于提⾼性能:

4

5

2.1.2.2 WebQuestions

12

任务:和TriviaQA类似是问答任务

12

数据集从Google搜索查询中收集,最初⽤于

对知识库的问题回答。

12

结果

12

13

2.1.2.3 NaturalQuestions

13

任务:回答问题

13

从Google搜索查询中收集的数据集(区别在

于答案的⻓度较⻓)

13

结果:

13

13

2.1.3 Translation

13

任务

标准的评估数据集⽐如是WMT’14和WMT’16

数据集。

14

由于存在多种可能的翻译,所以(⾃动)评估指

标是BLEU(它捕获了n-gram重叠的概念)。

14

结果

14

即使没有监督训练数据,GPT-3也能达到全监

督系统的最新技术⽔平!

这为机器翻译的性能设定了⼀个下限。

法语和罗⻢尼亚语的结果类似。

从英语到外语的结果要差得多,这是可以预料

的,因为GPT-3主要是⼀个英语模型。

14

2.1.4 Arithmetic

15

GPT-3是⼀个语⾔模型(主要是英语),但我们

可以在⼀系列更“抽象推理”的任务上评估它,

以评估GPT-3作为更通⽤模型的性能。

15

任务:做算术题(2-5位数的加法,减法,乘

法)

15

结果

15

6

2.1.5 News article generation

15

任务:给定标题和副标题,⽣成新闻⽂章。

15

数据集:标题/副标题取⾃newser.com。

15

评估标准

设⽴了⼀个评估标准,⼈类根据⽂章可能由机

器编写的可能性对⽂章进⾏评分。

15

结果:⼈类只有52%的时间能够正确地分类“⼈

类”与“机器”(⼏乎只是随机机会)。

16

2.1.6 Novel tasks

16

2.1.6.1 使⽤新词

16

任务:给定⼀个新造的词和定义,⽣成使⽤该

词的句⼦。

16

2.1.6.2 纠正英语语法

16

任务:给定⼀个不合语法的句⼦,⽣成其合语

法的版本。

17

2.1.7 Other tasks

17

基准数据集(Benchmark)

17

SWORDS:词汇替换,⽬标是在句⼦的上下⽂中

预测同义词。

17

Massive Multitask Language

Understanding:包括数学,美国历史,计算

机科学,法律等57个多选问题。

17

TruthfulQA:⼈类由于误解⽽错误回答的问

答数据集。

18

结果:虽说GPT-3在这些Benchmark数据集中

的表现平庸,但是考虑到我们只使⽤了few-

shot的情况,或许不算太差。

18

⼀次性的演示(one-off deoms)

18

链接①

Examples from the OpenAI website

18

链接②

Examples from gpt3demo.com

18

这些演示既创新⼜有趣,但很难判断它们的可

靠性如何。

18

2.1.8 总结

18

GPT-3在⼴泛的标准NLP基准测试和⼀次性任

务上进⾏了评估。

GPT-3可以表现得极好或者⾮常普通。

增加模型的⼤⼩和示例的数量都有助于提⾼性

能。

有⼀些启发式的⽅法可以将语⾔模型适应到感

兴趣的任务。

但是为什么会有这样表现,没有⼈知道。

18