模型评估与选择:留出法、交叉验证与性能度量

需积分: 0 114 浏览量

更新于2024-08-05

收藏 15.29MB PDF 举报

"模型评估与选择的学习笔记,包括留出法、交叉验证、留一法、自助法等训练验证策略以及性能度量如错误率、精度、查准率、查全率和F1分数的介绍"

在机器学习领域,模型评估与选择是至关重要的步骤,它确保我们选择的模型能够在未知数据上表现良好。本笔记主要涵盖了模型选择和评估的几种常用方法。

首先,留出法是一种简单直接的数据集划分方法,通常将数据集分为训练集和验证集两部分。例如,按照70%:30%的比例划分,70%用于模型训练,剩余30%用作验证,以评估模型的性能。在划分时需要注意保持训练集和验证集间数据分布的一致性,避免由于划分引入的偏差影响评估结果。

其次,交叉验证是一种更为严谨的评估方式,特别是k折交叉验证。数据集被均匀划分为k个子集,每次用k-1个子集训练模型,剩下的一个子集用于验证。这个过程重复k次,每个子集都被用作一次验证,最后取k次结果的平均值作为模型性能的估计。留一法是交叉验证的特例,当k等于数据集大小m时,每个样本都单独构成一次验证,虽然这种方法理论上最精确,但在大数据集上会非常耗时。

为了克服训练集规模减小和实验效率低下的问题,提出了自助法。这种方法通过自助采样创建一个与原始数据集大小相同的新的训练集,每次采样后都将样本放回,确保样本有概率在多次采样中被选中。大约有36.8%的样本不会出现在采样集中,这部分未被选中的样本组成验证集。

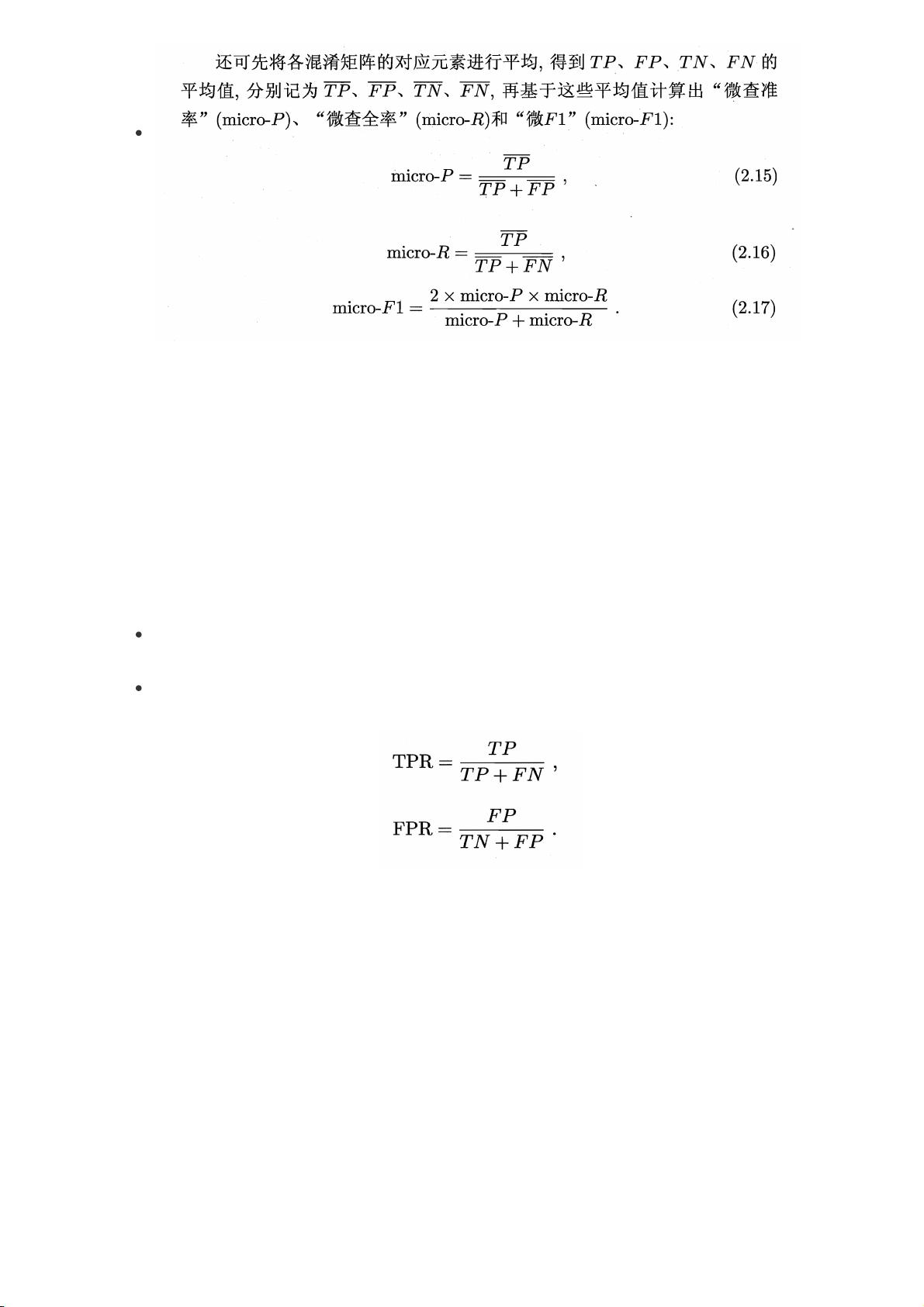

在评估模型性能时,我们通常会使用各种性能度量。例如,在回归任务中,均方误差是最常用的指标,它衡量了预测值与真实值之间的差异。对于分类任务,错误率和精度是基本的度量标准,它们分别反映了模型错误预测的比例和正确预测的比例。此外,查准率(Precision)和查全率(Recall)是评价二分类模型性能的重要指标,查准率表示预测为正类的样本中真正为正类的比例,查全率则表示所有正类样本中被正确预测的比例。查准率和查全率通常存在权衡关系,无法同时达到最优。为了综合考虑两者,F1分数被提出,它是查准率和查全率的调和平均数,提供了单一的性能度量。

在二分类任务中,可以通过混淆矩阵分析模型性能,它包含了真正例(True Positives)、假正例(False Positives)、真反例(True Negatives)和假反例(False Negatives)。基于这些指标,我们可以绘制查准率-查全率曲线(P-R曲线),以直观地比较不同模型的表现。

选择合适的模型评估方法和性能度量是优化模型的关键步骤。理解并熟练运用这些工具,可以帮助我们在实际项目中更好地训练和评估机器学习模型。

2022-08-03 上传

2022-08-03 上传

2022-08-03 上传

2021-05-20 上传

2022-05-06 上传

2021-05-27 上传

2023-09-02 上传

2009-07-06 上传

点击了解资源详情

晕过前方

- 粉丝: 729

- 资源: 328

最新资源

- ES管理利器:ES Head工具详解

- Layui前端UI框架压缩包:轻量级的Web界面构建利器

- WPF 字体布局问题解决方法与应用案例

- 响应式网页布局教程:CSS实现全平台适配

- Windows平台Elasticsearch 8.10.2版发布

- ICEY开源小程序:定时显示极限值提醒

- MATLAB条形图绘制指南:从入门到进阶技巧全解析

- WPF实现任务管理器进程分组逻辑教程解析

- C#编程实现显卡硬件信息的获取方法

- 前端世界核心-HTML+CSS+JS团队服务网页模板开发

- 精选SQL面试题大汇总

- Nacos Server 1.2.1在Linux系统的安装包介绍

- 易语言MySQL支持库3.0#0版全新升级与使用指南

- 快乐足球响应式网页模板:前端开发全技能秘籍

- OpenEuler4.19内核发布:国产操作系统的里程碑

- Boyue Zheng的LeetCode Python解答集