"Spark01基础解析:快速、通用、可扩展的大数据分析引擎概述"

需积分: 9 193 浏览量

更新于2024-01-05

收藏 6.74MB DOCX 举报

Spark是一种快速、通用、可扩展的大数据分析引擎,它诞生于2009年加州大学伯克利分校AMPLab,并于2010年开始开源。2013年6月,Spark成为Apache孵化项目,2014年2月则正式成为Apache顶级项目。

Spark项目是用Scala编写的,它的生态系统已经发展成为一个包含多个子项目的集合,其中包括SparkSQL、Spark Streaming、GraphX、MLib和SparkR等。作为基于内存计算的大数据并行计算框架,Spark不仅扩展了广泛使用的MapReduce计算模型,还高效地支持交互式查询和流处理等更多计算模式。

由于其速度、易用性和可靠性,Spark适用于各种不同场景,包括批处理、迭代算法、交互式查询和流处理等。通过在一个统一的框架下支持这些不同的计算,Spark使得我们可以将各种处理流程简单而低耗地整合在一起,这在实际的数据分析过程中具有重要意义。

Spark具有以下特点:

1. 高速性:由于Spark利用内存计算,大大减少了数据的磁盘读写,从而显著提升了计算速度。此外,Spark还支持数据的流式处理,使得实时计算成为可能。

2. 易用性:Spark提供了面向多种编程语言的API,包括Scala、Java、Python和R等,使得开发人员能够使用自己熟悉的编程语言进行开发。同时,Spark还提供了丰富的开发工具和资源,以便开发人员更加便捷地使用Spark进行大数据分析。

3. 可靠性:Spark具有高度的容错性,当其中一个节点发生故障时,Spark会自动将任务转移到其他节点上进行处理,保证了计算的可靠性和稳定性。

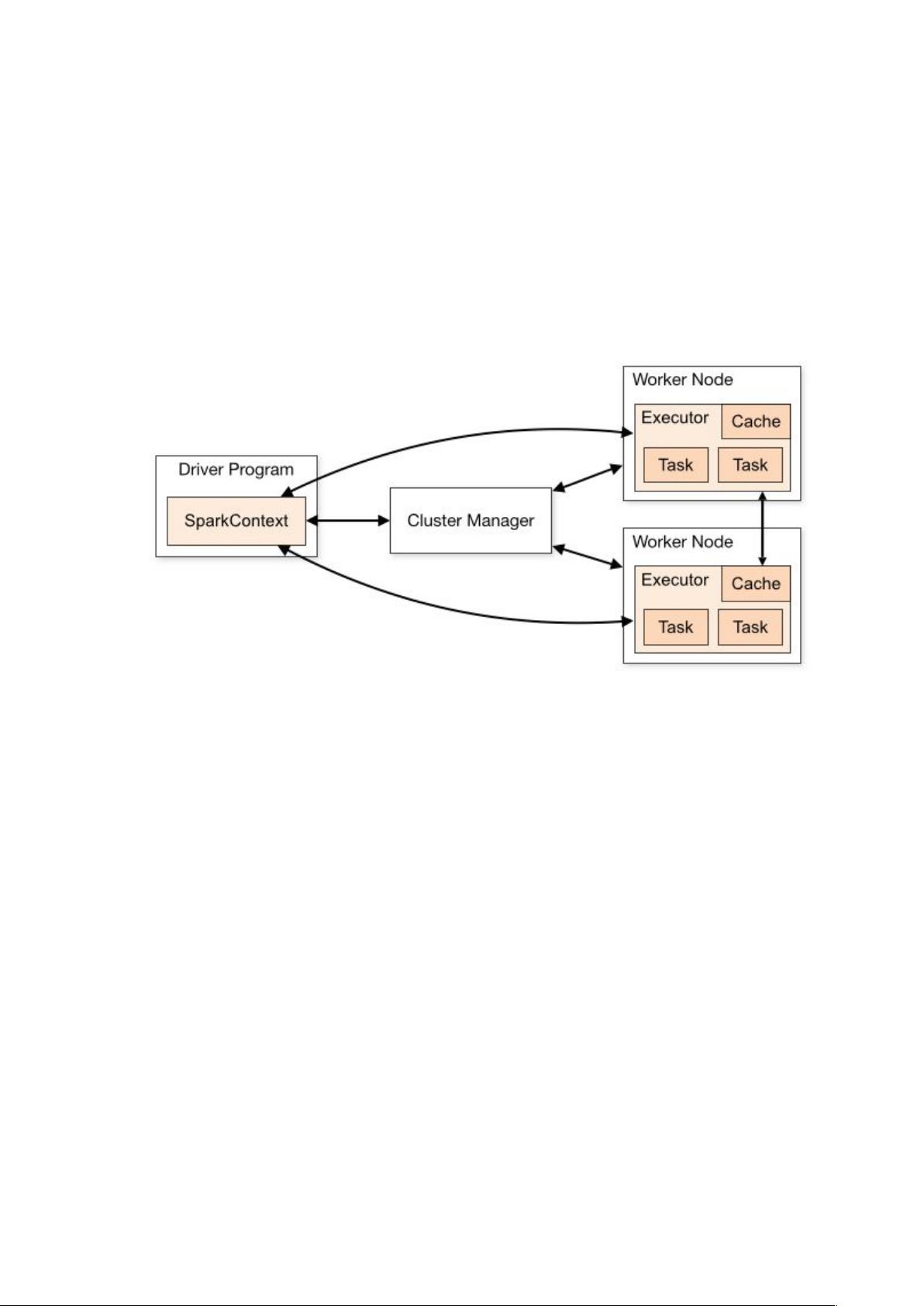

4. 扩展性:Spark的分布式架构使得它可以轻松地扩展到数以千计的节点上进行大规模的数据处理,从而满足了处理大规模数据的需求。

5. 多样性:Spark提供了多种不同的库和工具,包括SparkSQL、Spark Streaming、GraphX和MLib等,使得开发人员能够灵活地选择适合自己需求的工具进行数据分析和处理。

总之,Spark作为一种快速、通用、可扩展的大数据分析引擎,通过内存计算和支持多种计算模式的功能,使得数据分析变得更加高效、简单和灵活。在越来越多的企业和组织中,Spark已经成为处理大数据的首选工具。随着Spark生态系统的不断发展和完善,相信Spark在大数据分析领域的重要性和影响力将会进一步增强。

124 浏览量

217 浏览量

124 浏览量

2024-03-08 上传

109 浏览量

2021-12-11 上传

卟离居士

- 粉丝: 0

- 资源: 2

最新资源

- BTM-Projects-开源

- 声子晶体传输特性MATLAB,声子晶体的实际运用,matlab

- Android 开发,编程建立一个简单的进程内服务,实现比较两个整数大小的功能。服务提供Int Compare(Int, Int

- github-pages-test

- 德玛西亚call测试工具2.0.zip

- sakura_v2.4.1.zip

- pid控制器代码matlab-tankmov:基于ESP32WIFI芯片的水箱控制器。启用PID速度控制以及基于位置的控制和测量

- ztm-tassaf

- Dijkstra算法找最短路径代码,dijkstra算法求最短路径,matlab

- smooth.rar_DR1_平滑处理_数据处理_数据平滑_数据平滑处理

- MathCast Equation Editor-开源

- css3图标菜单鼠标滑过图标动画菜单效果

- DOFavoriteButton.Xamarin:基于Swift的DOFavoriteButton控件的Xamarin.iOS端口

- drs-hibernate

- dynamicTable:动态React表

- vIDC v2.0 测试版