深度学习入门:卷积神经网络详解与经典架构剖析

需积分: 9 194 浏览量

更新于2024-07-18

收藏 5.15MB PDF 举报

"本文档详述了卷积神经网络(CNN)的工作原理,并重点介绍了AlexNet、VGG、GoogLeNet和ResNet等经典网络架构,以及这些模型中的关键技巧,适合深度学习初学者参考学习。"

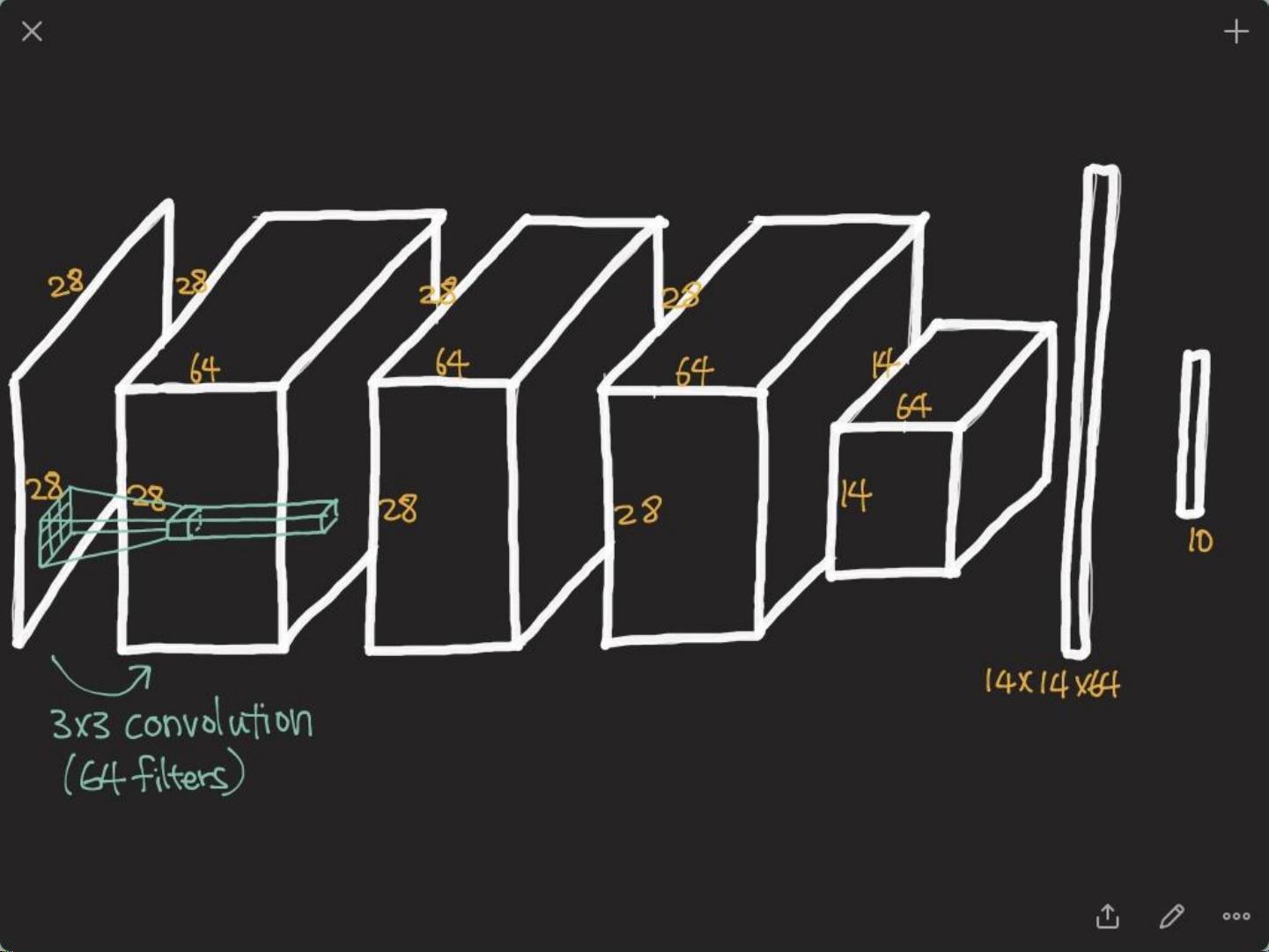

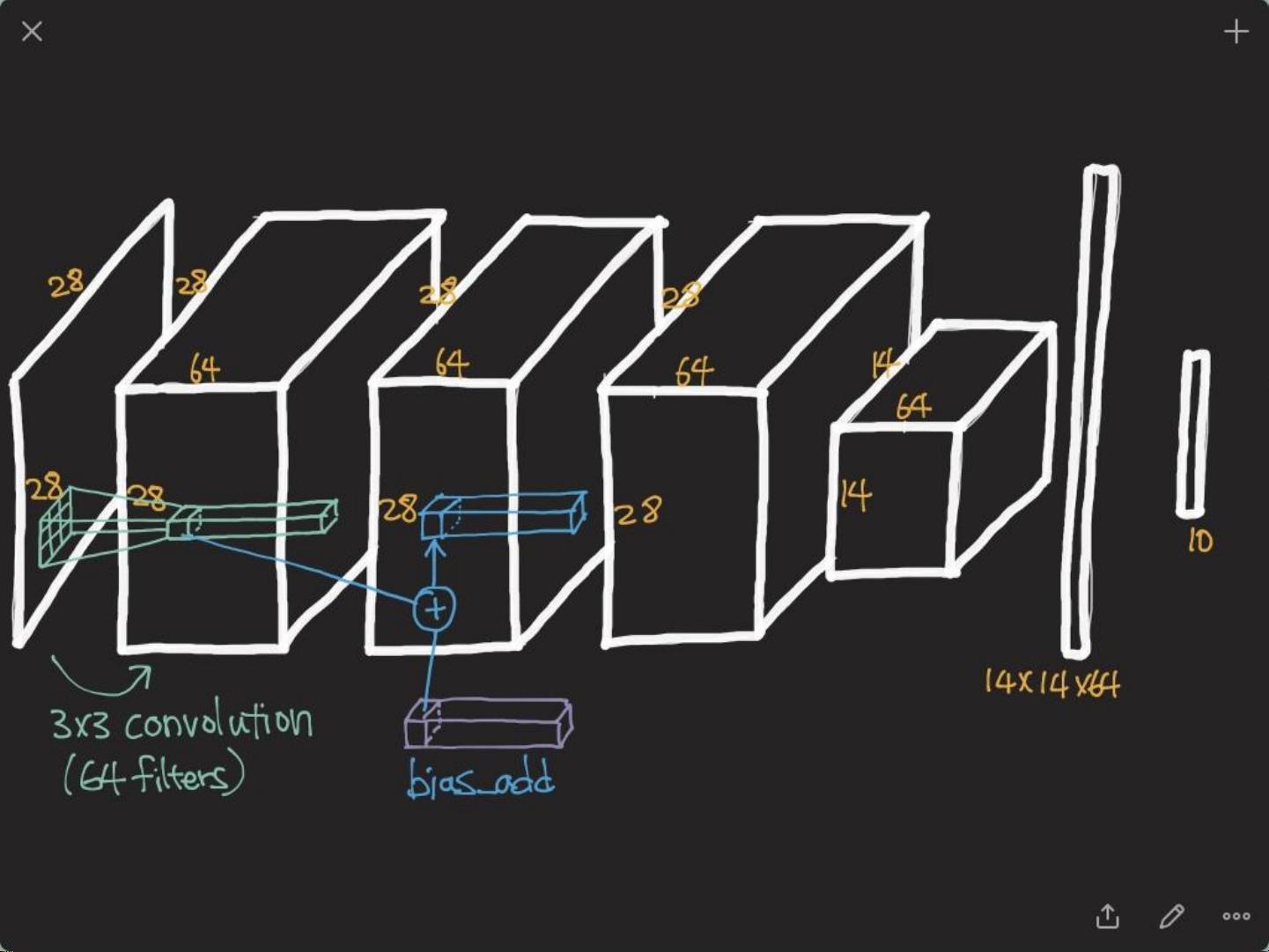

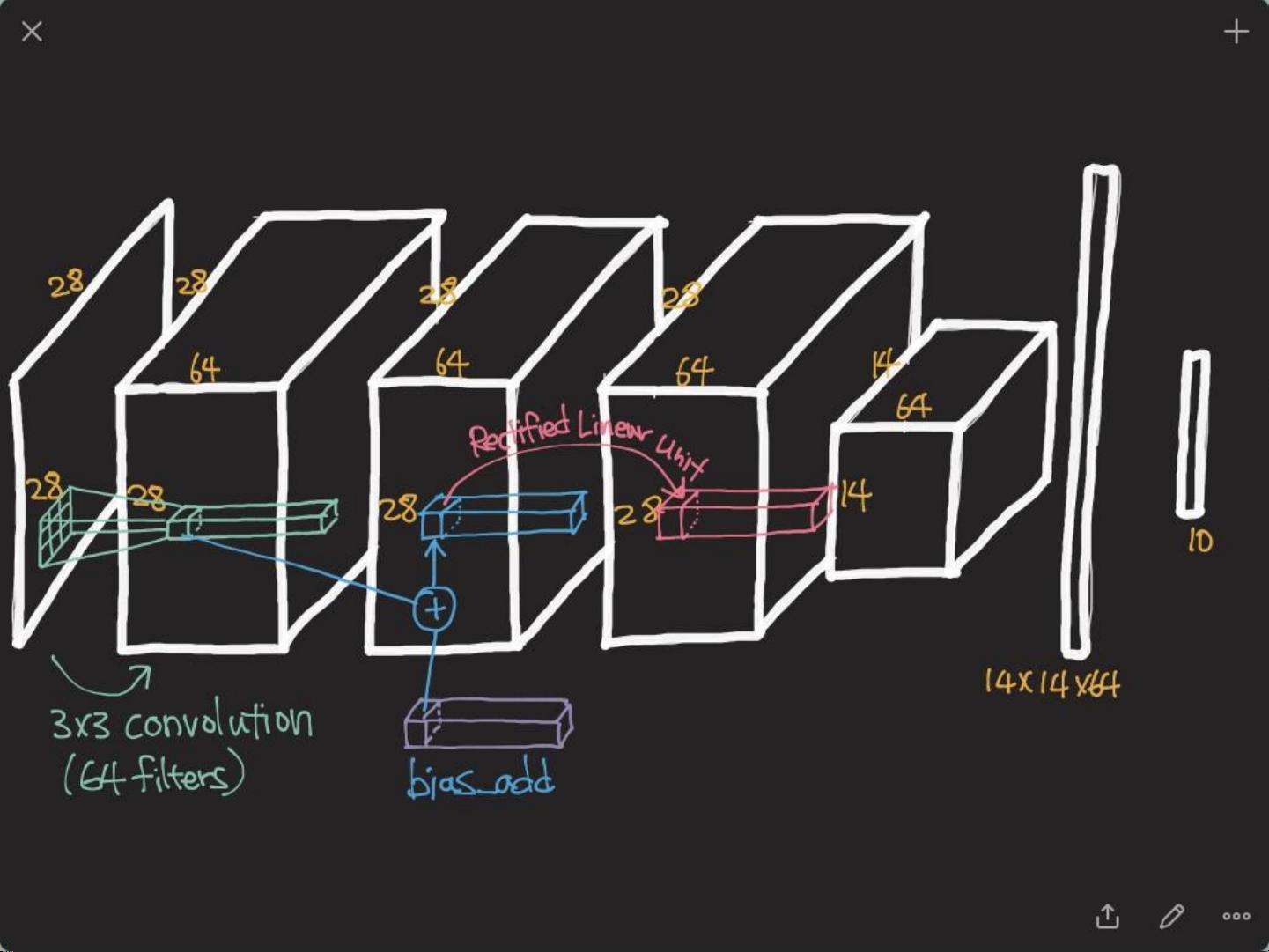

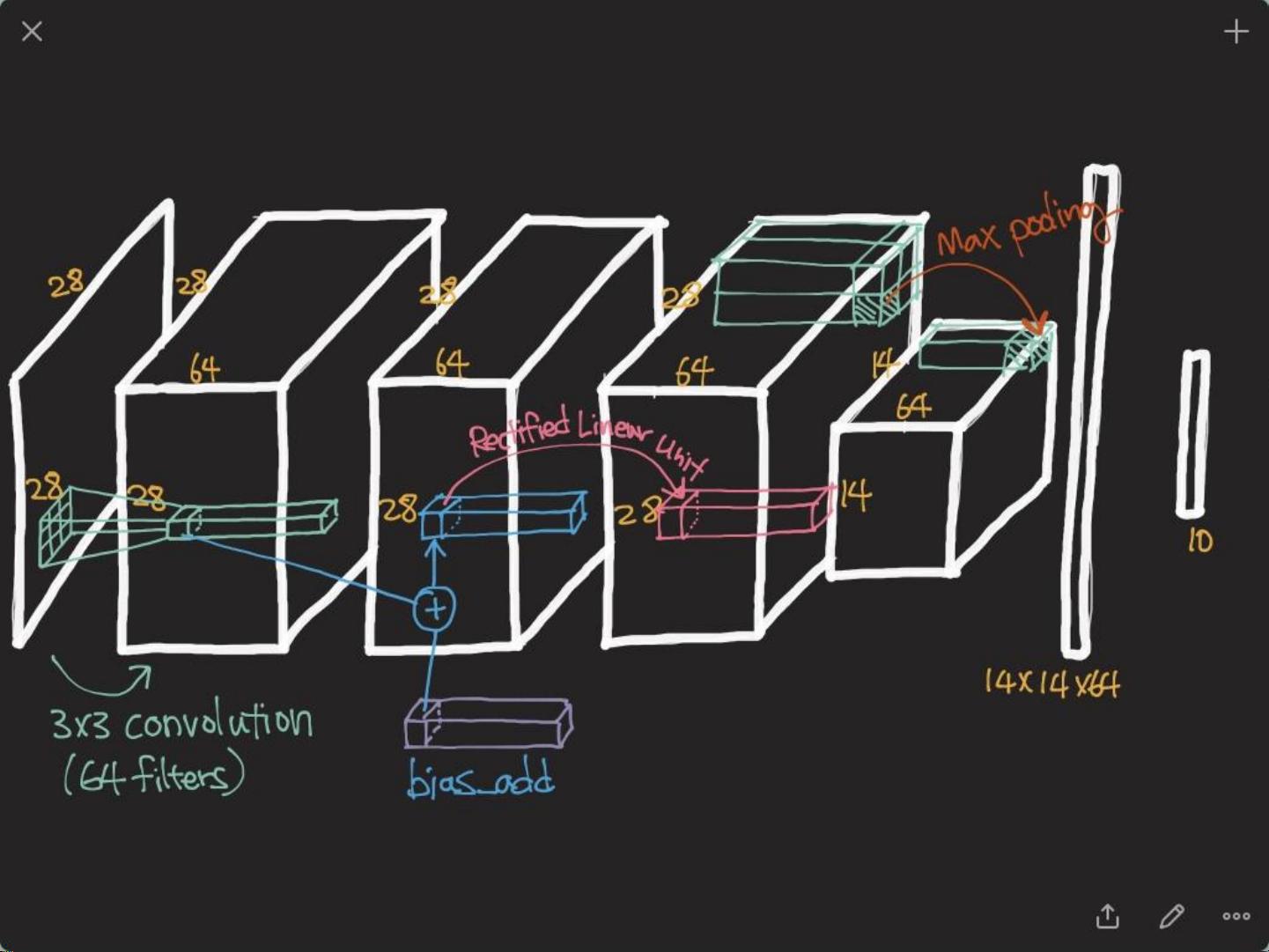

卷积神经网络(CNN)是一种广泛应用于图像识别和计算机视觉任务的深度学习模型。它的核心在于利用卷积层、池化层和全连接层来提取特征并进行分类。CNN的主要特点包括局部不变性和层次结构。

局部不变性是CNN强大能力的一个关键因素。由于卷积核在输入图像上滑动,网络可以识别出对象而不受其精确位置的影响,这使得它对平移、缩放等变换具有一定的鲁棒性。例如,在图像识别中,无论眼睛位于画面的哪个位置,CNN都能正确识别出眼睛的存在。

层次结构(Compositionality)是CNN的另一大亮点。网络通常由多层构成,每一层负责提取不同级别的特征。浅层通常捕捉边缘和简单形状,而深层则能捕获更复杂的模式和概念。这种分层处理有助于网络理解图像的复杂性。

卷积层是CNN的基础,它通过滑动滤波器(filter)来提取特征。滤波器在输入数据上进行卷积运算,生成特征映射。零填充(zero-padding)用于保持输入和输出尺寸的一致性,避免特征图在每次卷积后缩小。滤波器的步长(stride)决定了卷积移动的距离,影响输出大小。此外,每个滤波器还可以有多个通道(channel),如RGB图像的三个颜色通道。

池化层通常紧跟在卷积层后面,执行下采样操作,以减少计算量并提高模型的泛化能力。常见的池化方法有最大池化和平均池化。

接下来,我们深入探讨几个著名的CNN架构:

1. AlexNet:由Alex Krizhevsky等人提出的,首次在ImageNet大赛上取得显著成功,证明了深度学习在图像识别中的潜力。AlexNet包含多个卷积层和池化层,以及Dropout正则化,减少了过拟合风险。

2. VGGNet:由Karen Simonyan和Andrew Zisserman设计,以其深而薄的网络结构著称。VGGNet使用非常小的3x3卷积核,通过堆叠多层来增加网络深度,提高了特征表达能力。

3. GoogLeNet(Inception Network):由Google团队开发,引入了Inception模块,该模块同时使用不同大小的卷积核,以并行方式捕获不同尺度的信息,减少了计算复杂度,增强了模型的效率。

4. ResNet:由Kaiming He等人提出,引入了残差块(Residual Block),解决了深度网络中的梯度消失问题,允许构建更深的网络,如152层的ResNet-152。

论文中还可能介绍了一些核心技巧,如批量归一化(Batch Normalization)、权重初始化策略、数据增强(Data Augmentation)等,这些都是提升模型性能和训练速度的重要手段。

总而言之,这份文档为深度学习爱好者提供了一个全面了解卷积神经网络及其应用的起点,通过学习这些经典网络架构,读者可以更好地理解和构建自己的深度学习模型。

2018-12-20 上传

2020-10-18 上传

2024-05-03 上传

2023-04-04 上传

2023-12-05 上传

2024-06-22 上传

2022-07-15 上传

2021-09-10 上传

2023-12-05 上传

ReLuJie

- 粉丝: 109

- 资源: 42

最新资源

- SSM Java项目:StudentInfo 数据管理与可视化分析

- pyedgar:Python库简化EDGAR数据交互与文档下载

- Node.js环境下wfdb文件解码与实时数据处理

- phpcms v2.2企业级网站管理系统发布

- 美团饿了么优惠券推广工具-uniapp源码

- 基于红外传感器的会议室实时占用率测量系统

- DenseNet-201预训练模型:图像分类的深度学习工具箱

- Java实现和弦移调工具:Transposer-java

- phpMyFAQ 2.5.1 Beta多国语言版:技术项目源码共享平台

- Python自动化源码实现便捷自动下单功能

- Android天气预报应用:查看多城市详细天气信息

- PHPTML类:简化HTML页面创建的PHP开源工具

- Biovec在蛋白质分析中的应用:预测、结构和可视化

- EfficientNet-b0深度学习工具箱模型在MATLAB中的应用

- 2024年河北省技能大赛数字化设计开发样题解析

- 笔记本USB加湿器:便携式设计解决方案