"通俗易懂:YOLO系列(V1到V5)模型解读!"

141 浏览量

更新于2024-01-10

3

收藏 3.66MB PDF 举报

本文旨在以尽量浅显易懂的语言,让零基础的读者能够理解YOLO系列模型(从V1到V5),包括它们的设计思想和改进思路。我不会使用专业术语和晦涩表达,而是会尽量通俗地解释每一个新的概念,希望使读者能够像看故事一样学习YOLO模型。

YOLO系列模型是一种用于目标检测的算法,目的是在一张图片中识别出感兴趣的物体,如狗、汽车等。首先,让我们来谈谈YOLO v1和v5的设计思想和改进。

YOLO v1是一款非常强大的app,即i detection,它使用iOS系统,能够在任何场景下进行目标检测,包括工业场景和生活场景。这款app引入了YOLO算法,使得用户可以通过手机体验目标检测的功能。该算法的革新之处在于它可以实现即时检测,无需多次传递图像,而且可以在一张图片中同时检测出多个物体。

但是,YOLO v1也存在一些问题,比如准确性和召回率不高。为了解决这些问题,YOLO v5进行了大幅改进。首先,它引入了更先进的深度学习技术,如自注意力机制和特征融合,以提高目标检测的准确性和召回率。此外,YOLO v5还优化了损失函数和训练策略,以进一步提升性能。因此,YOLO v5在准确性和性能上都有了显著提升。

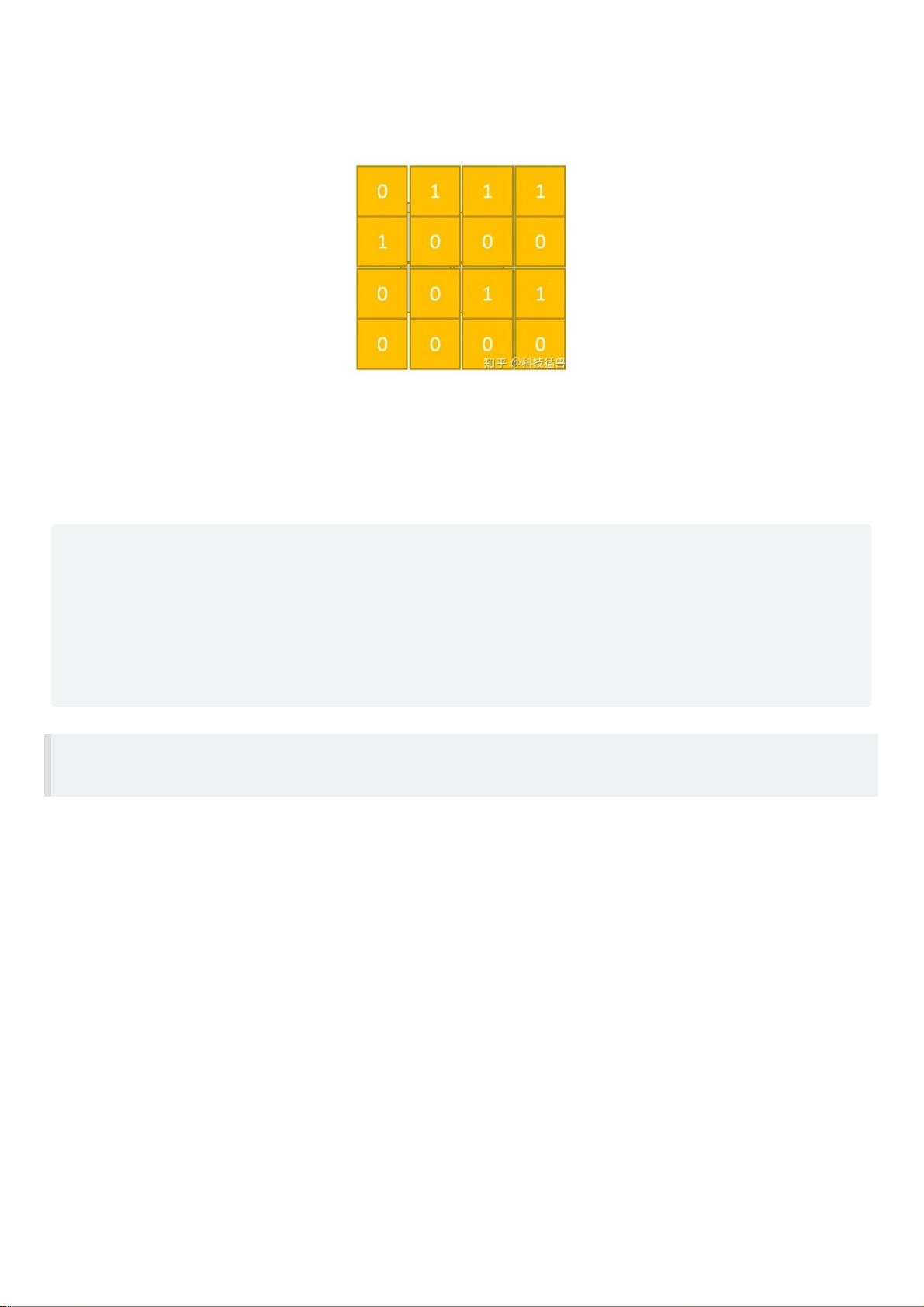

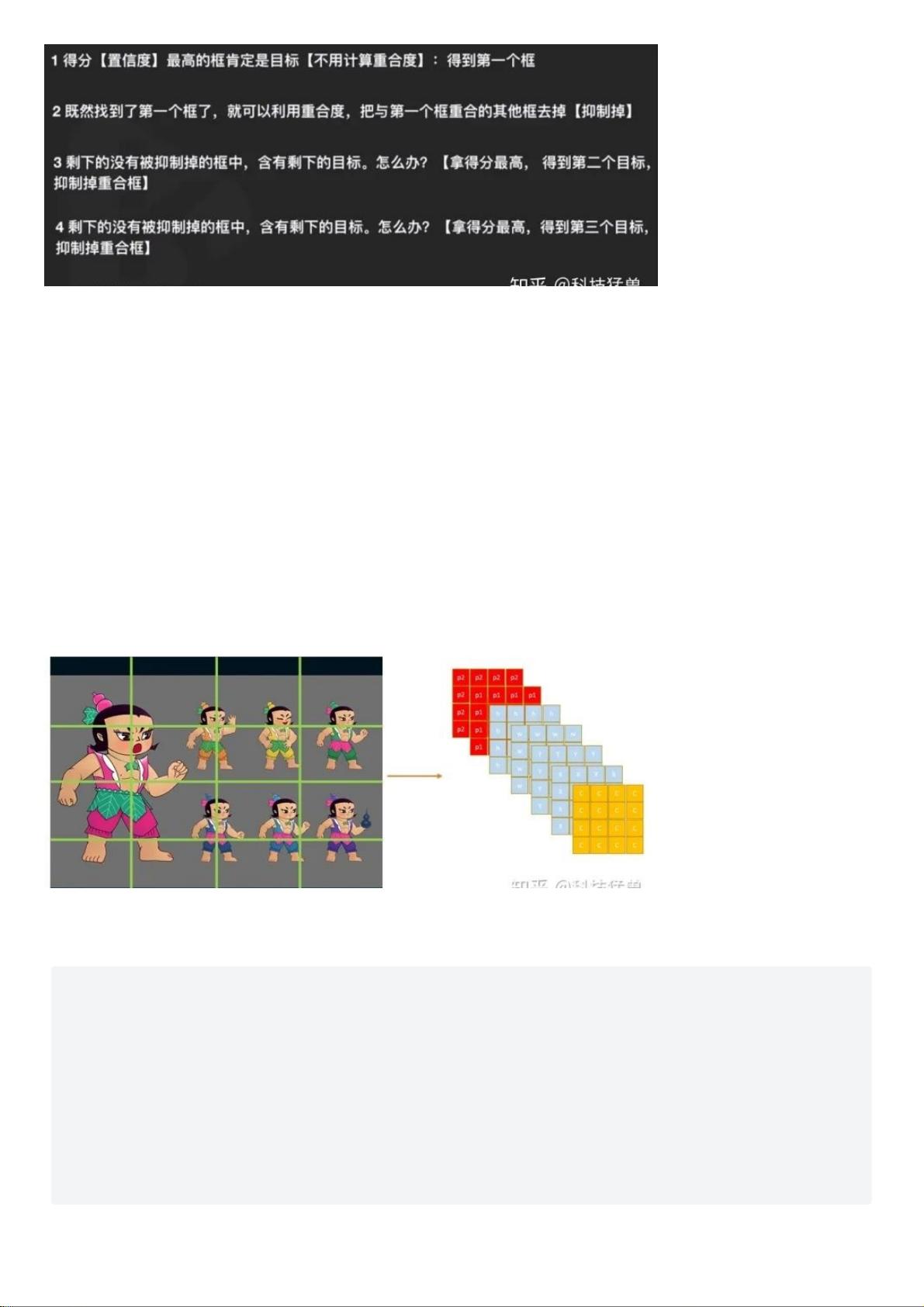

接下来,让我们深入了解YOLO模型的工作原理。YOLO模型先将输入图片分割成S×S个网格,每个网格负责检测包含在该网格内的物体。每个网格将输出B个边界框和对应的置信度,表示此边界框内是否包含物体的概率。同时,YOLO模型还输出C类别的概率分布,表示每个边界框属于各个类别的概率。通过将所有网格的输出一起进行处理,YOLO模型能够在一次前向传播中完成对整个图片的目标检测。

不仅如此,YOLO模型还引入了锚框机制和多尺度训练,以适应不同尺寸和比例的物体。这使得模型更加稳健和通用,能够在各种场景下进行准确的目标检测。

此外,YOLO v5还加入了模型压缩和轻量化设计,以适应移动端设备和嵌入式系统。这使得YOLO v5不仅在性能上有所提升,而且在应用场景上也更加灵活多样。

在代码解读方面,本文还提供了YOLO v1和v5的代码解析,帮助读者更好地理解模型的实现细节。通过这些解读,读者可以更清晰地了解模型的结构和参数优化的过程。

总的来说,YOLO系列模型(从V1到V5)是一系列先进的目标检测算法,它们不仅在性能上有所提升,而且在设计理念和应用场景上也有了巨大的改进。希望本文的讲解能够帮助读者了解这些模型,并且对相关领域的学习和研究有所帮助。

2023-11-09 上传

2024-03-09 上传

点击了解资源详情

点击了解资源详情

2023-04-11 上传

sun7bear

- 粉丝: 1

- 资源: 121

最新资源

- 非常不错的在线邮件群发系统官方版v1.1

- ng-auth:角度中的简单身份验证受限状态

- 4Coders-MeuCandidatoIdeal:黑客马拉松透明度巴西应用程序

- Memory-Game:原生Android记忆游戏应用

- 心情MTV网站系统官方版 v2.0

- 红警2mix文件加密器

- chasqientrega:https

- 广告牌彩灯闪烁控制程序+设计说明.rar

- frontend-boilerplate

- aspectjs:aspectjs切面编程

- mail-bot:基于条件的邮件机器人

- Hotel_website:CSS中的基本酒店网站

- 手机九宫格html5网站模板

- 水国类数据集(CV专用)

- 中国城市区域数据.zip

- ASOFI3D_时域各向异性地震建模_c语言_地震建模_时域_各向异性_ASOFI3D_建模_地震_3D