深度解析:轻量化神经网络卷积设计研究与应用进展

版权申诉

165 浏览量

更新于2024-06-28

1

收藏 1008KB DOCX 举报

轻量化神经网络卷积设计研究进展文档深入探讨了近年来在深度学习领域中一个关键的发展趋势——如何通过减少模型的复杂性和计算需求,实现高性能的神经网络模型。自AlexNet在2012年引领深度学习革命以来,网络深度和卷积层的强化极大地提升了模型的识别精度,但同时也带来了计算资源的急剧消耗。为了解决这个问题,研究者们开始关注轻量化网络的设计,如SqueezeNet的出现,它在保持相近识别性能的同时,参数量大幅度减小,甚至利用模型压缩技术进一步优化。

轻量化神经网络的目的是为了适应移动设备的低功耗和资源受限环境,它们强调结构的精简、计算效率和跨平台的兼容性。相比于传统CNN,轻量化模型的特点在于其紧凑的架构、高效的计算和更强的部署灵活性。这些特性使得它们在诸如自然语言处理、数据挖掘和医学图像分析等领域得到了广泛应用,尤其是在保持模型准确性前提下,显著提高了实时处理速度。

论文的核心部分聚焦于卷积的轻量化设计,这是实现轻量化网络的关键步骤。卷积的轻量化策略主要包括三个维度:卷积结构轻量化、卷积模块轻量化和卷积运算轻量化。

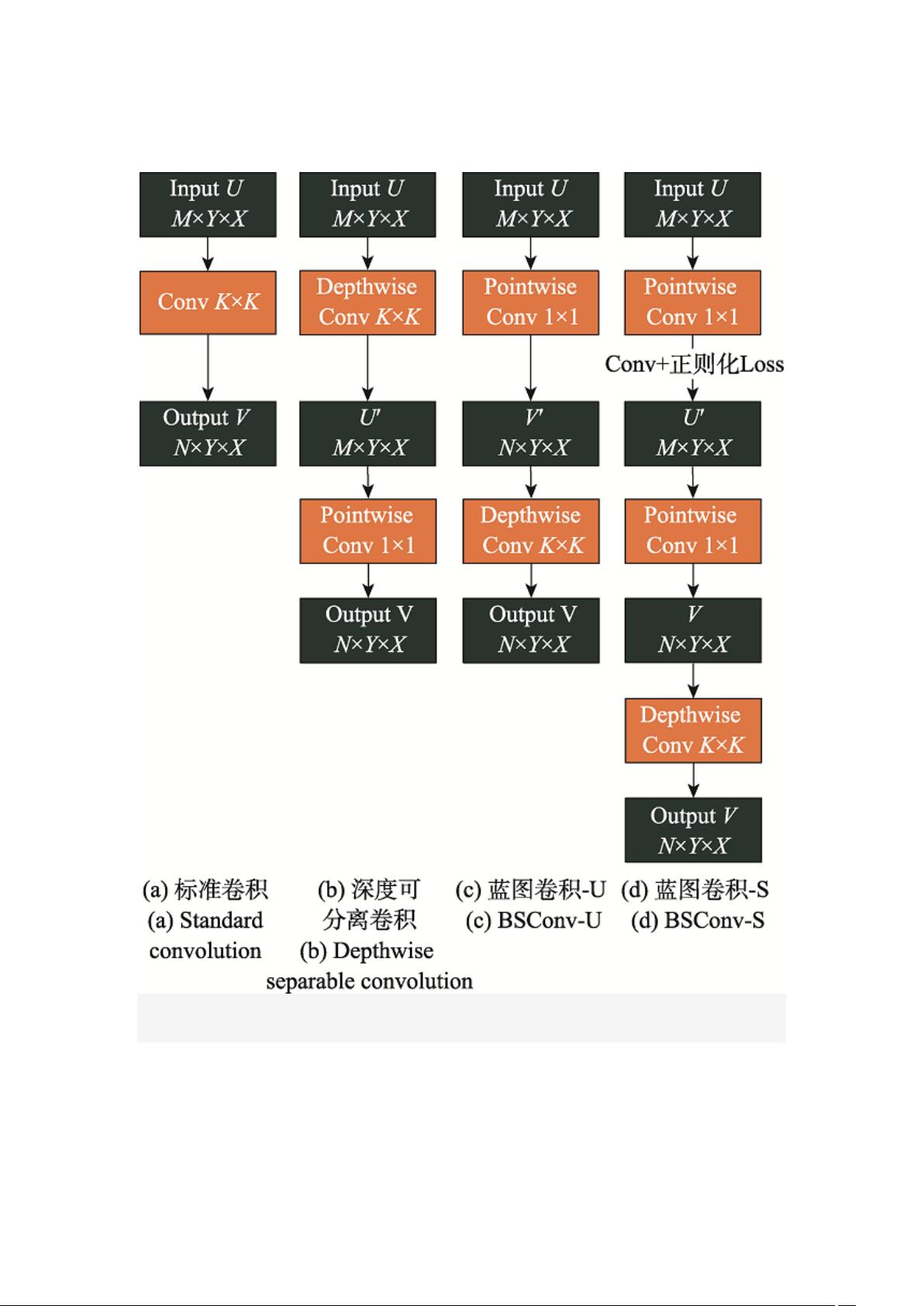

1. 卷积结构轻量化:这是通过调整单个卷积核的数量、尺寸和计算方式来实现的。比如,使用更小的卷积核、减少核数量或者采用分离卷积(Separable Convolution),可以减少计算量,同时保持或提高模型性能。

2. 卷积模块轻量化:涉及到网络中不同卷积层之间的连接和组织方式的优化。可能的方法包括减少并行分支、采用跳跃连接(Skip Connections)或子采样操作,以减少模块间的通信和计算成本。

3. 卷积运算轻量化:关注的是如何改进卷积运算的具体算法,例如使用深度可分离卷积(Depthwise Separable Convolution)、瓶颈结构(Bottleneck Blocks)或稀疏卷积(Sparse Convolution),这些都能减少计算密集度,提高运行效率。

总结来说,轻量化神经网络卷积设计的研究旨在找到一个平衡点,既能保持模型的准确性和泛化能力,又能满足移动设备的实际部署需求。这是一场不断探索和创新的过程,涉及理论与实践的紧密结合,旨在推动计算机视觉和人工智能技术向更广泛的应用场景拓展。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2019-12-01 上传

2022-12-01 上传

2023-02-23 上传

2023-11-01 上传

2021-10-18 上传

2021-09-20 上传

罗伯特之技术屋

- 粉丝: 4495

- 资源: 1万+

最新资源

- The.JFreeChart.Class.Library.Developer.Guide.v1.0.9.Jan.2008.pdf

- 如何在LINUX下用NAND FLASH实现YAFFS文件系统的流程

- Flex之ActionScript3.0 cookbook

- PIC 学习的绝好资料

- 基于MPEG-4的运动估计算法及硬件实现设计

- DCT-BASED PHASE CORRELATION MOTION ESTIMATION

- 简明Python 教程 pdf

- Windows下架设subversion服务器.txt

- J2EE 学习笔记-pdf格式文件

- J2EE完全参考手册-J2EE部署-PDF

- Google使用全攻略

- FramerWork.NET 2.0题库ATA认证 word

- ATA 认证 WEB题

- 乘法器 16*16 乘法器 16*16

- USBISP制做和使用过程记录

- GPS程序网络通信-VB鹰眼