批量梯度下降与随机梯度下降:比较与理解

"批量梯度下降(BGD)和随机梯度下降(SGD)是机器学习中优化模型参数的两种主要方法。它们都是基于梯度下降原理,即沿着目标函数梯度的负方向更新参数,以最小化损失函数。然而,两者在处理数据集的方式上存在显著差异,这直接影响了它们的计算效率和收敛速度。"

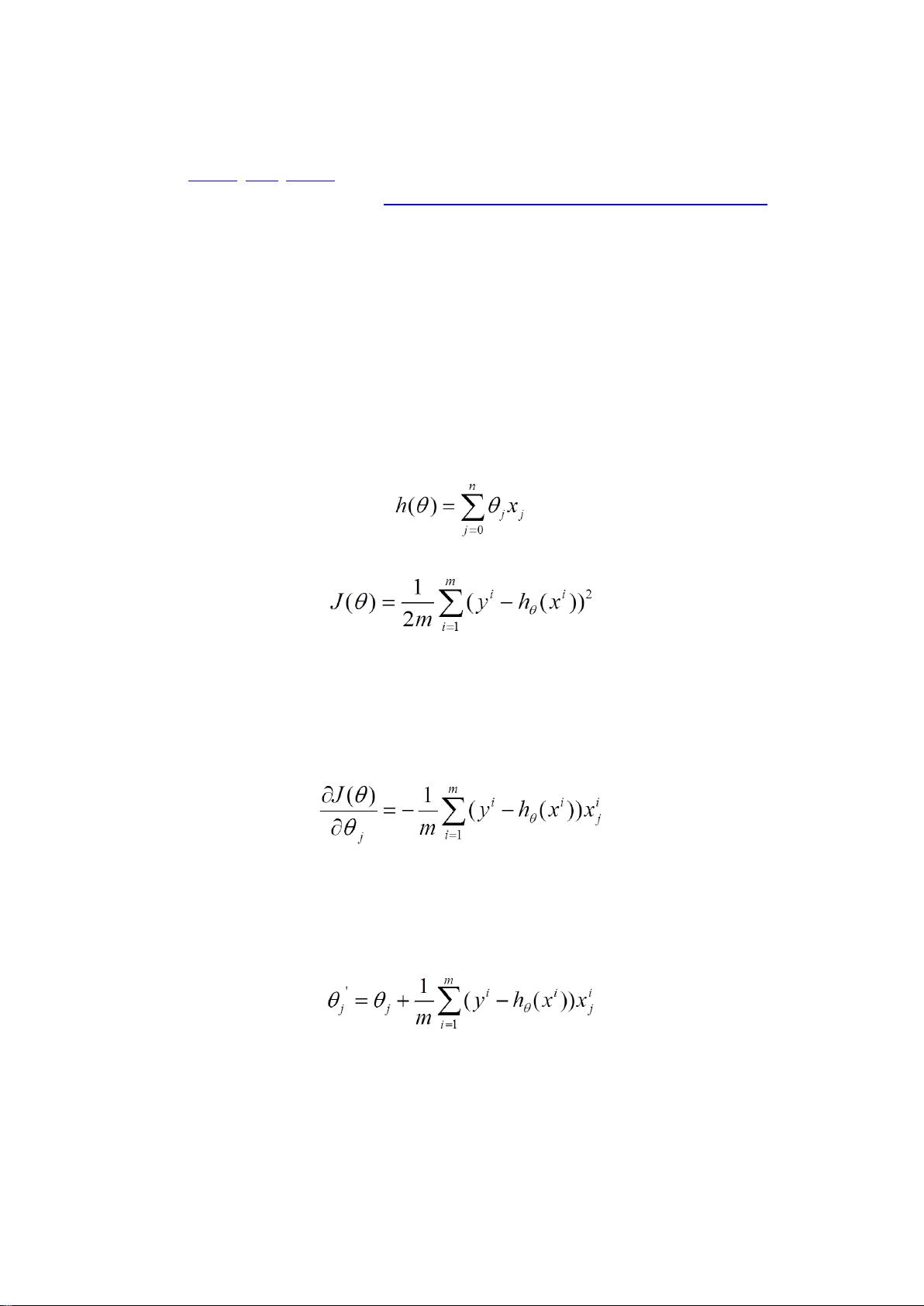

批量梯度下降是经典且基础的优化策略,它在每次迭代时都会使用整个训练集来计算梯度。具体步骤如下:

1. 计算损失函数J(θ)对所有参数θ的偏导数,得到梯度。

2. 沿着梯度的负方向更新参数,通常会乘以一个学习率α,以控制步长。

3. 这种方法的优点是,由于使用了全部数据,因此更新的方向相对稳定,容易找到全局最优解。但缺点是,当数据集很大时,计算梯度和更新参数的时间成本很高,导致训练过程缓慢。

随机梯度下降则采取不同的策略,每次迭代仅使用一个训练样本来更新参数:

1. 将损失函数分解为每个样本的损失,然后对单个样本的损失函数求导,得到梯度。

2. 使用这个梯度来更新参数,同样乘以学习率α。

3. SGD的迭代速度快,尤其在大数据集上,因为它只需要处理部分数据。然而,由于每次仅考虑一个样本,梯度估计的噪声较大,可能会导致收敛路径不稳,有时需要更多的迭代次数才能达到较好的解决方案。

对比两种方法,批量梯度下降适合数据集较小或计算资源充足的情况,能提供较为精确的梯度信息。而随机梯度下降在大数据集或在线学习场景下更有优势,其快速的迭代特性使得它在实际应用中更受欢迎,尤其是在深度学习模型的训练中,通过动态调整学习率等策略,可以有效平衡收敛速度和精度。

此外,还有一种介于两者之间的策略——小批量梯度下降,它每次迭代使用一部分(而非全部或单个)训练样本,结合了批量梯度下降的稳定性和随机梯度下降的速度,通常在实践中取得了较好的效果。在实际应用中,开发者会根据数据集大小、计算资源和模型复杂度等因素,灵活选择合适的梯度下降策略。

257 浏览量

775 浏览量

320 浏览量

320 浏览量

2021-02-21 上传

点击了解资源详情

2024-11-05 上传

143 浏览量

2024-05-11 上传

Eric2016_Lv

- 粉丝: 310

最新资源

- ABAP基础操作与系统字段详解

- Linux Kernel中文版详解:硬件与软件基础、存储管理和进程管理

- 精通Linux:从新手到高手的实战教程

- 3S技术集成与应用探索

- LPC2000系列MCU使用SPI接口访问MMC卡教程

- ArcGIS Engine白皮书:基于ESRI技术的自定义GIS应用开发指南

- Oracle数据库入门:从基础到SQL操作

- DOS命令详解:ping与ipconfig的使用技巧

- Visual C++ MFC入门教程:面向对象的Windows应用开发

- Struts2 框架深度解析

- AS/400 RPG语言编程指南

- SAP BAPI 用户指南:高级教程

- 深入学习Svn客户端:服务器功能、TortoiseSVN安装与工作流程

- Compass: Java搜索引擎框架, Hibernate替代方案(最新1.1M1版)

- Linux内核0.11详解与编译指南

- STL常见修改算法详解