PyTorch深度学习教程:模型构建与优化

需积分: 21 102 浏览量

更新于2024-07-16

1

收藏 3.55MB PDF 举报

"这是一份深入讲解PyTorch的教程,涵盖了深度学习的基础知识和核心组件,包括张量操作、自动求导、模型构建、优化器、损失函数以及数据处理等。教程还涉及到了模型的保存和加载,以及在GPU上的操作。此外,教程也提到了强化学习的基本概念。"

在PyTorch中,深度学习的核心在于其灵活性和易用性。首先,张量(Tensor)是所有计算的基础,它们类似于Numpy数组,但支持在GPU上运行以加速计算。PyTorch中的张量具有Autograd特性,能够自动记录其操作历史,以便进行反向传播以计算梯度。

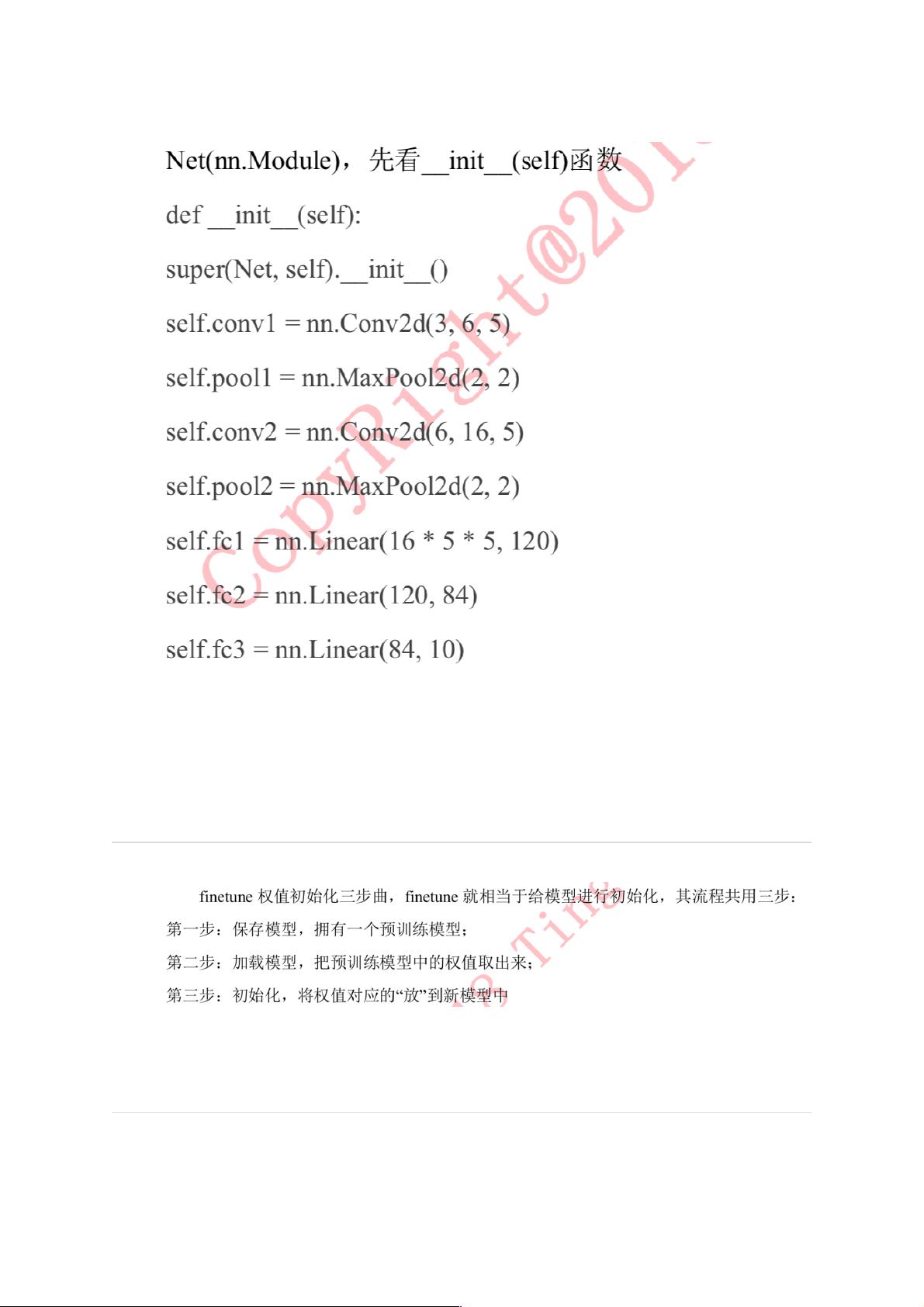

`nn.Module`是构建神经网络架构的基础,你可以自定义子类来创建复杂的网络结构。在`nn.Module`中定义`forward`方法,输入数据在此方法中通过不同的层和激活函数流动,最终生成输出。`forward`方法的灵活性使得实现各种网络结构变得简单。

优化器(Optimizer)在PyTorch中扮演着关键角色,例如SGD(随机梯度下降)、Adam、Adadelta、Adagrad、RMSprop等,它们用于根据损失函数的梯度更新网络权重。损失函数,如二元和多类交叉熵、均方误差和绝对误差、Smooth L1 Loss、负对数似然损失以及Kullback-Leibler散度,是衡量模型预测与实际结果之间差距的关键。

在实际应用中,数据通常分为训练集、验证集和测试集,比例通常是8:1:1。PyTorch的`Dataset`类提供了一个基础框架,用于加载和预处理数据。你可以创建`Dataset`的子类,将图像路径和标签组织起来,并实现数据增强和标准化,比如数据归一化、中心化等,以提高模型的泛化能力。

模型的保存和加载是训练过程中必不可少的部分。状态字典(state_dict)包含了模型的所有权重和偏置,可以用于保存或加载模型的状态。PyTorch提供了保存到CPU和GPU的功能,这使得在不同设备之间迁移模型成为可能。`torch.save`和`torch.load`函数用于实现这一过程。

最后,虽然教程没有详细讨论,但强化学习在PyTorch中可以通过`torch.nn`和`torch.optim`模块结合环境模拟库(如Gym)来实现,允许我们构建和训练Q-learning、Deep Q-Networks (DQN)等算法。

这个PyTorch教程提供了一个全面的起点,适合初学者理解深度学习的核心概念,并动手实践构建和训练自己的神经网络模型。

2020-02-14 上传

2024-07-29 上传

2024-07-23 上传

2020-10-23 上传

2024-01-04 上传

197 浏览量

AI拉呱

- 粉丝: 2875

- 资源: 5511

最新资源

- WordPress作为新闻管理面板的实现指南

- NPC_Generator:使用Ruby打造的游戏角色生成器

- MATLAB实现变邻域搜索算法源码解析

- 探索C++并行编程:使用INTEL TBB的项目实践

- 玫枫跟打器:网页版五笔打字工具,提升macOS打字效率

- 萨尔塔·阿萨尔·希塔斯:SATINDER项目解析

- 掌握变邻域搜索算法:MATLAB代码实践

- saaraansh: 简化法律文档,打破语言障碍的智能应用

- 探索牛角交友盲盒系统:PHP开源交友平台的新选择

- 探索Nullfactory-SSRSExtensions: 强化SQL Server报告服务

- Lotide:一套JavaScript实用工具库的深度解析

- 利用Aurelia 2脚手架搭建新项目的快速指南

- 变邻域搜索算法Matlab实现教程

- 实战指南:构建高效ES+Redis+MySQL架构解决方案

- GitHub Pages入门模板快速启动指南

- NeonClock遗产版:包名更迭与应用更新