LSTM详解:背景、问题与解决方案

需积分: 9 34 浏览量

更新于2024-07-16

1

收藏 1.72MB DOCX 举报

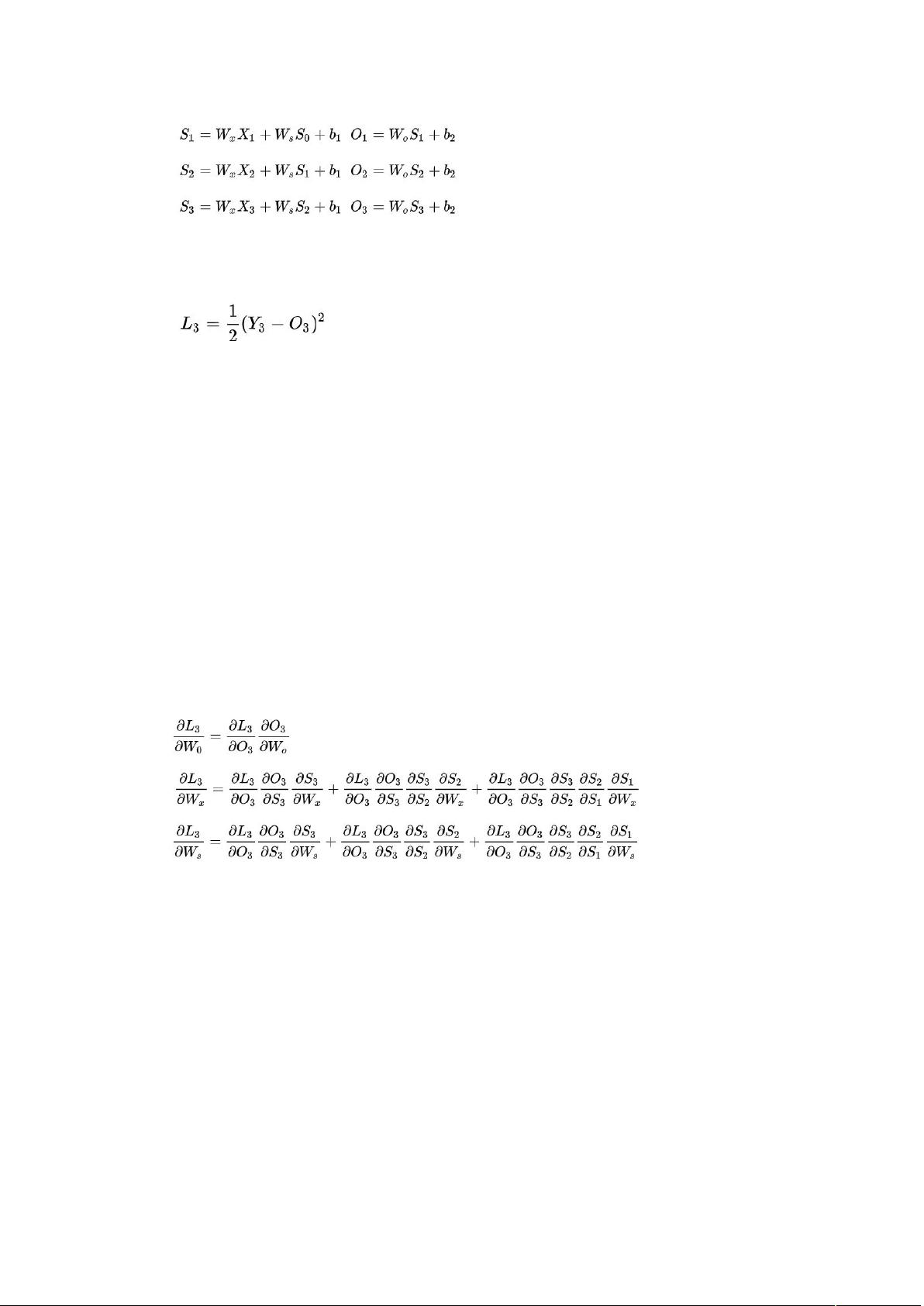

LSTM详细学习文档深入探讨了LSTM这一强大的递归神经网络模型,特别关注其核心原理、发展历程以及解决RNN问题的关键。首先,LSTM的诞生源于RNN在处理长序列时遇到的梯度消失和梯度爆炸问题。这些问题是由于深度网络中sigmoid等激活函数的非线性特性导致的,当网络层数增加时,梯度逐层传递变得非常小,可能趋近于零(梯度消失),或过大(梯度爆炸)。

1.1 梯度消失和爆炸的原理

梯度消失和爆炸问题起因于反向传播过程中,激活函数如sigmoid的导数在极大值附近趋于0,导致深层网络的权重更新困难。初始权重设置过小或过大都会加剧这一问题。在经典RNN中,由于时间步与时间步之间的依赖关系,梯度问题尤为突出。

1.2 LSTM如何解决这些问题

LSTM(长短期记忆网络)引入了三个关键组件:细胞状态(cell state)、遗忘门(forget gate)、输入门(input gate)和输出门(output gate)。这些结构允许LSTM动态控制信息的流动,有效地解决了梯度消失问题。细胞状态保持长期记忆,而门机制允许选择性地忘记或记住过去的信息,从而避免了梯度消失。同时,这种设计限制了梯度的指数增长,防止了梯度爆炸。

LSTM的代码实现通常涉及TensorFlow、Keras等深度学习框架,它们提供了内置的LSTM层,简化了模型构建。开发者可以调整隐藏单元数量、学习率、优化器等超参数,优化模型性能。

2. LSTM的发展与变体

随着时间的推移,LSTM不断发展并衍生出许多变体,如门控循环单元(GRU)和双向LSTM(bidirectional LSTM),这些改进在某些场景下可以进一步提升模型性能。此外,注意力机制(attention mechanism)也被集成到LSTM中,形成Transformer等模型,用于自然语言处理等领域。

总结来说,LSTM的学习涉及对问题背景的理解、核心原理的掌握、编程实现技巧以及当前的最新进展。通过全面解答上述五个问题,读者不仅能深入理解LSTM,还能了解到它在实际应用中的演变和优化。

2021-08-29 上传

2020-03-15 上传

2023-07-27 上传

2023-08-12 上传

2023-06-07 上传

2023-07-03 上传

2023-06-03 上传

2023-06-03 上传

2023-06-02 上传

Blessy_Zhu

- 粉丝: 1135

- 资源: 6

最新资源

- JDK 17 Linux版本压缩包解压与安装指南

- C++/Qt飞行模拟器教员控制台系统源码发布

- TensorFlow深度学习实践:CNN在MNIST数据集上的应用

- 鸿蒙驱动HCIA资料整理-培训教材与开发者指南

- 凯撒Java版SaaS OA协同办公软件v2.0特性解析

- AutoCAD二次开发中文指南下载 - C#编程深入解析

- C语言冒泡排序算法实现详解

- Pointofix截屏:轻松实现高效截图体验

- Matlab实现SVM数据分类与预测教程

- 基于JSP+SQL的网站流量统计管理系统设计与实现

- C语言实现删除字符中重复项的方法与技巧

- e-sqlcipher.dll动态链接库的作用与应用

- 浙江工业大学自考网站开发与继续教育官网模板设计

- STM32 103C8T6 OLED 显示程序实现指南

- 高效压缩技术:删除重复字符压缩包

- JSP+SQL智能交通管理系统:违章处理与交通效率提升