Kaggle销量预测竞赛:Jupyter Notebook实战与代码分享

59 浏览量

更新于2024-08-28

5

收藏 153KB PDF 举报

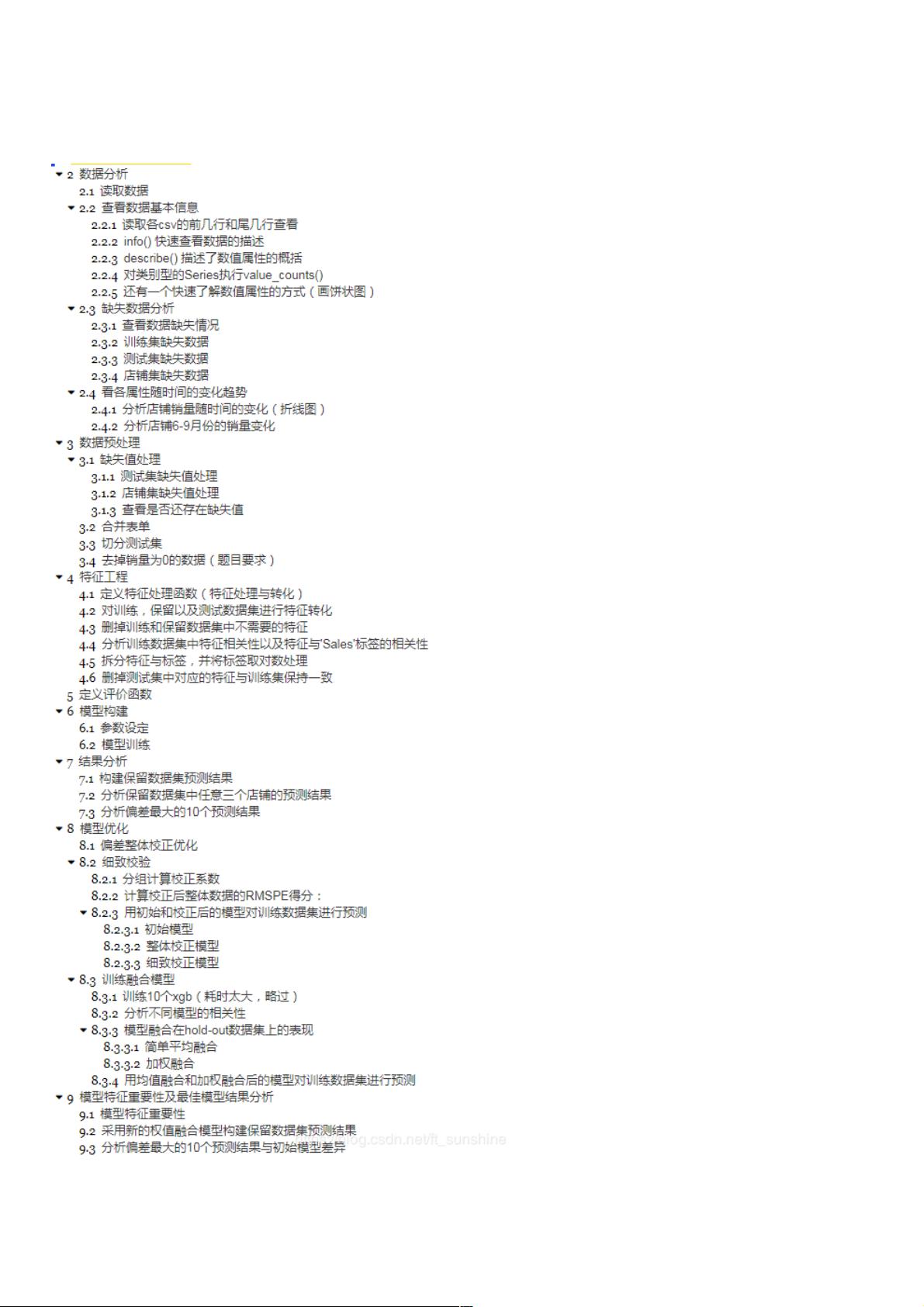

在这个Kaggle竞赛中,挑战者的目标是进行销量预测,即预测商品在特定时间点的销售量,以达到Top1%的准确度。竞赛是在Jupyter Notebook环境下进行编程的,博主分享了他们的代码和流程记录,但由于Notebook转换成Markdown格式时,格式展示有所缺失。

首先,博主设置了Jupyter Notebook的一些配置,确保代码块在交互时能够正确执行。`%config ZMQInteractiveShell.ast_node_interactivity='all'`这一行使得所有类型的交互式代码都会被运行,避免了可能的混乱。`%pprint`魔术命令则是用于美化输出结果,使数据结构更易阅读。

比赛使用的开发环境是Windows 10,Anaconda 3.5版本的Jupyter Notebook,Python 3.6作为主要的编程语言。此外,还依赖了几个关键的库,包括numpy(数值计算)、pandas(数据处理)、matplotlib和seaborn(数据可视化)、xgboost(梯度提升算法)以及time(时间管理),这些库在预测模型的构建和数据分析过程中起着重要作用。

在数据预处理阶段,博主首先加载了训练集(train.csv)和测试集(test.csv),并利用`pd.read_csv`函数读取,同时指定了日期列`parse_dates=[2]`和`[3]`分别对应训练集和测试集中的日期字段。另外,还读取了一个存储有关店铺信息的额外数据集(store.csv)。

博主展示了数据的基本信息,通过`display`函数查看了训练集、测试集和商店信息的首尾几行,以及使用`info()`方法快速了解数据的描述性统计,这有助于理解数据的分布、缺失值情况以及数据类型等。

接下来,博主将进行深入的数据探索和特征工程,可能包括时间序列分析、相关性分析、数据清洗和特征选择,这些都是销量预测模型构建的关键步骤。之后,他们会选择或创建合适的特征输入到xgboost模型中,该模型因其高效性和准确性在许多 Kaggle 竞赛中受到欢迎。

最后,博主提到的“运行时间:CPU:i7-6700HQ,约8h”暗示了这是一个耗时较长的计算任务,可能涉及到复杂的模型训练和超参数调优。整个过程注重实践性和效率,体现了数据科学竞赛中常见的最佳实践。

由于提供的部分内容有限,无法详述完整的模型构建流程,但可以推测博主会通过一系列技术手段来提升预测性能,并最终实现Top1%的销售预测准确率。如果需要了解更多细节,如特征工程、模型训练和评估等步骤,可以继续关注博主后续提供的代码和分析细节。

2021-02-04 上传

2024-11-06 上传

2024-11-06 上传

2023-10-19 上传

2023-05-14 上传

2024-01-10 上传

2023-09-22 上传

weixin_38737366

- 粉丝: 5

- 资源: 950

最新资源

- Court-Counter:这个程序将帮助更新两队的得分

- changsikkwon.github.com

- 易语言DUI图形编辑器源码-易语言

- app-livetrace:Enonic XP的LiveTrace应用程序

- 代码前30天

- line-chatbot

- love_story

- 记录python,pytorch,git等工具的学习过程,主要是对该工具常用部分进行实践。.zip

- circuitry:Web Audio API 电路可视化工具

- dbms-online-voting-system:为了使投票更加安全并允许每个有资格投票的人

- 乌尔纳电子

- filess:ファイルを整理するためのCLIツール

- 简单的python爬虫学习.zip

- guava-12.0.1-API文档-中文版.zip

- 行业文档-设计装置-一种点钞机纸币回转系统.zip

- landing-page-with-form:带有表单的登录页面