网络爬虫实现原理:通用与聚焦爬虫解析

117 浏览量

更新于2024-08-27

收藏 488KB PDF 举报

"网络爬虫实现原理与技术"

网络爬虫是一种自动遍历互联网并抓取网页信息的程序,它能够帮助我们收集大量的网络数据。在本文中,我们将深入探讨两种常见的网络爬虫类型:通用网络爬虫和聚焦网络爬虫。

1. 通用网络爬虫

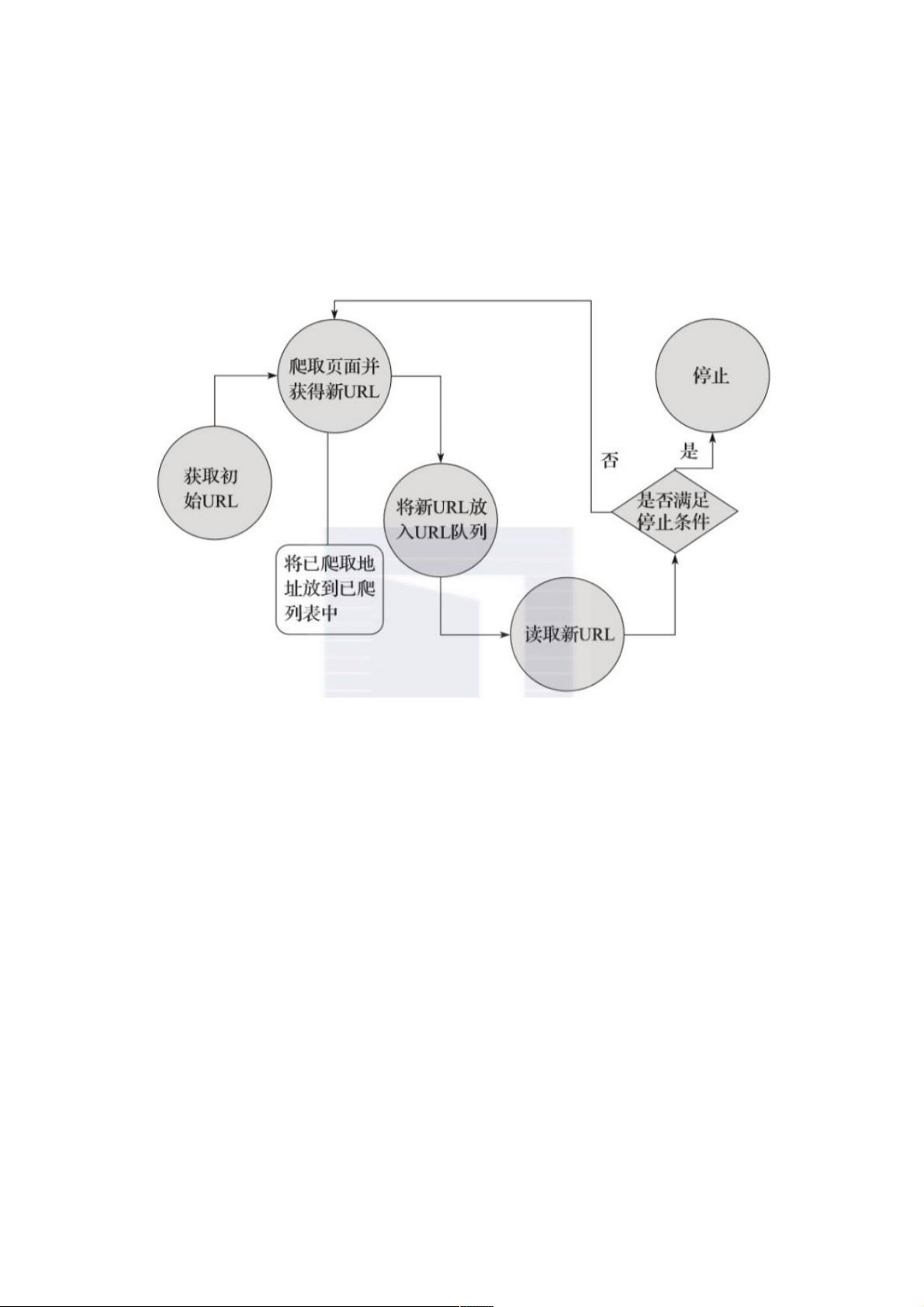

通用网络爬虫,也称为全网爬虫,其目标是尽可能广泛地抓取互联网上的信息。它的实现原理主要包括以下几个步骤:

- **获取初始URL**:爬虫的起点通常是用户指定的一个或多个初始网页URL。这些URL构成了爬取的种子集合。

- **爬取页面并提取新URL**:爬虫访问初始URL,解析网页内容,从中提取出新的链接URL。这些新URL会被添加到待爬取的URL队列中。

- **存储网页和URL管理**:爬虫将抓取到的网页保存到原始数据库,并记录已爬取的URL,以防止重复爬取。同时,URL队列用于控制爬取顺序和避免死循环。

- **持续爬取**:从URL队列中取出下一个URL,重复上述过程,直到队列为空或达到预设的停止条件,如时间限制、内存限制或已爬取页面数量等。

2. 聚焦网络爬虫

聚焦网络爬虫则更为定向,它专注于特定主题或领域,只抓取与目标相关的内容。其工作流程除了通用爬虫的步骤外,还包括额外的策略:

- **定义爬取目标**:首先明确爬虫的目标,例如特定关键词、主题或网站子集,为后续的链接过滤提供依据。

- **获取初始URL**:与通用爬虫相同,从与目标相关的初始URL开始。

- **过滤无关链接**:在爬取过程中,聚焦爬虫会检查每个新发现的URL,如果与目标不相关,则会忽略这些链接,确保只爬取与目标相关的内容。

- **选择下一步爬取的URL**:基于爬取目标的定义,爬虫会选择最相关的URL进行下一步爬取,这可能涉及到对URL的评分和优先级排序。

无论是哪种类型的爬虫,它们都需要处理一些共性问题,如网页编码识别、反爬虫策略、网页动态加载、cookies管理等。此外,为了保证爬虫的效率和合法性,还需要遵守robots.txt协议,尊重网站的抓取规则。

总结来说,网络爬虫是通过自动化的方式,从互联网上抓取大量信息的工具。通用爬虫广泛搜集信息,而聚焦爬虫则更加有针对性,两者在实现原理上有相似之处,但也各有特点。理解这些原理对于开发有效的网络爬虫至关重要,可以帮助我们在海量数据中高效地获取所需信息。

624 浏览量

129 浏览量

点击了解资源详情

175 浏览量

点击了解资源详情

253 浏览量

138 浏览量

148 浏览量

181 浏览量

weixin_38544075

- 粉丝: 10

- 资源: 931