文心一言测试指南:提升对话与应用效能

需积分: 2 67 浏览量

更新于2024-06-14

收藏 13.19MB PDF 举报

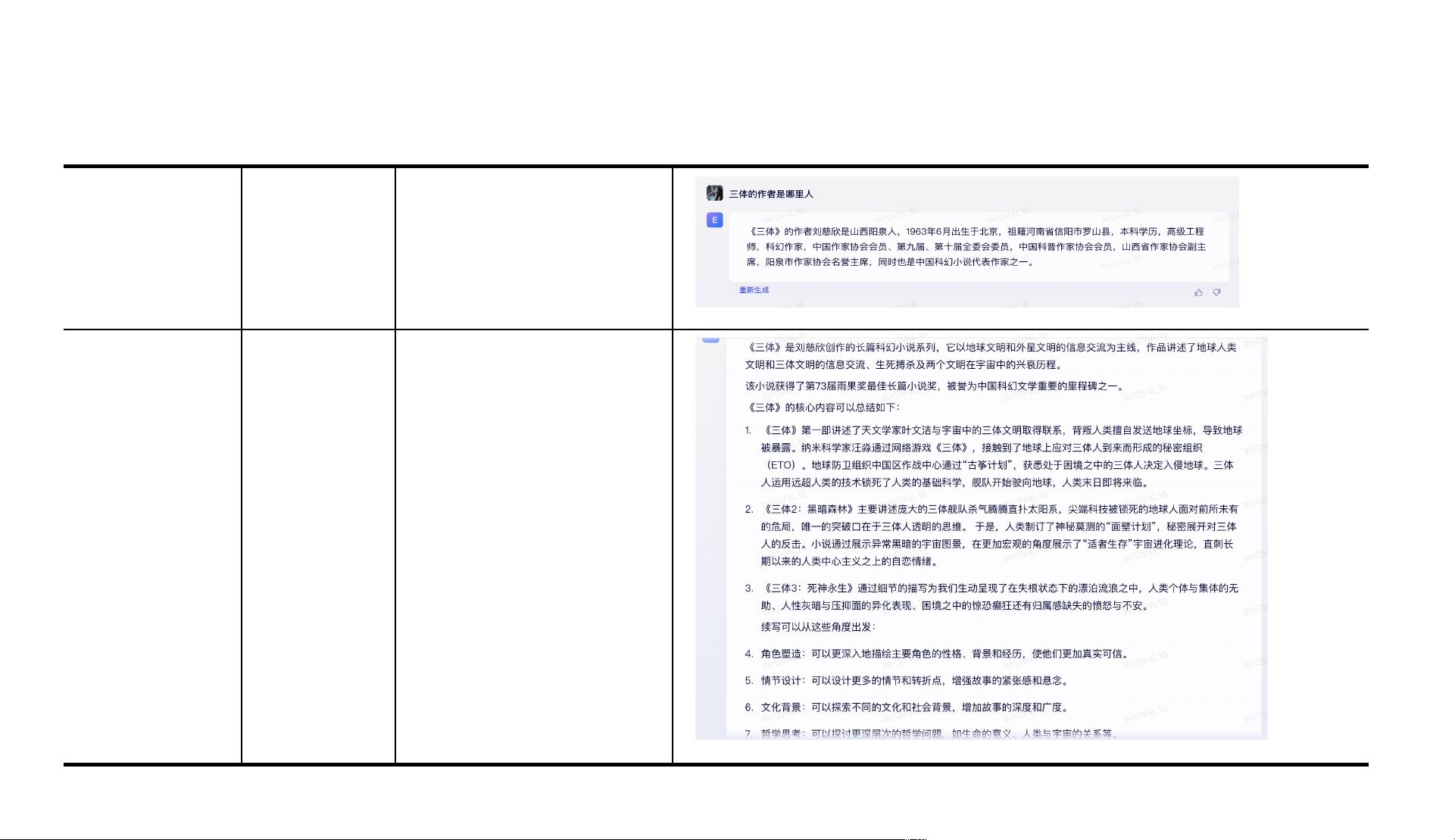

"文心一言测试指引是一个实用文档,主要针对的是百度公司推出的一款AI预训练模型——文心一言,它旨在通过对话交互提供信息、知识和创意支持。该文档详细介绍了如何进行有效的测试,确保模型的性能和用户体验。

首先,使用者在开始测试前需要对文心一言的基本功能和特性有深入理解,包括其应用场景,如文本创作、辅助编辑、方案输出、知识问答、灵感激发等,涵盖了工作和个人生活中的多个领域。用户可以通过官方文档和培训课程获取相关知识。

在测试环境中,文档强调了与实际使用场景的匹配性,要求用户模拟真实的使用条件,使用合适的测试数据集和案例来评估模型的准确性和适应性。这包括衡量指标如准确率、召回率,并可能与其他类似工具进行对比,以全面了解文心一言的优劣。

测试过程中,除了定量评价外,用户体验和可解释性也是关注的重点。用户可以进行多轮对话,提问、追问和修改问题,以便获取更精准的回答并给予反馈。鼓励用户积极提供反馈,无论是肯定的“赞”还是建设性的批评,都是优化模型的关键。

遇到问题时,用户可能会遇到数据不一致、模型过拟合或欠拟合等情况。此时,用户需要灵活调整模型参数、增加训练数据或优化数据处理方法,以解决潜在问题。

文心一言测试指引为用户提供了细致的步骤指导,旨在通过系统化的测试方法,确保用户在使用过程中能充分利用文心一言的功能,同时推动模型的持续改进和优化。"

151 浏览量

638 浏览量

149 浏览量

230 浏览量

2023-06-06 上传

161 浏览量

雨过朦胧影

- 粉丝: 1454

最新资源

- Java中SQLServer与MySQL数据库驱动的使用方法

- 微信图文混排技术详解与Android实现

- 搭建Nginx PHP MySQL环境:Docker实战教程

- DW-TX382系列驱动的优化与应用

- knotes项目中消息提交与日志管理功能介绍

- CSS3美化单选多选按钮的多种特效实现

- 蓝色牛仔布服装公司DIV+CSS网站模板发布

- 实现Java对象与Excel/CSV数据的互转方法

- 三星Galaxy Tab 4 WiFi 7.0设备树开发进展

- iOS实现完美QQ分组二级展开动画效果教程

- 重力粒子动态绘图屏保:diffuseGravity 体验

- 深入解析网络超链接标记:用CoffeeScript实现互联网上的互联网

- PHP顶层类实现调试信息管理与主页判定

- Windows平台Markdown图片快速上传与外链生成工具

- 针对Windows 7的RAD Studio 2007调试器修复方案

- 短信监听实现的Android位置定位应用