深度解析:卷积神经网络CNN的历史、进步与现代应用

版权申诉

77 浏览量

更新于2024-06-28

收藏 2.27MB DOCX 举报

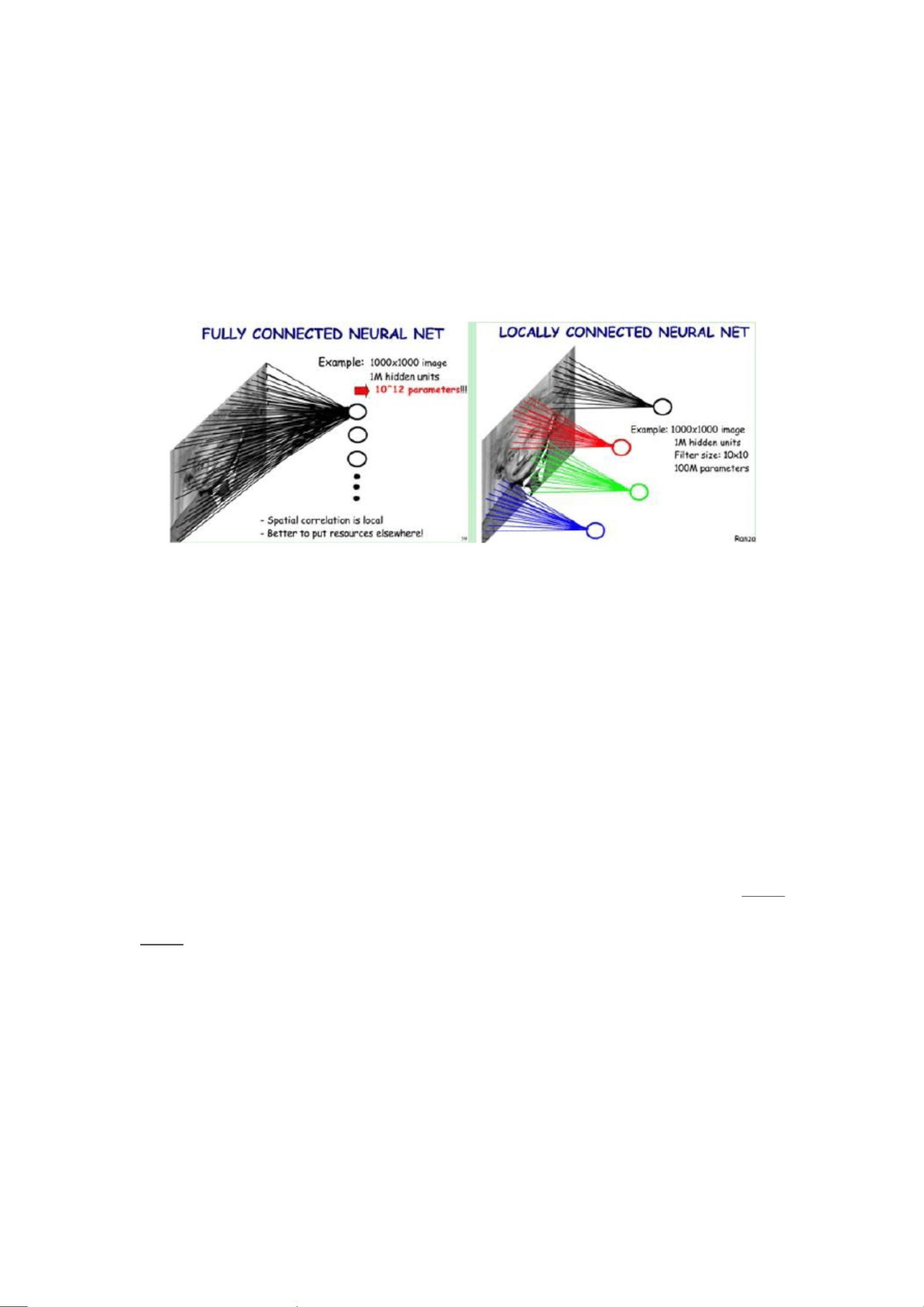

卷积神经网络(CNN)是一种深度学习模型,起源于20世纪60年代Hubel和Wiesel的研究,他们通过观察猫脑皮层中的神经元结构,发现了一种能有效降低反馈神经网络复杂性的局部连接网络,即卷积神经网络。CNN最初由Fukushima在1980年通过Neocognitron的形式实现,这个模型强调了神经元之间的局部连接性和图像的层次组织,实现了平移不变性。

LeCun等人在1986年引入了反向传播(BP)算法和权值共享(T-C问题)的概念,特别是LeNet-5模型(1998年),它是第一个被广泛接受的卷积神经网络模型,用于手写数字分类。尽管LeNet-5展示了直接从原始像素识别模式的能力,但由于当时的硬件限制,它在处理大规模图像和视频分类时表现不佳。

2006年,Geoffrey Hinton的工作标志着CNN的复兴,他的文章在《科学》期刊上发表,极大地推动了CNN的发展。此后,科学家们不断对CNN进行改进,比如引入更深的网络结构、更复杂的滤波器和池化层,以及批量归一化和Dropout等技术,这些都提升了网络的性能和泛化能力。

Krizhevsky等人在2012年的ImageNet竞赛中使用了深度卷积网络(Deep Convolutional Neural Networks,DCNN),尤其是AlexNet模型,取得了显著突破,开启了深度学习的黄金时代。他们通过大规模的数据集和GPU加速训练,显著提高了CNN在图像识别领域的准确率,从而引领了计算机视觉领域的革命。

现代CNN的应用广泛,涵盖了自动驾驶、医疗影像分析、自然语言处理中的文本图像结合、推荐系统等多个领域。它们的优势在于能够自动提取特征、学习空间不变性,减少了对人工特征工程的依赖。然而,CNN也存在计算成本高、对超参数敏感等问题,这促使研究者持续探索优化策略和新架构。

卷积神经网络的发展历程是一个从理论提出到实践应用的过程,随着技术进步和硬件的更新换代,CNN的性能不断提升,已成为人工智能领域不可或缺的重要工具。

2022-11-26 上传

2022-11-05 上传

112 浏览量

2022-07-13 上传

239 浏览量

2022-11-26 上传

xxpr_ybgg

- 粉丝: 6802

- 资源: 3万+

最新资源

- 2012年供电系统个人工作总结

- leetcode耗时-RCE-Pipeline:RCE-管道

- gulp:gulp打包工具,less转译压缩

- pandas-gbq-0.1.3.tar.gz

- ws-automate:使用Ansible在新的Debian(或Ubuntu)安装上快速设置Awesome WM和一些自定义配置

- ZhenhangTung.github.io:我的博客

- pandas-datareader-0.7.0.tar.gz

- leetcode耗时-LeetCode:许多LeetCode解决方案。为练习目的在C#中实现

- og-aws::orange_book:Amazon Web Services-实用指南

- 小学生值周工作总结

- 有道笔记PHP API (libNote) v1.0

- TableWidgetLoad.zip

- camtheman256.github.io:基于Next.js的新个人网站

- Utopia:不存在的完美语言

- leetcode耗时-LeetCode:来自LeetCode的各种问题

- cuisinierrebelle:Cuisinier Rebelle的官方网站!