Python爬虫实战:51job大数据项目招聘数据采集与分析

137 浏览量

更新于2024-06-27

1

收藏 1.96MB PDF 举报

"《大数据项目开发实训》是一份针对IT专业学生的实践教程,主要内容围绕大数据项目的开发过程展开。实训目标是利用Python编写爬虫程序,从知名招聘网站前程无忧网抓取数据,具体步骤包括以下几个关键环节:

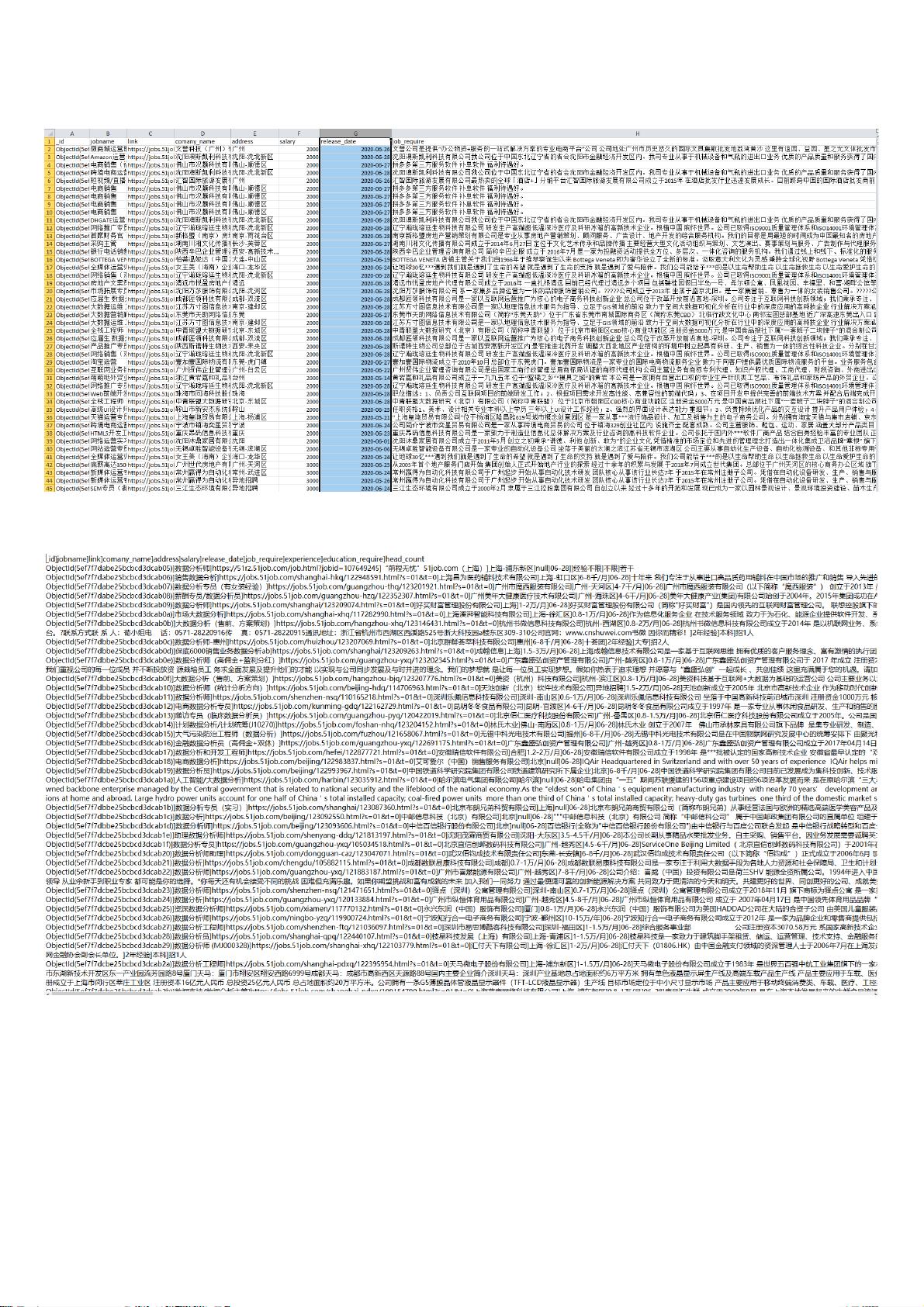

1. 数据采集:通过Scrapy框架,编写名为WuyouSpider的爬虫脚本,该脚本负责从指定的搜索页面(如针对Python或特定行业如大数据开发工程师的搜索结果)爬取职位名称、薪资水平、招聘单位、工作地点、工作经验、学历要求、岗位职责和技能要求等信息。start_urls定义了多个不同的搜索URL,以便覆盖不同类型的职位搜索。

2. 数据存储:爬取到的数据被存储到MongoDB数据库中,这是一个NoSQL数据库,适合处理大量、复杂的数据结构,便于数据管理。

3. 数据清洗与预处理:在将数据导入数据库之前,需要对数据进行清洗,去除重复、错误或者无关的信息,确保后续分析的质量。

4. 数据分析:利用Flume工具收集日志并将其导入Hadoop分布式文件系统(HDFS),这是大数据处理的基础架构。然后,通过Hive进行数据分析,Hive是一种基于Hadoop的数据仓库工具,支持SQL查询,方便进行统计和挖掘。

5. 数据迁移与整合:将Hive的分析结果使用Sqoop技术导入MySQL数据库,MySQL是关系型数据库,适合存储结构化的数据,便于进一步的数据处理和查询。

6. 结果展示与可视化:最后,将分析结果以图表或其他可视化形式呈现,帮助用户更直观地理解数据,发现趋势和洞察业务价值。这可能涉及到数据可视化库,如Tableau、Power BI等。

整个实训过程不仅锻炼了学生在Python编程、数据抓取、数据处理、数据库操作和数据分析等方面的能力,还涵盖了大数据生态中的各个环节,有助于提升对大数据项目的整体认识和实践经验。"

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-09-30 上传

101 浏览量

125 浏览量

2021-07-17 上传

2021-07-05 上传

2022-10-31 上传

是空空呀

- 粉丝: 198

最新资源

- 32位TortoiseSVN_1.7.11版本下载指南

- Instant-gnuradio:打造定制化实时图像和虚拟机GNU无线电平台

- PHP源码工具PHProxy v0.5 b2:多技术项目源代码资源

- 最新版PotPlayer单文件播放器: 界面美观且功能全面

- Borland C++ 必备库文件清单与安装指南

- Java工程师招聘笔试题精选

- Copssh:Windows系统的安全远程管理工具

- 开源多平台DimReduction:生物信息学的维度缩减利器

- 探索Novate:基于Retrofit和RxJava的高效Android网络库

- 全面升级!最新仿挖片网源码与多样化电影网站模板发布

- 御剑1.5版新功能——SQL注入检测体验

- OSPF的LSA类型详解:网络协议学习必备

- Unity3D OBB下载插件:简化Android游戏分发流程

- Android网络编程封装教程:Retrofit2与Rxjava2实践

- Android Fragment切换实例教程与实践

- Cocos2d-x西游主题《黄金矿工》源码解析