Hadoop MapReduce:大数据处理的关键技术

需积分: 3 177 浏览量

更新于2024-07-31

收藏 8.24MB PDF 举报

"Hadoop-0.20程序设计的相关PDF文档"

Hadoop是Apache软件基金会开发的一个开源框架,主要用于处理和存储大规模数据。这个文档,"hadoop-0.20_程式设计.pdf",主要介绍了Hadoop的核心组件——MapReduce的编程模型,以及其在大数据处理中的应用。

MapReduce是一种分布式计算模型,由Google提出,主要用于解决海量数据的并行计算问题。在文档中,"王耀聰"和"陈威宇"探讨了MapReduce在处理大数据集时面临的挑战。他们指出,与传统的网格计算(如MPI, PVM, Condor)相比,MapReduce更专注于如何有效地处理和分布大量的数据,而非仅仅分配计算任务。传统的计算方式在处理大文件时,可能会导致节点资源的饥饿,因为数据的本地存储和读取成为瓶颈。

文档强调了在处理大数据时的几个关键问题。例如,数据交换需要同步处理,可能导致死锁问题;有限的带宽限制了数据传输速度,而故障转移可能引发连锁失效。Google每月处理的数据量以PB计,远超单台计算机的内存或硬盘容量,这突显了对高效分布式计算的需求。

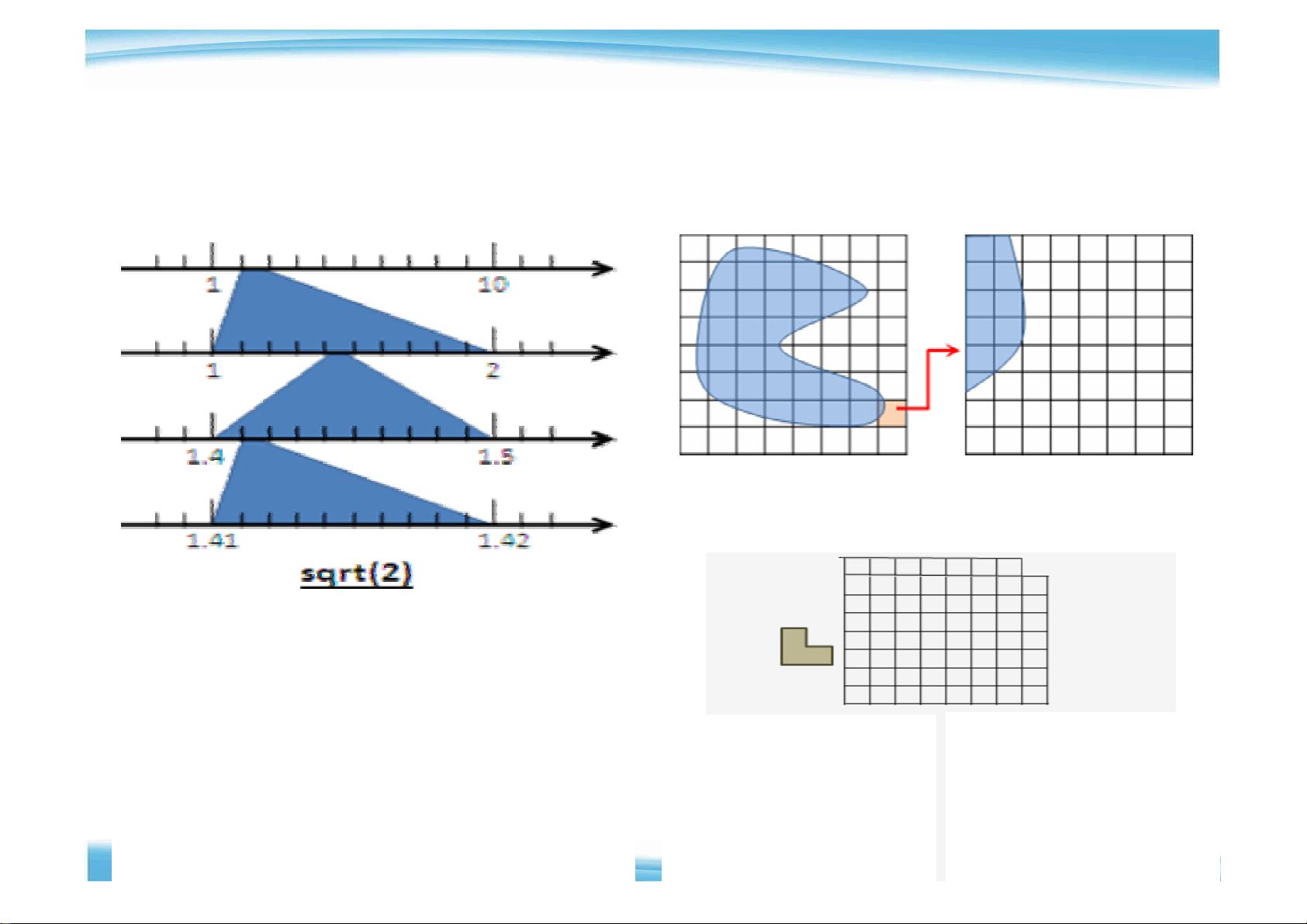

为了解决硬盘I/O速度慢的问题,文档提出了并行读取的解决方案。通过利用多个硬盘,可以显著提高数据读取速率,例如1000个硬盘可以达到每秒75GB的读取速度。这就是MapReduce的核心思想之一:通过分布式处理,克服硬件设备的局限。

MapReduce的设计目标是处理超过1TB的数据,并在大量CPU上进行交互计算,同时保持易用性。开发者无需关心底层的网络通信细节,只需关注业务逻辑,使用高阶的MapReduce API编写应用程序。MapReduce的结构基于函数式编程,它是一个批处理系统,具有内在的容错性,确保在集群环境中运行的可靠性。

Hadoop MapReduce是实现MapReduce模型的开源实现,它是Hadoop生态系统的重要组成部分。Hadoop MapReduce将大型数据集分割成小块,然后在分布式集群的节点上并行处理这些数据块,最后再将结果合并,从而实现了高效的数据处理能力。

这份文档深入剖析了Hadoop MapReduce在大数据处理中的作用,以及它如何通过MapReduce模型解决了传统计算方式在处理大数据时的挑战。它不仅介绍了MapReduce的基本概念和结构,还讨论了其实现方式以及在实际应用中的优势和策略。对于理解Hadoop和MapReduce在大数据环境中的工作原理及其重要性,这份文档提供了宝贵的信息。

2013-07-19 上传

2021-11-14 上传

2014-06-18 上传

2024-08-28 上传

2023-02-06 上传

2024-09-24 上传

2023-06-05 上传

2024-10-22 上传

错误: 找不到或无法加载主类 jar.usr.local.hadoop-3.1.4.share.hadoop.mapreduce.hadoop-mapreduce-examples-3.1.4.jar

2024-09-30 上传

2023-07-09 上传

book_xsliver

- 粉丝: 1

- 资源: 1

最新资源

- Aspose资源包:转PDF无水印学习工具

- Go语言控制台输入输出操作教程

- 红外遥控报警器原理及应用详解下载

- 控制卷筒纸侧面位置的先进装置技术解析

- 易语言加解密例程源码详解与实践

- SpringMVC客户管理系统:Hibernate与Bootstrap集成实践

- 深入理解JavaScript Set与WeakSet的使用

- 深入解析接收存储及发送装置的广播技术方法

- zyString模块1.0源码公开-易语言编程利器

- Android记分板UI设计:SimpleScoreboard的简洁与高效

- 量子网格列设置存储组件:开源解决方案

- 全面技术源码合集:CcVita Php Check v1.1

- 中军创易语言抢购软件:付款功能解析

- Python手动实现图像滤波教程

- MATLAB源代码实现基于DFT的量子传输分析

- 开源程序Hukoch.exe:简化食谱管理与导入功能