迁移学习:提升模型泛化与效率的关键技术

PDF格式 | 4.26MB |

更新于2024-06-14

| 162 浏览量 | 举报

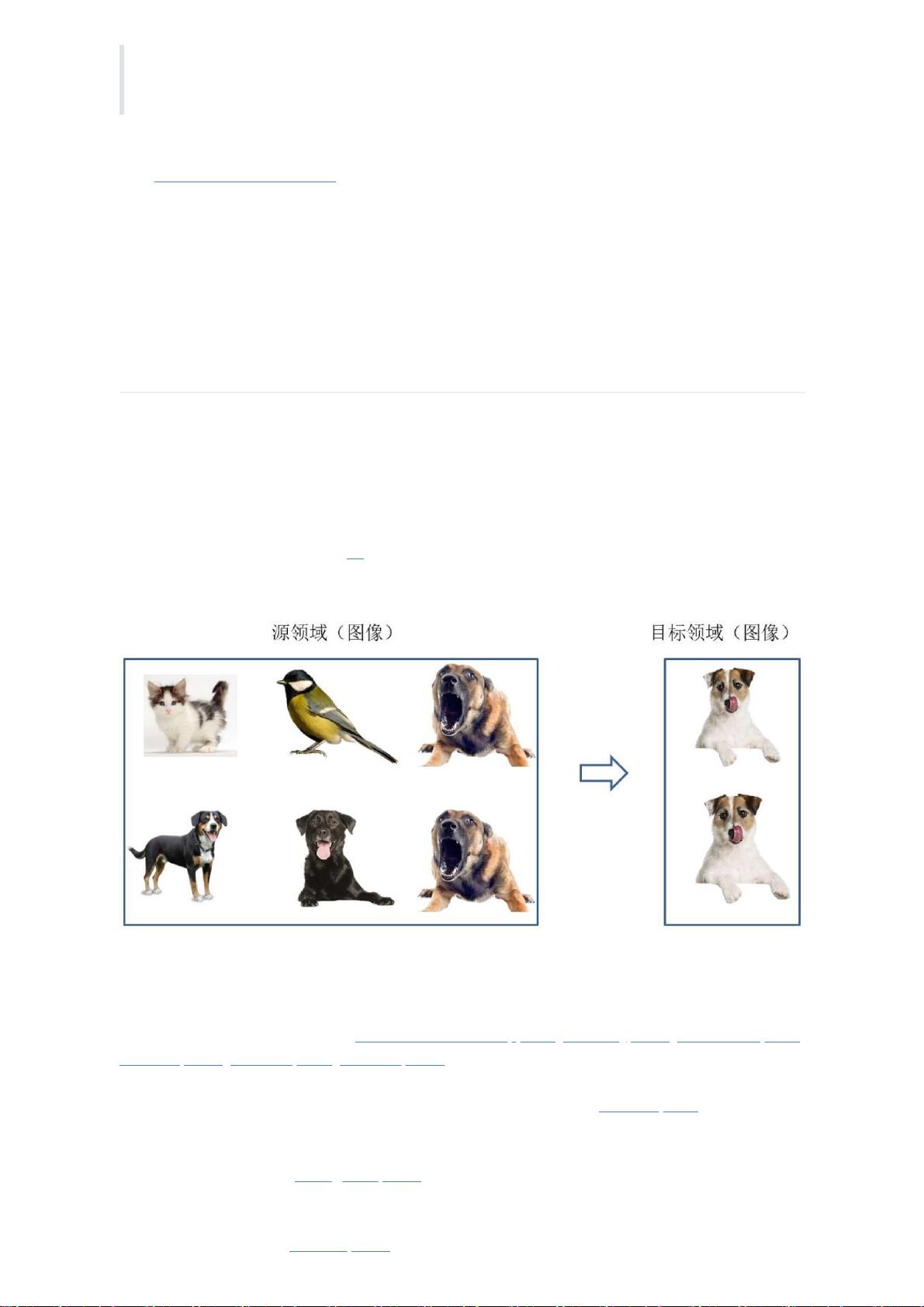

"本文档详细探讨了人工智能领域的迁移学习技术,着重强调了知识迁移和模型泛化的概念,以及它们在提高新任务学习效率中的作用。迁移学习被广泛应用于图像识别和自然语言处理,通过利用预训练模型的知识,提高在新任务上的表现,尤其在数据稀缺的场景下效果显著。文档涵盖了迁移学习的基础知识,包括其定义、必要性、基本问题、常用概念,以及与传统机器学习的区别。此外,还详细讨论了各种迁移学习策略,如基于样本、特征、模型和关系的迁移,以及数据分布自适应、特征对齐、流形学习等方法。特别提到了深度学习中的微调和自适应技术,以及GAN在迁移学习中的应用。"

迁移学习是一种机器学习技术,它利用在源任务上学习到的知识来改进目标任务的学习性能。在知识迁移的过程中,模型从已有的大量训练数据中学习到的特征和模式可以被重用,从而在面对新任务时减少训练时间和所需的数据量。这种技术尤其在处理小样本问题时显得尤为重要,因为它能够有效地克服数据不足带来的挑战。

为什么需要迁移学习?首先,大数据与少标注的矛盾使得无监督学习成为可能,但缺乏标注数据限制了模型的性能。迁移学习能利用未标注数据进行预训练,之后在少量标注数据上进行调整。其次,计算资源的局限性使得迁移学习成为解决大数据问题的有效手段。再者,迁移学习有助于创建更普适的模型,以适应多样化的个性化需求,如在用户隐私设置上进行微调。最后,对于新应用,如冷启动问题,迁移学习可以帮助快速构建初步的预测模型。

迁移学习的基本问题包括如何进行迁移(设计迁移方法)、迁移什么(选择合适的源任务和知识)、以及何时迁移(确定迁移的时机)。迁移学习的方法多种多样,例如基于样本的迁移关注样本的选择和权重分配,基于特征的迁移则侧重于找到源域和目标域之间的共享特征,而基于模型的迁移则涉及模型参数的转移和调整。此外,还有基于关系的迁移,它考虑了不同任务间的语义关系。

数据分布自适应是迁移学习的一个关键方面,目的是使源域和目标域的分布尽可能接近。这可以通过调整数据的边缘分布或条件分布来实现。概率分布自适应方法比较了不同方法的优缺点,而统计特征对齐则致力于消除源域和目标域之间的统计差异。流形学习则通过发现数据的低维结构来促进迁移。微调(finetune)是深度学习中常用的迁移学习策略,它在预训练模型的基础上针对新任务进行进一步的训练,以优化模型在目标任务上的性能。深度网络自适应和GAN(生成对抗网络)的应用进一步扩展了迁移学习的可能性,特别是在生成新数据和处理复杂任务时。

迁移学习是提升模型泛化能力、应对数据稀缺和复杂任务的关键工具。通过理解并熟练运用各种迁移学习策略,我们可以更好地在人工智能领域中实现知识的共享和模型的优化。

相关推荐

249 浏览量

660 浏览量

2024-05-24 上传

161 浏览量

137 浏览量

2023-08-24 上传

2023-07-25 上传

553 浏览量

2023-08-16 上传

fighting的码农(zg)-GPT

- 粉丝: 790

最新资源

- 深入理解Hadoop FS包的文件系统抽象机制

- Sybase客户端工具使用方法详解

- 创意几何形状商务工作总结PPT模板

- HTML5 Canvas实现小球走迷宫游戏教程

- 安卓仿航旅纵横APP开发:实现登录、航班查询等功能

- JSP溢洋论坛案例,初学者练手佳选

- kiftd-v1.0.20:私有云搭建和个人云盘的简易解决方案

- 西门子300通讯解决方案:SMARTGSD文件安装指南

- 实现带复选框的搜索式下拉列表

- 创意几何图形扁平商务风年终总结PPT模板

- 树莓派3上FFmpeg与x264的安装及配置指南

- Delphi窗体编程实例源码集详细解析

- HTML5星球射击游戏:防御小行星撞击

- Android重力感应控件教程与应用

- 实现距离测量功能的Flex与ArcGIS教程

- 实现带有复选框和搜索功能的下拉列表