斯坦福深度学习课程CS231n:卷积神经网络解析

需积分: 10 71 浏览量

更新于2024-07-18

收藏 2.43MB PDF 举报

"CS231n是斯坦福大学的一门课程,专注于深度学习在视觉识别中的应用,由Fei-Fei Li、Andrej Karpathy和Justin Johnson主讲。课程内容主要围绕卷积神经网络(Convolutional Neural Networks, CNN)展开,旨在教授学生如何利用CNN解决图像识别等视觉问题。"

在深度学习领域,卷积神经网络是图像处理和计算机视觉任务的核心技术之一。CNN的设计灵感来源于生物视觉系统,其独特之处在于能够自动学习图像特征,并且具有平移不变性,这使得它们在图像分类、目标检测、图像分割等领域表现出色。

在Lecture7中,课程可能涵盖了以下关键知识点:

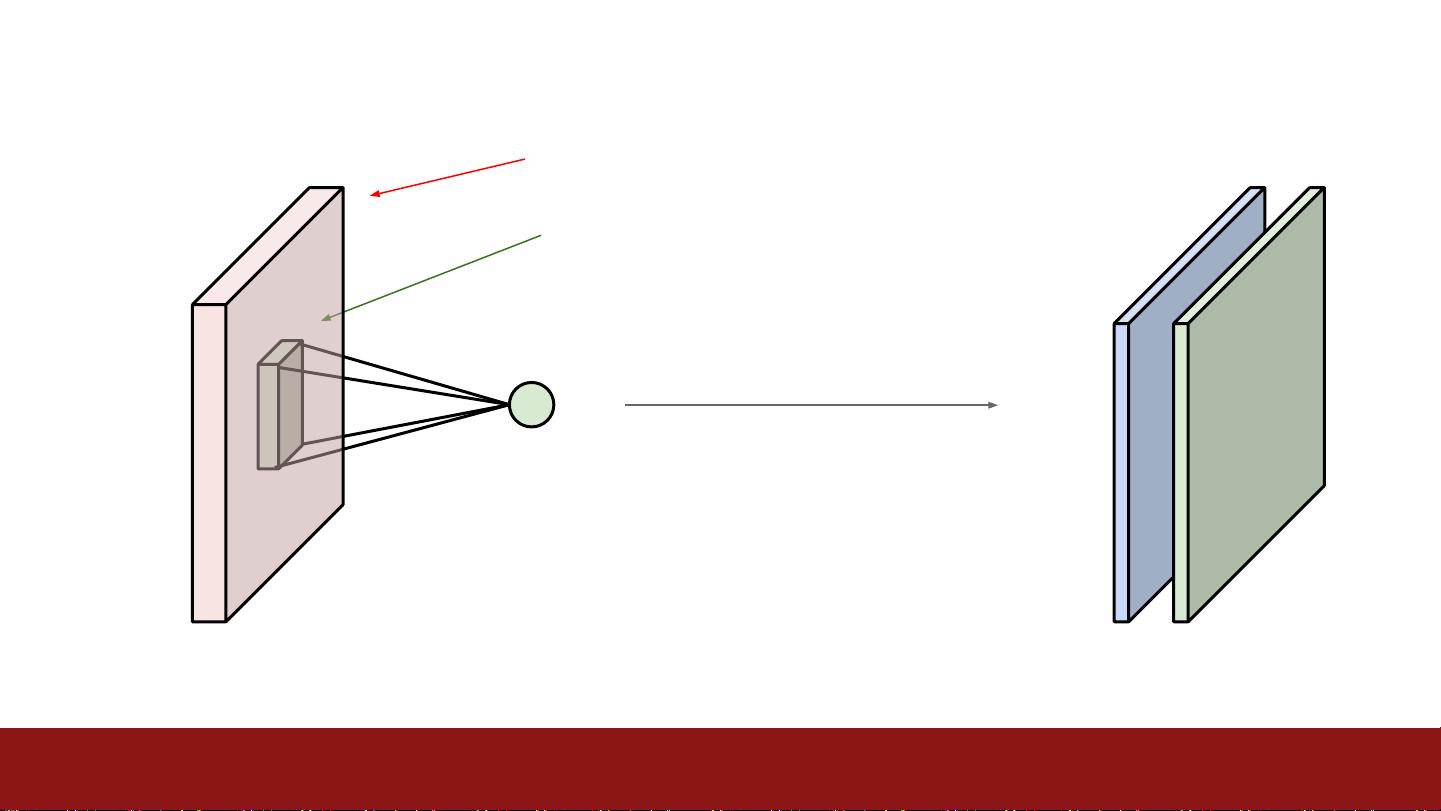

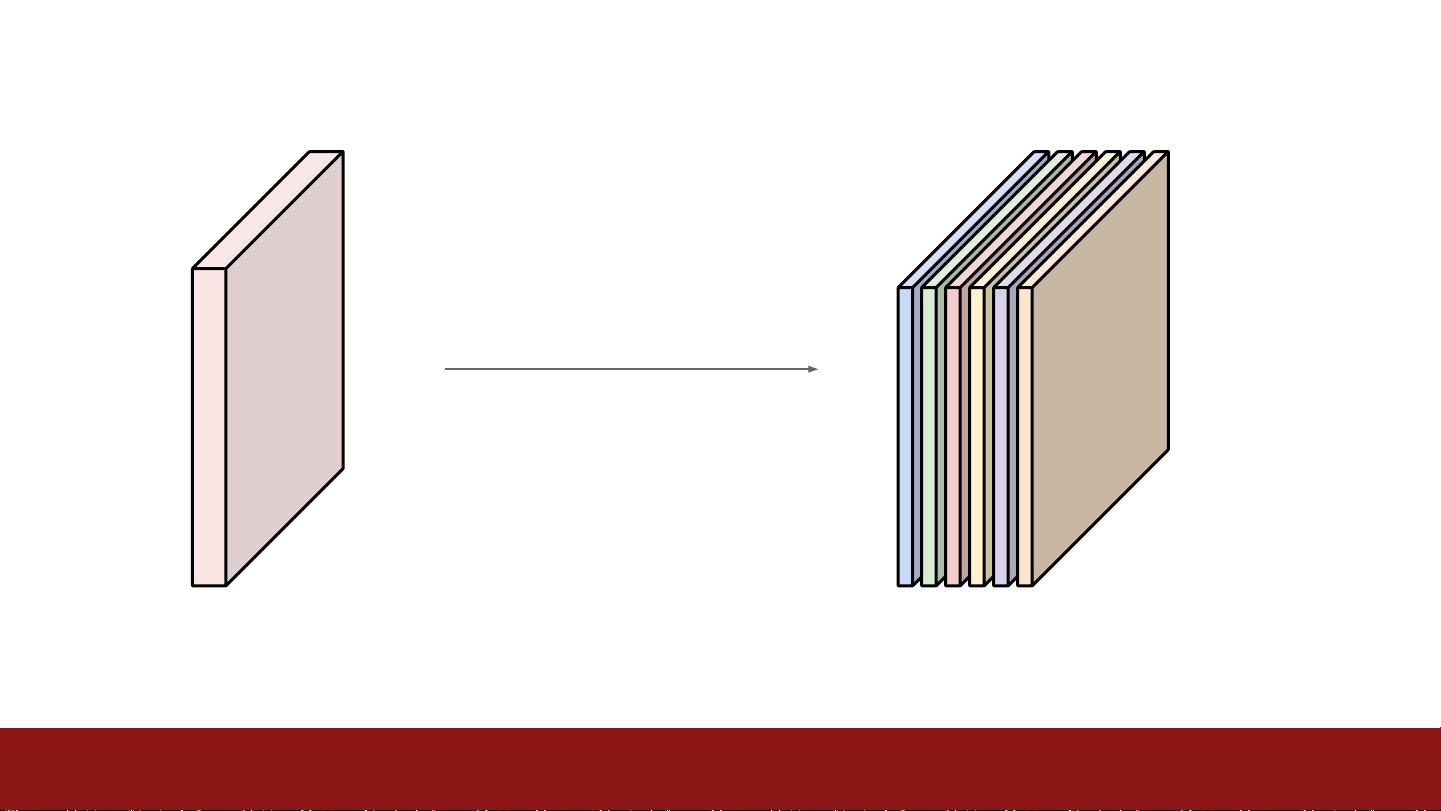

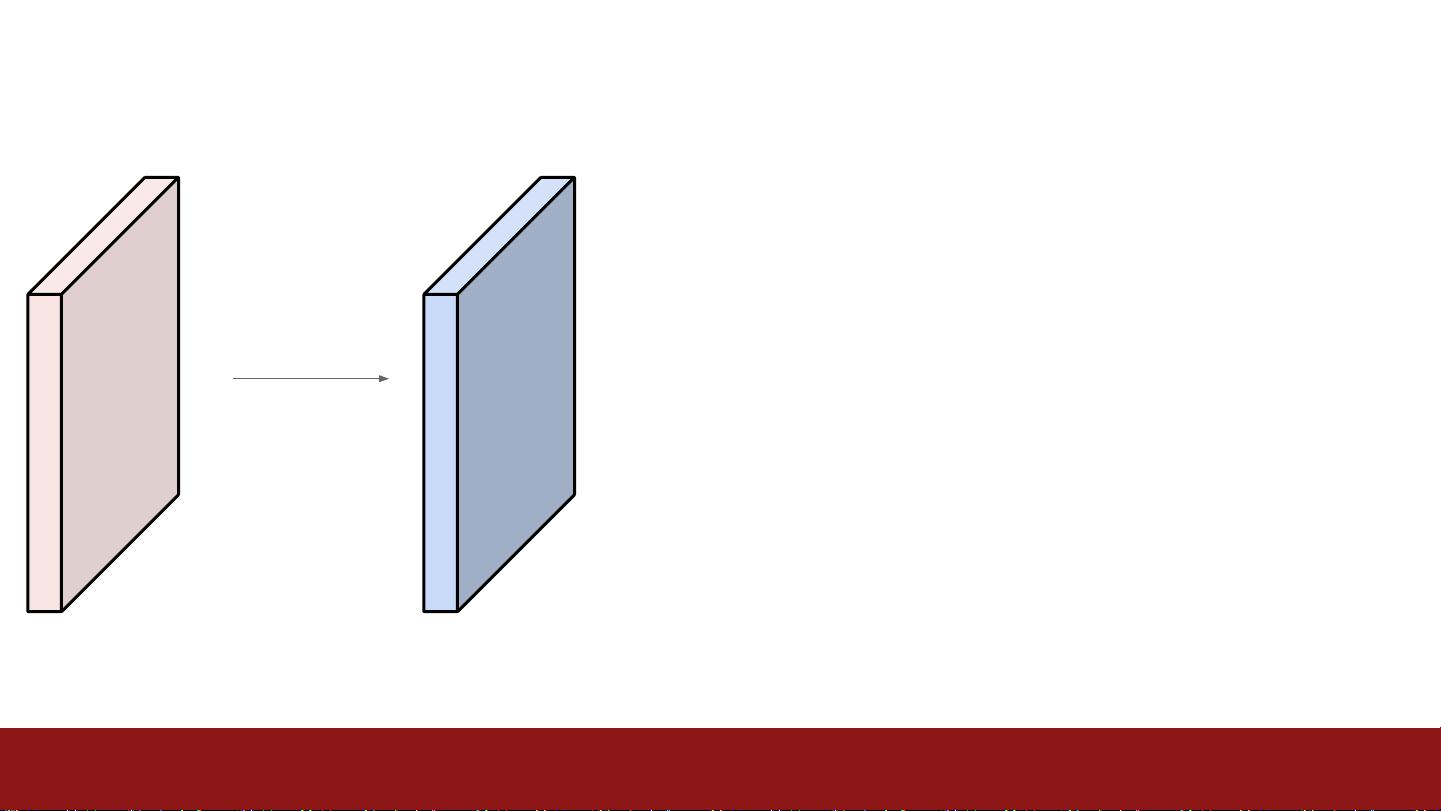

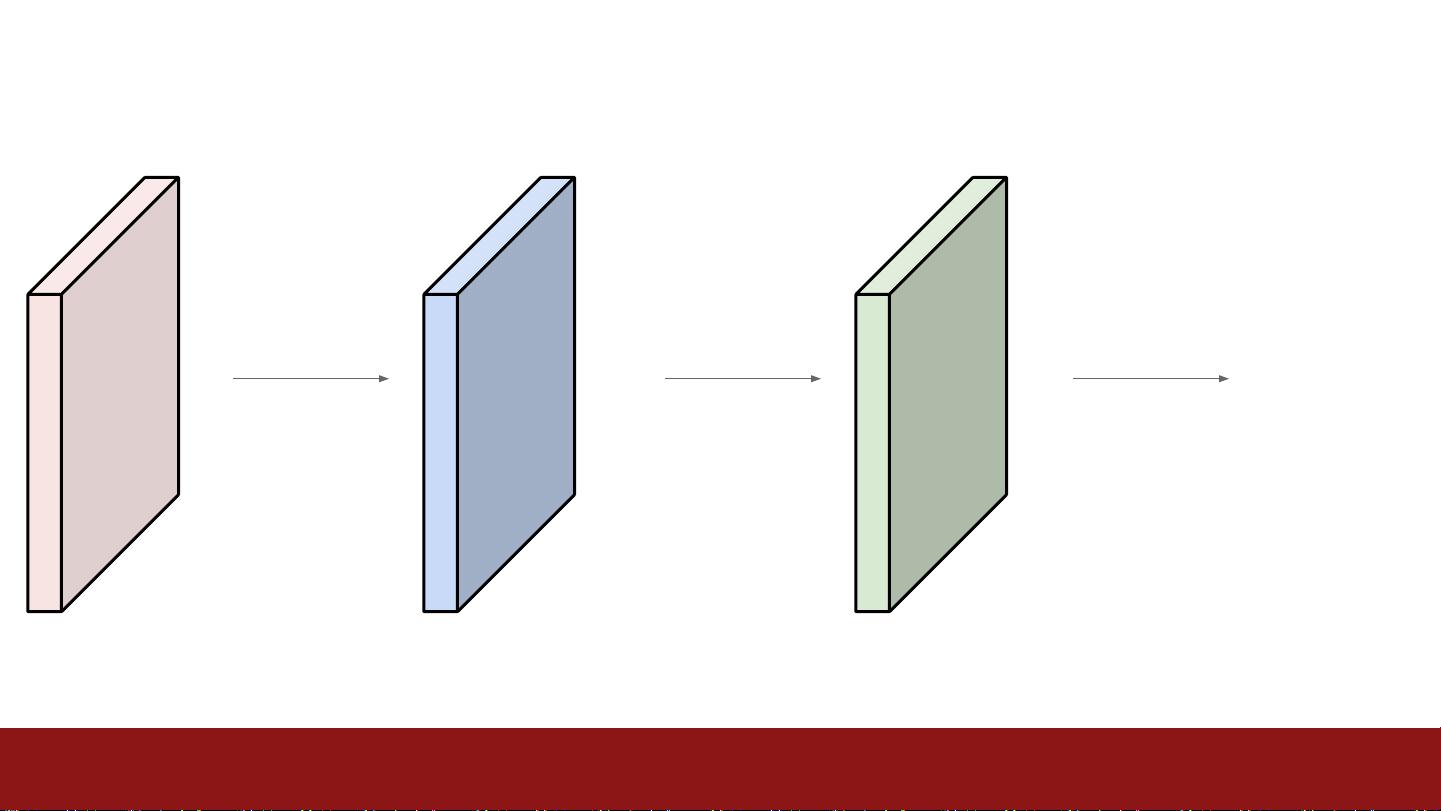

1. **卷积层(Convolutional Layer)**:卷积层是CNN的基础,它通过一组可学习的滤波器(或称为权值核)对输入图像进行扫描,生成特征映射。每个滤波器在所有位置上应用相同的权重,从而提取特定的特征。

2. **池化层(Pooling Layer)**:池化层用于减小数据的尺寸,降低计算复杂度,同时保持重要的特征信息。常见的池化操作有最大池化和平均池化。

3. **全连接层(Fully Connected Layer)**:在卷积层和池化层之后,通常会接一个或多个全连接层,将特征图展平并连接到传统的多层感知机(MLP),用于最终的分类决策。

4. **反向传播(Backpropagation)**:CNN训练过程中,反向传播算法用于更新网络权重,以最小化损失函数,实现模型的优化。

5. **批量归一化(Batch Normalization)**:为了加速训练过程并提高模型的泛化能力,通常会在每一层的激活函数前或后加入批量归一化步骤。

6. **激活函数(Activation Function)**:ReLU(Rectified Linear Unit)是最常用的激活函数,但课程可能还会讨论其他函数如Sigmoid、Tanh以及Leaky ReLU等。

7. **损失函数(Loss Function)**:对于分类任务,交叉熵损失函数常被使用。对于多类别问题,可能会介绍softmax交叉熵损失。

8. **优化器(Optimizer)**:如梯度下降、随机梯度下降(SGD)、动量优化(Momentum)、Adam等,它们在训练过程中调整权重更新速度和方向。

9. **超参数(Hyperparameters)**:如学习率、批大小、正则化强度等,对模型性能有很大影响,需要通过实验来调整。

10. **数据增强(Data Augmentation)**:为了增加模型的泛化能力,通常会采用旋转、翻转、缩放等方法对训练数据进行扩充。

项目提案的要求涉及了研究问题的阐述、数据来源、所用方法、预期改进、背景阅读和结果评估等多个方面,旨在帮助学生形成清晰的研究计划,并确保他们能够深入理解并应用所学知识。

2017-04-19 上传

2021-02-05 上传

2022-07-13 上传

2022-07-13 上传

2021-04-18 上传

2021-04-03 上传

Prange

- 粉丝: 0

- 资源: 1

最新资源

- CRUD-JS

- 这是一个简单弹出视图

- PruebaV-V_Verde:佛得角

- Extract data from an existing .fig file:Extract data from an existing matlab 2D or 3D figure-matlab开发

- 行业分类-设备装置-接触网整体吊弦恒张力预制平台.zip

- LiveSplit.GBA:BizHawk中GBA模拟器的通用自动拆分器

- 设计:Tidyverse设计原则

- analyze_mcmc.rar_Windows编程_FlashMX_

- matlab转换java代码-POSTaggerSML:Stanford-MATLAB词性标注器:MATLAB所采用的StanfordLog-

- p2pshaper-开源

- 参考资料-27建筑施工企成本管理办法.zip

- krautadmin:KrautAdmin-基于服务器的兄弟情谊应用程序

- 在应用添加AdMob广告案例

- myfifo.rar_VHDL/FPGA/Verilog_VHDL_

- angularJs-datatable

- SQLWeek3