解决机器学习模型欠规范问题的策略

161 浏览量

更新于2024-06-19

收藏 2.19MB PDF 举报

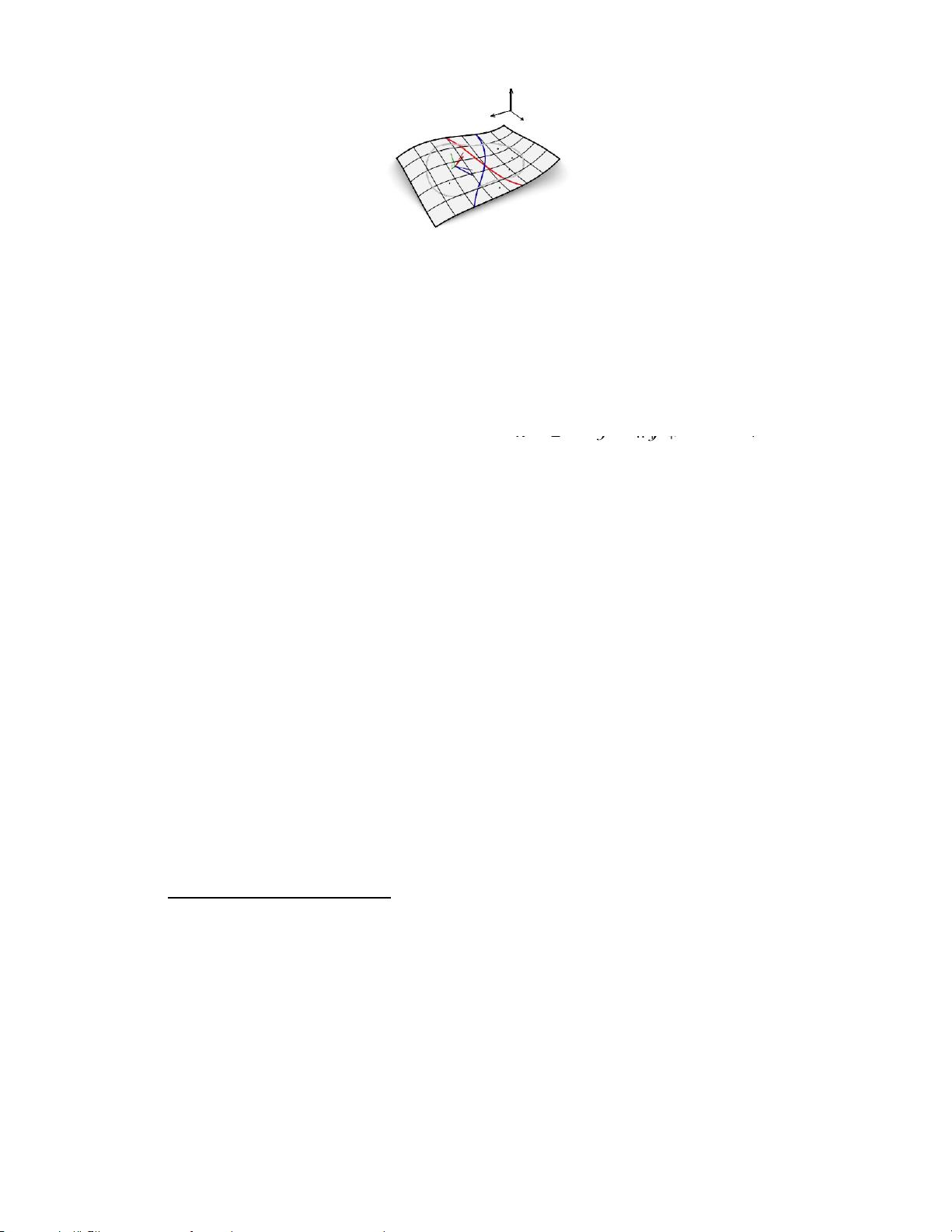

"本文主要探讨了机器学习模型的欠规范问题及其解决方法。欠规范是指在数据集中,尽管模型在精度上表现良好,但可能存在多个模型在不同属性上,如分布外(OOD)性能上存在显著差异。这使得仅依靠预测准确性评估模型的可靠性变得困难。作者提出了一种形式化欠规范的概念,并设计了一种策略来识别和部分解决这个问题。通过独立训练多个模型并利用约束优化,他们能够揭示标准经验风险最小化(ERM)忽视的预测特征,然后将这些特征整合到一个具有优秀OOD性能的全局模型中。此外,他们强调了模型需要与数据流形对齐,以确保发现有意义的特征。这种方法在多个计算机视觉数据集上进行了验证,并表明没有额外假设,仅凭域内性能无法评估OOD模型的选择。欠规范问题在图像识别等任务中尤为突出,因为某些任务需要额外的领域知识才能正确泛化,而这些知识可能无法仅从数据中学习到。"

在机器学习中,欠规范问题是一个核心挑战,它指出即使模型在训练数据上的表现很好,也可能无法捕捉到所有理想属性,尤其是与领域专家对任务理解的匹配程度。欠规范问题的存在可能导致模型在未见过的数据上表现不佳,比如分布外泛化。为了解决这个问题,研究者提出了一个方法,通过独立训练多个模型并施加独立性约束,促进模型学习不同的预测特征。这种方法有助于发现那些在标准训练过程中被忽视的特征,这些特征可以提高模型的泛化能力,特别是在OOD情况下的性能。

论文中提到的计算机视觉领域的例子,强调了在图像识别任务中,模型需要学习到区分对象和背景的特征,而这些特征可能不会在训练数据中自然出现。因此,引入额外的归纳偏差或领域知识对于构建鲁棒的模型至关重要。通过这种方法,研究者能够在多个数据集上展示出改善模型性能的潜力,同时也提醒了我们在评估模型时不应只依赖于域内性能,而应考虑更广泛的评估指标,特别是对于分布外泛化的评估。

欠规范问题提醒我们,机器学习模型的优化不应仅仅局限于训练数据上的预测准确度,还需要关注模型在新环境和未知条件下的表现。通过深入理解和解决欠规范问题,我们可以构建出更加可靠和泛化的机器学习模型。

2024-03-21 上传

2023-07-11 上传

2023-05-30 上传

2023-06-12 上传

2023-06-09 上传

2023-06-01 上传

2023-12-23 上传

2023-08-14 上传

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- JDK 17 Linux版本压缩包解压与安装指南

- C++/Qt飞行模拟器教员控制台系统源码发布

- TensorFlow深度学习实践:CNN在MNIST数据集上的应用

- 鸿蒙驱动HCIA资料整理-培训教材与开发者指南

- 凯撒Java版SaaS OA协同办公软件v2.0特性解析

- AutoCAD二次开发中文指南下载 - C#编程深入解析

- C语言冒泡排序算法实现详解

- Pointofix截屏:轻松实现高效截图体验

- Matlab实现SVM数据分类与预测教程

- 基于JSP+SQL的网站流量统计管理系统设计与实现

- C语言实现删除字符中重复项的方法与技巧

- e-sqlcipher.dll动态链接库的作用与应用

- 浙江工业大学自考网站开发与继续教育官网模板设计

- STM32 103C8T6 OLED 显示程序实现指南

- 高效压缩技术:删除重复字符压缩包

- JSP+SQL智能交通管理系统:违章处理与交通效率提升