深度学习分类网络解析:从Le-net到ResNet

需积分: 44 60 浏览量

更新于2024-07-18

1

收藏 1.64MB PDF 举报

"本文主要对深度学习中的目标分类网络进行了总结,涵盖了从早期的LeNet到现代的ResNet和SE Net等一系列重要模型,包括它们的关键结构和特点。"

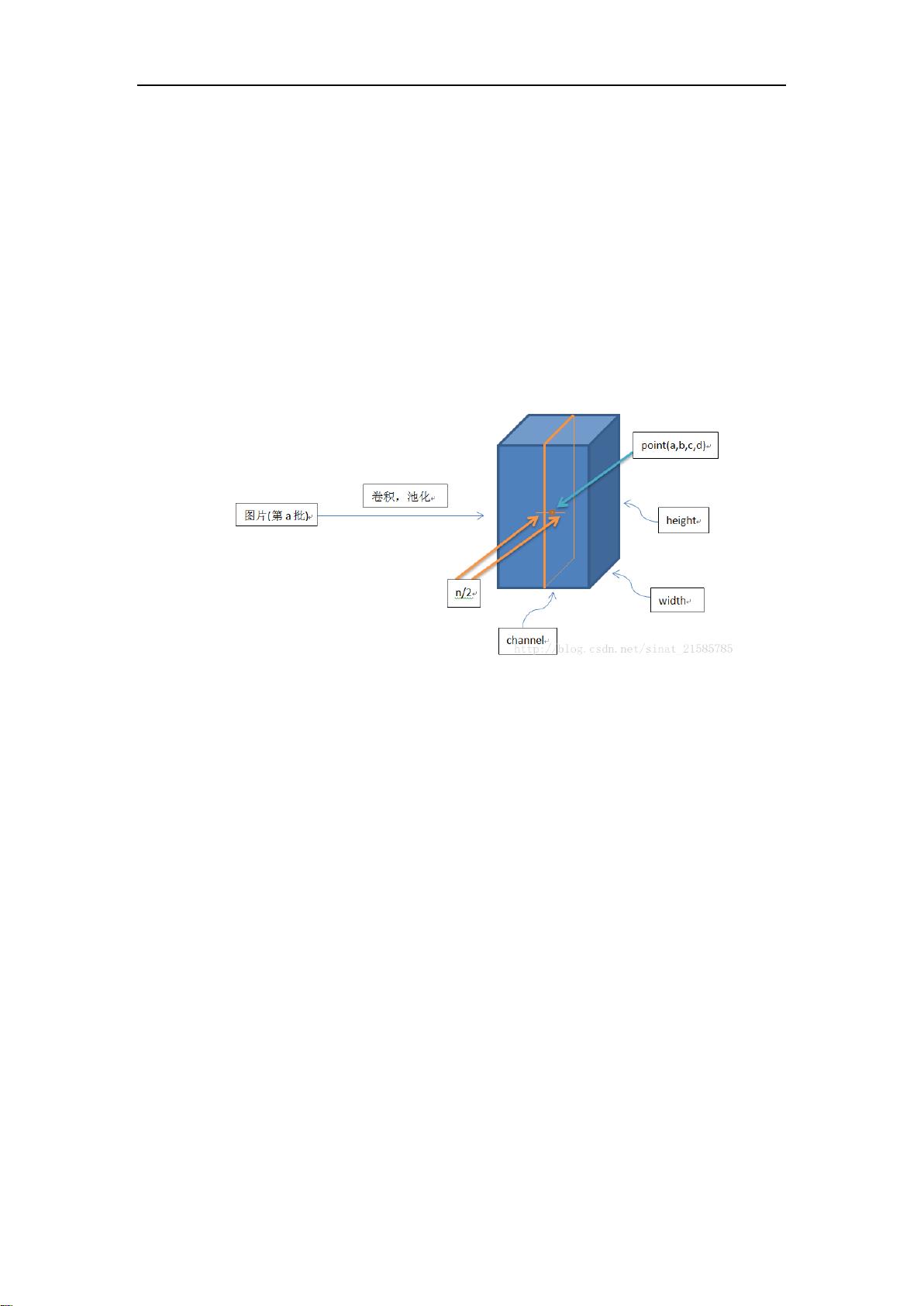

深度学习在图像识别领域取得了显著的成就,其中目标分类网络是核心组成部分。本文重点介绍了几个关键的卷积神经网络(CNN)模型,它们对现代计算机视觉技术的发展起到了重要作用。

首先,LeNet,由Yann LeCun等人在1998年提出,是最早的CNN之一,主要用于手写数字识别。LeNet5的特点包括:

1. 使用卷积、池化和非线性激活函数(如双曲线tanh或Sigmoid)的序列结构。

2. 卷积层用于提取空间特征。

3. 使用空间下采样(如平均池化)来减少计算复杂度。

4. 多层感知机(MLP)作为最终的分类器。

5. 层间采用稀疏连接,降低了计算成本。

接下来是AlexNet,由Alex Krizhevsky在2012年的ImageNet比赛中引入,它在当时的图像识别任务中表现卓越,主要特点有:

1. 深度网络结构,包含多个卷积层和全连接层。

2. 使用ReLU激活函数,提高了训练速度和性能。

3. 在卷积层后添加了局部响应归一化(LRN),增强了特征的泛化能力。

4. 通过分割数据并在两个GPU上并行处理,减小了内存需求。

5. 最大池化层用于进一步降维和增强鲁棒性。

然后,我们有VGGNet,由Oxford大学的Visual Geometry Group提出,其特点是:

1. 使用小尺寸(3x3)卷积核,通过堆叠多层来增加网络深度。

2. 这种设计导致了大量的参数,但提升了特征表示的复杂性。

GoogLeNet(Inception V1-V3)则是以更高效的方式构建深层网络,通过并行的卷积块(不同大小的卷积核和池化操作)来捕获不同尺度的特征。

ResNet(残差网络)由Kaiming He等人提出,解决了深度网络中的梯度消失问题,通过引入残差块实现信息的直接传递。

1. 残差块允许网络学习“跳过”某些层,使得训练极深的网络成为可能。

SE Net(Squeeze-and-Excitation Network)引入了注意力机制,通过自适应地调整每个通道的重要性来优化特征表示。

MobileNet和ShuffleNet则针对移动设备进行了优化,使用深度可分离卷积和通道混合技术降低了计算量,保持了识别性能。

这些网络模型的不断演进展示了深度学习在图像识别领域的强大能力,并推动了相关技术的进步。理解这些模型的核心设计理念和结构对于深度学习研究者和实践者来说至关重要。

139 浏览量

179 浏览量

2021-09-25 上传

2022-01-16 上传

2021-09-26 上传

170 浏览量

631 浏览量

小北小白

- 粉丝: 35

- 资源: 3

最新资源

- onthedollar-api:税额计算器

- IT385

- Software-Testing

- OpenCvSharp从入门到实践-(01)认识OpenCvSharp&开发环境搭建 Demo

- 更好的恐慌-受Python的回溯启发而产生的非常恐慌的回溯-Rust开发

- 行业文档-设计装置-高中英语教学用划线器.zip

- 文件上传必备jar包fileupload与io.rar

- Python图像处理PCA算法完整源码

- bewitchedlogin.github.io:bla bla bla bla bla

- sample

- 智睿学校网上评课系统 v8.4.0

- printf_on_BIOS

- 世界之窗浏览器(TheWorld) v5.0 Beta

- GIS-Portfolio

- 项目管理案例研究:项目:“诺尔特制造工厂的工厂分析集成”-IST 645管理信息系统项目

- Angkor_website:网页设计与开发班的学校项目