Hadoop平台选择指南:解析Apache、发行版与大数据套件

181 浏览量

更新于2024-08-27

收藏 154KB PDF 举报

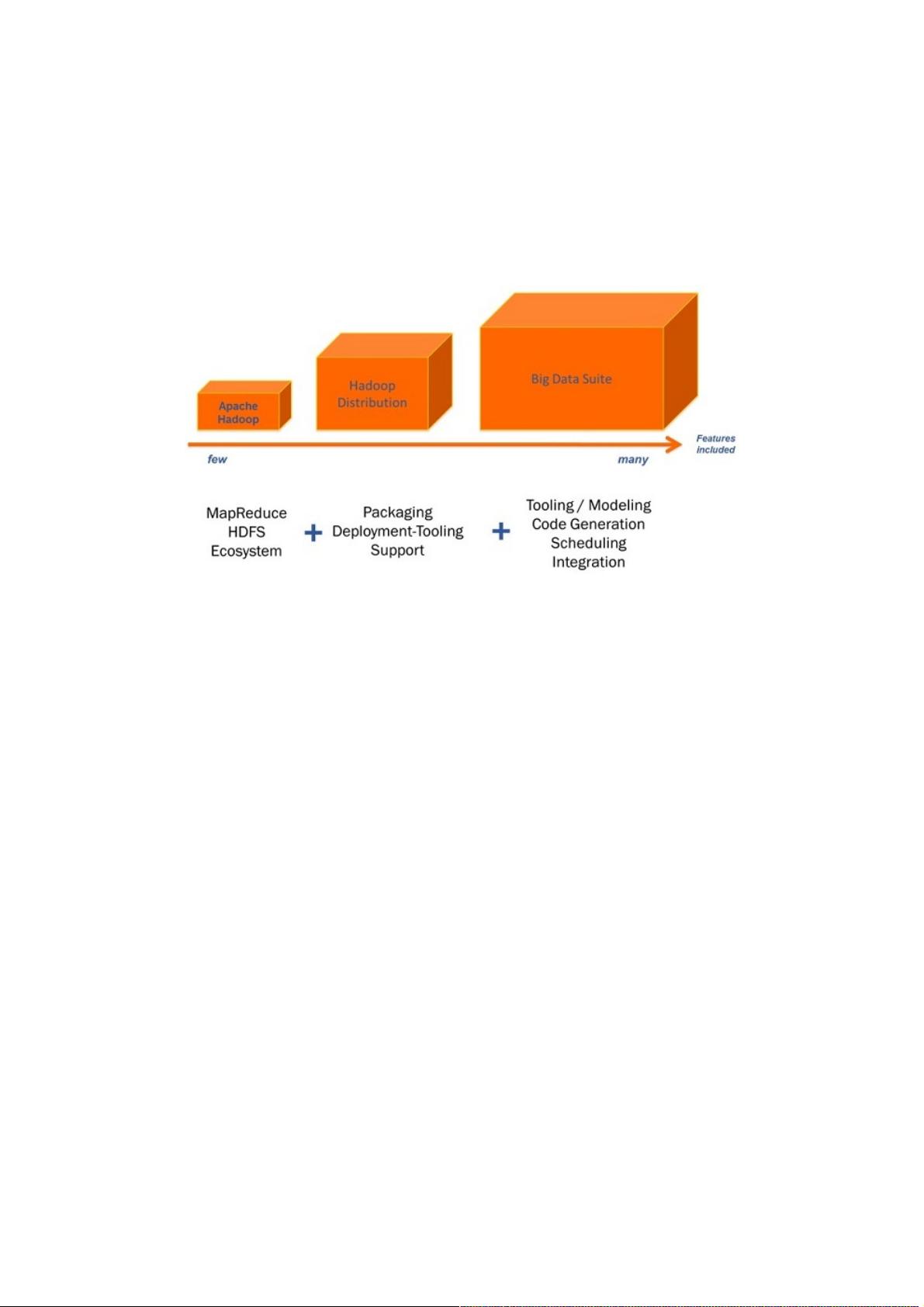

选择合适的大数据或Hadoop平台是一个关键决策,因为这直接影响到数据分析的效率和项目的成功。Hadoop作为大数据处理的事实标准,被众多大型企业如IBM、Oracle、SAP和Microsoft采纳。面对多样化的Hadoop产品,选择过程可能会显得复杂。

首先,Apache Hadoop是最基础的选择,包括通用模块、HDFS、YARN和MapReduce。其分布式文件系统HDFS提供了高吞吐量的数据访问,YARN是资源管理和作业调度框架,而MapReduce则用于大数据的并行处理。初学者可以通过简单的本地安装进行学习,但构建多节点集群则需要复杂的配置工作,涉及如权限和访问控制的管理。

其次,Hadoop的生态系统非常丰富,包含诸如Pig(用于高级数据处理的语言)、Hive(SQL-like查询工具)、HBase(NoSQL数据库)、ZooKeeper(分布式协调服务)等多个项目。这些项目虽然独立,但也相互协作,构成了强大的大数据处理环境。对于想要利用整个Hadoop生态的组织来说,直接使用Apache的原始版本可能需要投入更多时间和精力来集成和维护。

接下来,考虑使用Hadoop的发行版,例如Cloudera、 Hortonworks、MapR等,它们提供预配置的解决方案,通常包括Hadoop以及其他相关工具的集成,简化了部署和管理。这些发行版针对特定场景进行了优化,比如安全性、性能或企业级支持,适合有一定规模和需求的企业。

最后,大数据套件如IBM BigInsights、Oracle Big Data Appliance或Microsoft Azure HDInsight,它们将Hadoop与额外的分析工具、数据库和其他服务打包在一起,为企业提供一站式的大数据解决方案。这些套件特别适合需要快速实施且对集成度有较高要求的公司。

在选择合适的Hadoop平台时,应考虑以下因素:

1. 技术熟练程度:团队是否具备足够的Hadoop知识和经验,或者是否需要现成的解决方案。

2. 集成需求:是否需要与现有IT基础设施无缝对接,包括数据库、BI工具等。

3. 性能和扩展性:根据数据规模和处理速度的需求,选择相应的平台。

4. 安全性和合规性:确保所选平台符合公司的安全标准和法规要求。

5. 支持和服务:考虑供应商提供的技术支持、培训和更新服务。

选择大数据或Hadoop平台需要全面评估自身需求、技术能力和预算,从Apache Hadoop到发行版再到大数据套件,每种选项都有其优缺点和适用场景,选择最适合自己的方案至关重要。

105 浏览量

2022-06-04 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38675232

- 粉丝: 3

- 资源: 970

最新资源

- C++标准程序库:权威指南

- Java解惑:奇数判断误区与改进方法

- C++编程必读:20种设计模式详解与实战

- LM3S8962微控制器数据手册

- 51单片机C语言实战教程:从入门到精通

- Spring3.0权威指南:JavaEE6实战

- Win32多线程程序设计详解

- Lucene2.9.1开发全攻略:从环境配置到索引创建

- 内存虚拟硬盘技术:提升电脑速度的秘密武器

- Java操作数据库:保存与显示图片到数据库及页面

- ISO14001:2004环境管理体系要求详解

- ShopExV4.8二次开发详解

- 企业形象与产品推广一站式网站建设技术方案揭秘

- Shopex二次开发:触发器与控制器重定向技术详解

- FPGA开发实战指南:创新设计与进阶技巧

- ShopExV4.8二次开发入门:解决升级问题与功能扩展