深度学习中的线性代数基石:求解与特征分解

需积分: 9 135 浏览量

更新于2024-09-09

收藏 229KB DOCX 举报

深度学习是一门强大的机器学习分支,其理论基础之一便是线性代数。线性代数在深度学习中扮演着至关重要的角色,它提供了解决问题的数学工具和技术,使模型能够理解和处理复杂的数据结构。

首先,理解线性方程组对于深度学习至关重要。线性方程组分为齐次线性方程组(所有常数项均为0)和非齐次线性方程组(至少有一个非零常数项)。非齐次线性方程组求解的关键在于矩阵的性质。当我们面对一个m行n列的矩阵A和一个m维列向量b,可以通过求逆矩阵A^(-1)来找到解x=A^(-1)b,前提是矩阵A是可逆的(即非奇异矩阵),即它有m个线性无关的列向量。若A不可逆,即为奇异矩阵,虽然仍有解,但不能直接用逆矩阵方法求解。

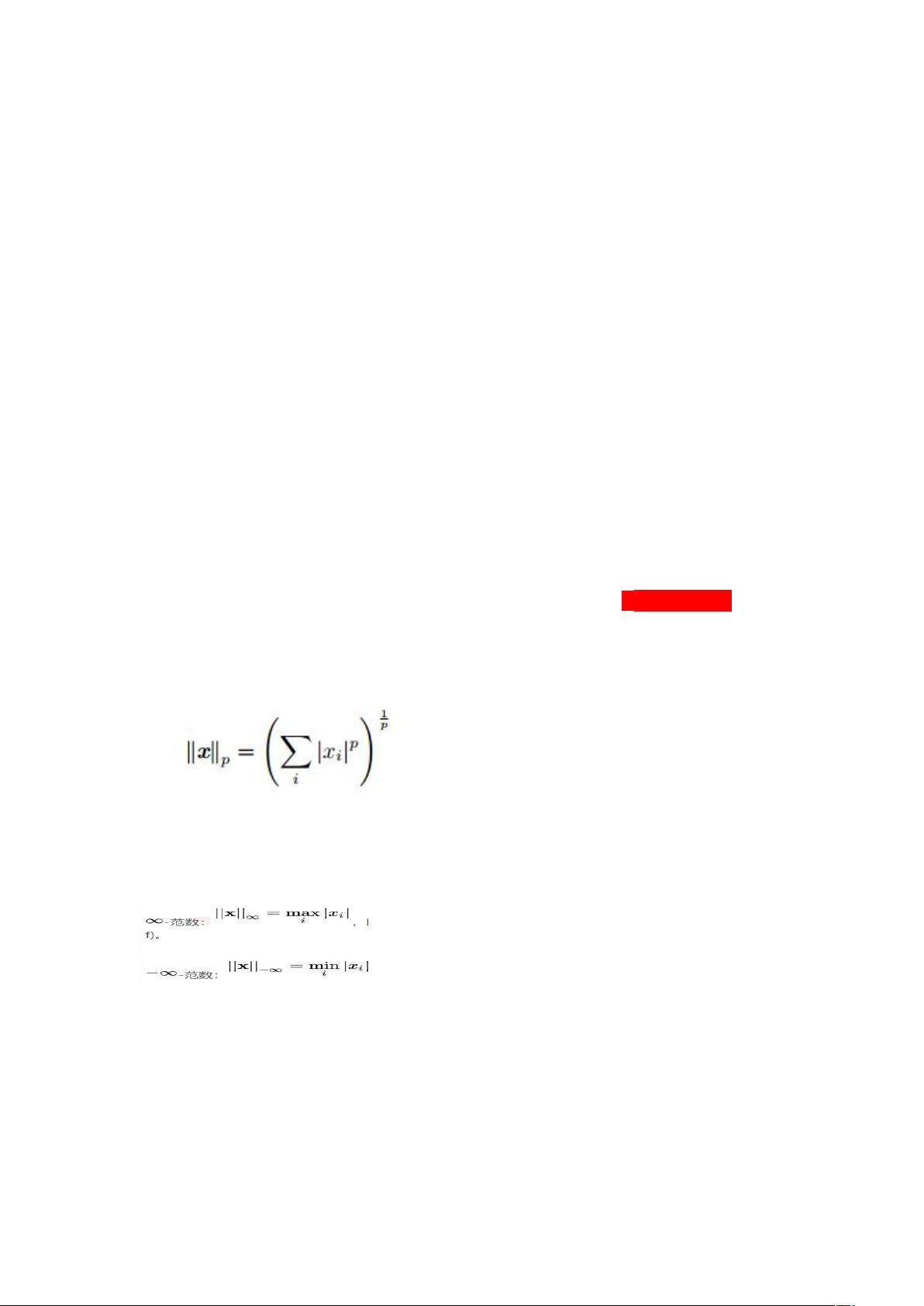

向量范数是衡量向量大小的标准,对于深度学习模型训练的优化过程很重要。1范数(绝对值之和)对应于曼哈顿距离,而2范数(欧几里得范数)对应于欧式距离,它们在计算距离和权重更新时有不同应用。p范数则提供了更广泛的范数定义。这些概念在神经网络中的权重参数调整和正则化中起着关键作用。

对角矩阵和单位矩阵是矩阵的重要特例,对角矩阵除了主对角线上元素外其余皆为0,单位矩阵则主对角线上全为1。它们在矩阵运算和简化问题中起到简化的作用。正交矩阵满足A^T·A=AA^T=I,即其转置矩阵与其自身相乘等于单位矩阵,这在降维和特征提取中非常常见。

奇异矩阵是指至少有一组线性相关的列向量的方阵,具有特殊的性质,如其行列式为0或有零特征值。与非奇异矩阵相反,奇异矩阵可能导致线性方程组有无穷多解或无解。非奇异矩阵,即可逆矩阵,其特征为行列式非零,对应的方程组有唯一解。

特征分解是线性代数中的核心概念,特别是对于方阵A。通过特征分解,矩阵A可以表示为一组特征向量和相应的特征值的乘积,这有助于理解矩阵的行为。特征向量对于理解矩阵操作如何保持或改变向量的方向和尺度至关重要,特别是在深度学习中的权重初始化和卷积神经网络的滤波器设计中。

掌握线性代数的这些基本概念和性质对于深入理解深度学习模型的工作原理、优化算法以及如何处理和分析数据至关重要。通过将线性代数的理论与实际应用相结合,可以提升深度学习模型的性能和效率。

2021-05-20 上传

2020-12-22 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情