大规模数据集驱动的深度学习:立体匹配、光流与场景流估计

下载需积分: 50 | PPTX格式 | 6.78MB |

更新于2024-07-18

| 70 浏览量 | 举报

标题:“立体匹配PPT:基于深度学习的视差、光流和场景流估计大型数据集及网络架构”

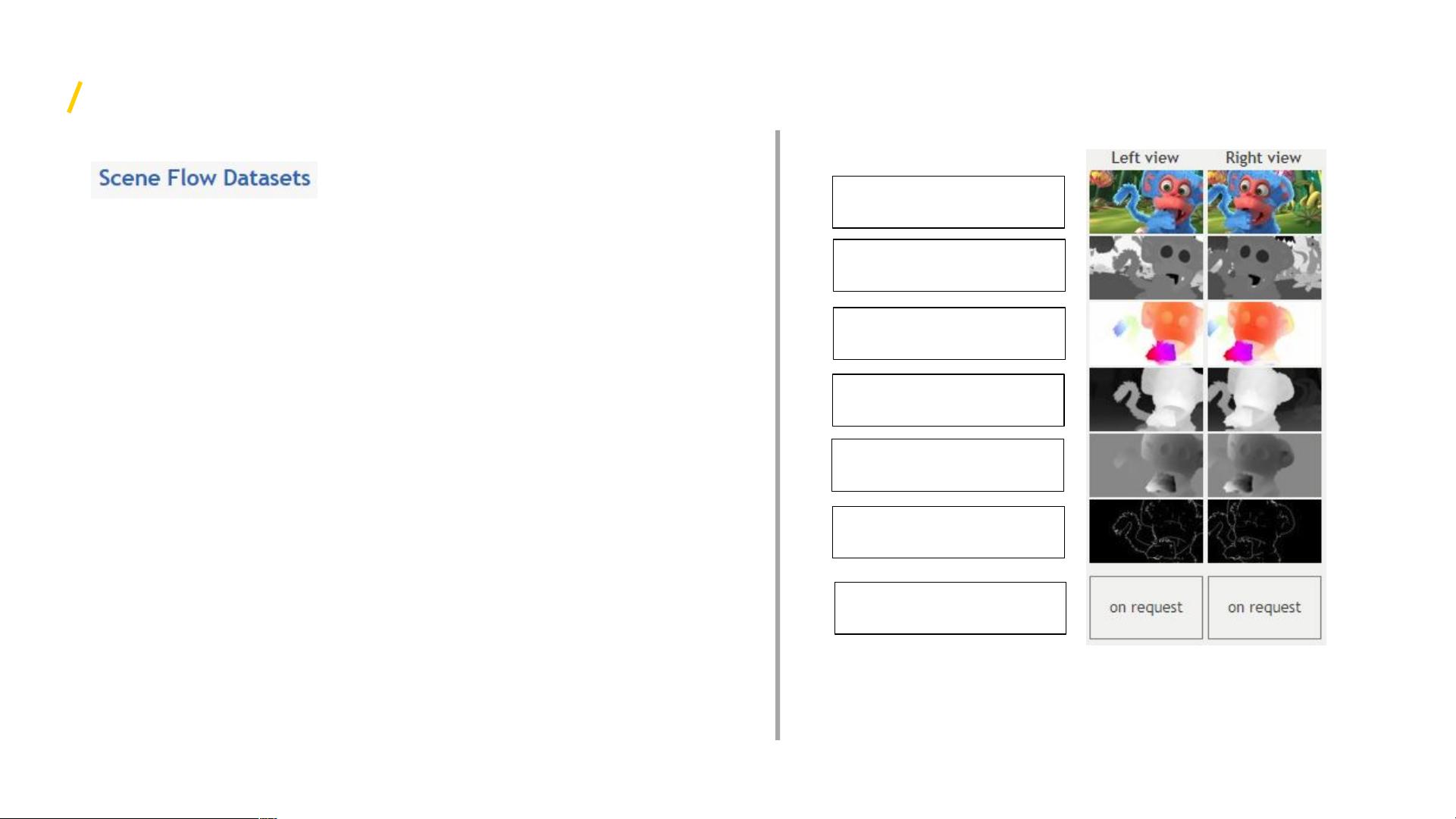

描述概述了这个PPT的核心内容,即介绍一个专为训练卷积神经网络(CNN)设计的大规模数据集,用于解决立体匹配问题,包括视差估计、光流估计和场景流估计。该数据集由德国弗莱堡大学计算机科学学院的模式识别与图像处理系开发,特别强调了三个关键渲染数据集:FlyingThings3D、Monkaa和Driving。这些数据集通过Blender等3D建模软件生成,提供了丰富的复杂运动场景,以便于网络学习和性能评估。

FlyingThings3D包含随机移动的日常物体,Monkaa则源自3D动画短片,具有非刚性关节运动和复杂的视觉效果,如皮毛。Driving数据集则使用汽车模型和真实世界元素,如3DWarehouse、路灯和树木,以增强场景的真实感。这个数据集的独特之处在于它首次支持场景流方法的训练,这是对传统深度学习在计算机视觉中的一个重要拓展。

论文中提及的三个主要网络架构:

1. DispNet:这是一个用于实时视差估计的CNN,其在 FlyingThings3D 数据集上的训练是基础,然后可以进一步微调在KITTI 2015基准上。

2. FlowNet:这是学习光流的网络,利用CNN技术实现光学流的自动估计。

3. SceneFlowNet:这个网络是首个基于CNN的场景流估计方法,它结合了光流和视差估计,通过联合训练提升性能。

网络结构部分提到使用自定义版的Caffe框架和Adam优化器,设置了特定的学习率策略(λ=1e-4),并在一定迭代次数后调整学习率。论文还展示了在FlyingThings3D上预训练的DispNet在KITTI 2015数据集上的微调效果,证明了其在实际场景中的优越性能。

总结来说,这份PPT深入探讨了如何通过大规模、高逼真的数据集和创新的CNN架构,推动了立体匹配领域的发展,尤其是在视差估计、光流估计和场景流估计方面的研究进展。这对于理解深度学习在计算机视觉中的应用及其在自动驾驶、虚拟现实等领域的潜在价值具有重要意义。

相关推荐

DearNicole

- 粉丝: 1061

最新资源

- FEUP-RCOM-Proj:实现串行端口安全文件传输与FTP自动化

- Postman最新Windows 64位版发布下载

- DB2数据库初学者常见问题解答指南

- C#实现OPC DA服务器通用库及驱动接口指南

- MSP430UIF仿真器全套技术资料详解

- winPcap编程手册及源码范例解析

- 12套精选毕业答辩PPT模板及答辩技巧

- VC++实现视图窗口鼠标捕捉的技巧

- CAS单点登录技术全面解析及实例应用指南

- 智能建站系统:自动采集发布,实现SEO优化与流量倍增

- Platzi Git/GitHub博客:深入代码管理与实践

- Windows环境下Python2.7与Scrapy1.1框架安装教程

- 实现CSS3鼠标悬停图片遮罩放大效果

- 掌握Eclipse: Jad.exe与Jadclipse_3.3.0.jar反编译插件使用指南

- 单片机与PC通过串口通信的实现方法

- 极点五笔输入法深度评测与使用指南