深度学习入门(5):循环神经网络解析

下载需积分: 47 | PDF格式 | 887KB |

更新于2024-07-17

| 73 浏览量 | 举报

"这篇文档是《零基础入门深度学习》系列的第五部分,专注于循环神经网络(RNN)的介绍,适合没有深度学习背景的程序员。文档作者旨在通过简单的语言和大量的代码示例,帮助读者理解和应用循环神经网络。"

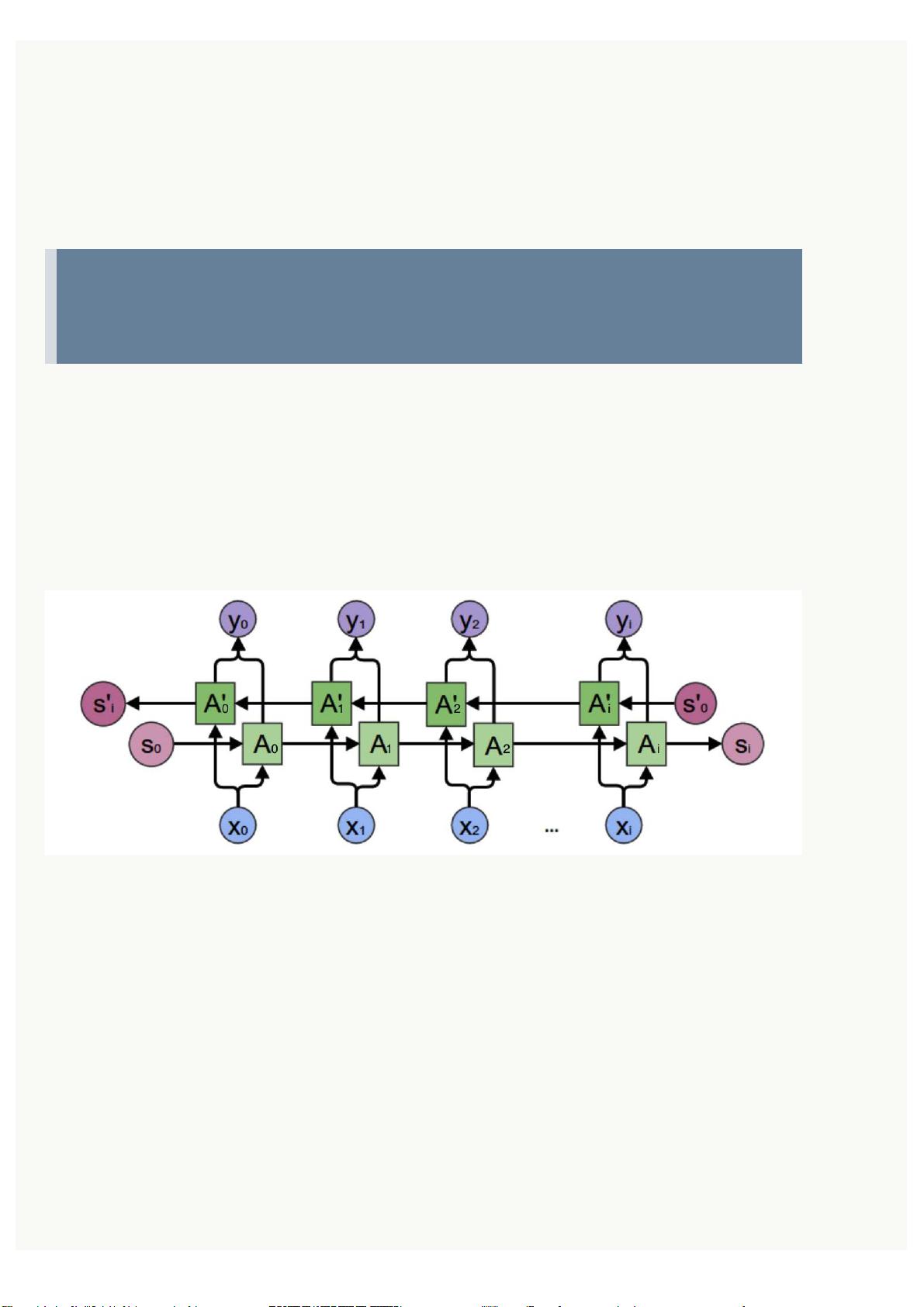

在深度学习中,循环神经网络(RNN)是一种特殊类型的神经网络,它擅长处理序列数据,因为其结构允许信息在时间步之间流动。在传统的前馈神经网络中,每个神经元只接收上一层的输入,而在RNN中,神经元不仅接收当前时间步的输入,还依赖于前一时间步的隐藏状态。这种设计使得RNN能够在处理如自然语言、音频或时间序列数据时保留历史信息,从而更好地理解和预测序列模式。

RNN的基本单元是循环层,其中包含一个称为长短期记忆(LSTM)或门控循环单元(GRU)的变体,这些设计用于解决传统RNN中的梯度消失和梯度爆炸问题。LSTM通过引入输入门、遗忘门和输出门来控制信息流,有效地解决了长期依赖问题,而GRU结合了输入门和遗忘门的概念,以更简洁的方式实现类似的功能。

在文本生成、机器翻译、语音识别、情感分析等任务中,RNN表现出色。例如,在自然语言处理中,RNN可以被用来学习单词序列的上下文依赖,以预测下一个单词。在训练过程中,RNN通过反向传播算法更新权重,这与全连接神经网络和卷积神经网络的训练方式相同。

然而,RNN的一个挑战是计算效率,因为每个时间步都需要遍历整个网络,这在处理长序列时可能变得昂贵。为了解决这个问题,有时会使用变体如双向RNN,它同时考虑前向和后向的信息流,或者使用自注意力机制的Transformer模型,这些模型可以并行处理序列的不同部分,提高计算效率。

循环神经网络是深度学习中处理序列数据的关键工具,尽管它们有一些固有的挑战,但通过不断的研究和发展,如LSTM和GRU的出现,RNN已经成为许多实际应用中的标准选择。通过深入理解RNN的工作原理,并结合实际编程实践,开发者可以更好地利用这些强大的模型解决序列数据相关的复杂问题。

相关推荐