网络爬虫与图论遍历:防止URL环路策略

需积分: 0 10 浏览量

更新于2024-08-04

收藏 242KB DOCX 举报

"4.1_爬虫搜索策略-防止环路的出现1"

网络爬虫是用于自动化地抓取互联网信息的程序,其核心原理是利用图论中的遍历算法来跟踪和下载网页。在互联网这个庞大的图结构中,每个网页被视为一个节点,而超链接则作为连接这些节点的边。当爬虫从一个网页出发,通过分析其中的超链接,它可以访问到与其相连的所有网页,以此类推,理论上可以遍历整个互联网。

在实施爬虫的过程中,防止环路的出现至关重要。环路是指在网站URL链接结构中,从一个页面可以沿着超链接回到自身或已经访问过的页面。例如,一个网页可能链接回其父页面,或者通过一系列链接最终返回起点。如果不加以处理,爬虫可能会陷入无尽的循环,导致效率低下,甚至耗尽资源。

为了规避环路,爬虫通常采用以下策略:

1. 记录已访问页面:爬虫会维护一个哈希表(HashTable)或类似的结构,存储已经访问过的URL,每当遇到新的URL,都会先检查这个表,如果已存在,则跳过,防止重复下载。

2. 使用深度优先搜索(DFS)或广度优先搜索(BFS):DFS倾向于深入探索一条路径,直到尽头再回溯,而BFS则先访问离起点近的节点,可以更有效地发现环路并及时跳出。

3. 设定访问限制:对每个网页的深度或相邻页面数量设置阈值,超过阈值则不再继续探索,避免深陷环路。

4. 使用队列或栈管理待访问URL:通过有序的数据结构,控制爬虫的遍历顺序,有助于检测和防止环路。

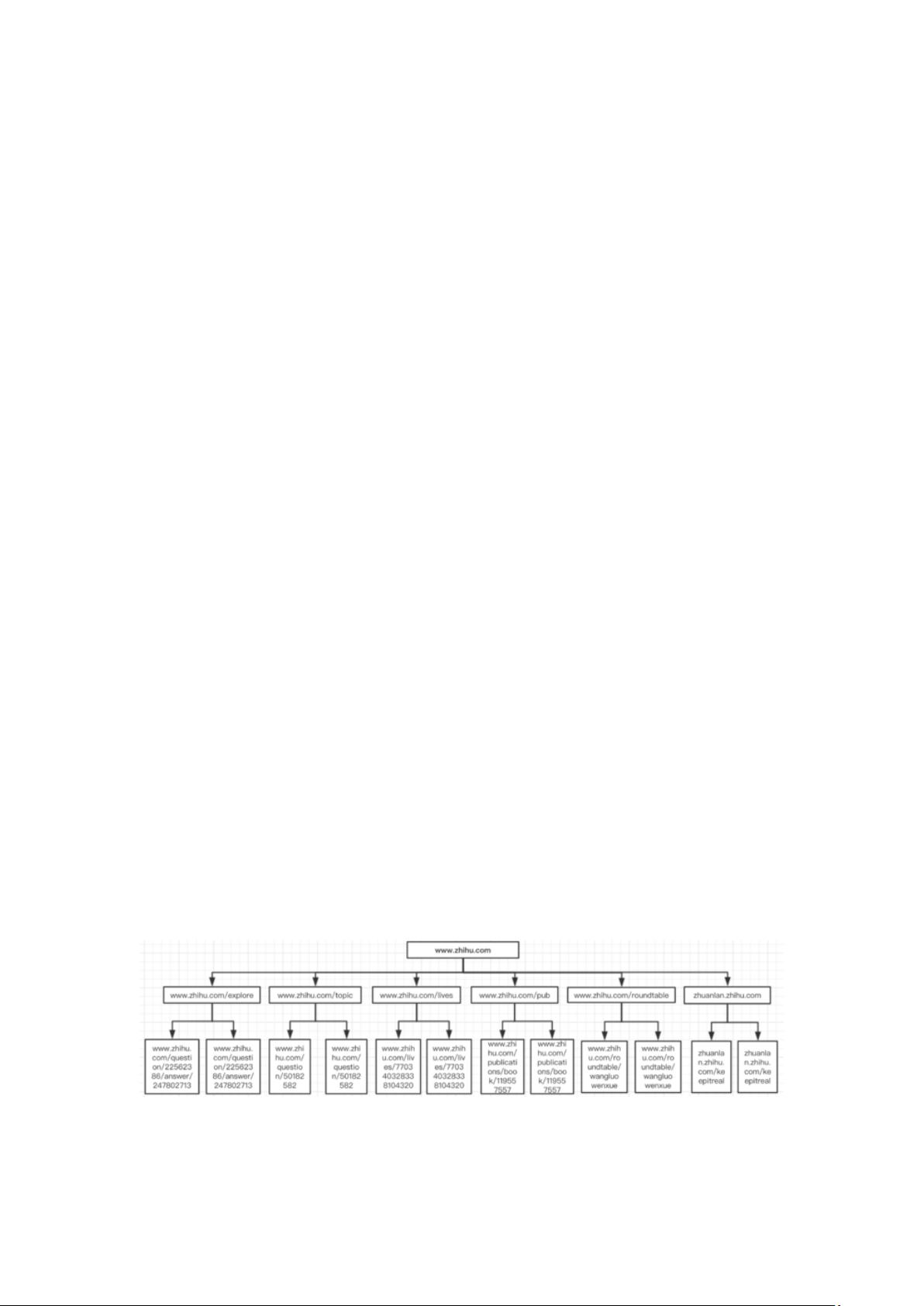

以网站的树结构为例,大多数网站的URL层次分明,如知乎的结构就包括发现、话题、Live、书店、圆桌、专栏等多个层级。这样的结构便于爬虫按照一定的逻辑进行爬取,例如从顶级分类开始,逐级深入。然而,即使在这样的结构中,也可能存在环路,比如通过内部链接从低层级页面返回到上一层或顶层页面。

对于大型的互联网公司,如Google,其网络爬虫需要处理的网页数量极为庞大,单靠少数服务器是无法完成任务的。因此,它们会建立分布式爬虫系统,由成千上万台服务器组成,通过高效的网络连接协同工作。分布式爬虫系统的设计和优化涉及负载均衡、任务调度、数据存储等多个方面,是一项极具挑战性的技术。

防止环路是网络爬虫设计的重要环节,通过有效的策略和数据结构,爬虫能够更高效、更全面地抓取互联网信息,同时避免资源的浪费。对于大规模的爬虫系统,还需要考虑分布式计算和网络架构,以应对互联网的海量数据。

2010-11-12 上传

2010-11-15 上传

2020-01-02 上传

2023-08-26 上传

2023-12-22 上传

2023-05-22 上传

2024-05-08 上传

2023-05-14 上传

2023-06-10 上传

2023-05-12 上传

SeaNico

- 粉丝: 26

- 资源: 320

最新资源

- Raspberry Pi OpenCL驱动程序安装与QEMU仿真指南

- Apache RocketMQ Go客户端:全面支持与消息处理功能

- WStage平台:无线传感器网络阶段数据交互技术

- 基于Java SpringBoot和微信小程序的ssm智能仓储系统开发

- CorrectMe项目:自动更正与建议API的开发与应用

- IdeaBiz请求处理程序JAVA:自动化API调用与令牌管理

- 墨西哥面包店研讨会:介绍关键业绩指标(KPI)与评估标准

- 2014年Android音乐播放器源码学习分享

- CleverRecyclerView扩展库:滑动效果与特性增强

- 利用Python和SURF特征识别斑点猫图像

- Wurpr开源PHP MySQL包装器:安全易用且高效

- Scratch少儿编程:Kanon妹系闹钟音效素材包

- 食品分享社交应用的开发教程与功能介绍

- Cookies by lfj.io: 浏览数据智能管理与同步工具

- 掌握SSH框架与SpringMVC Hibernate集成教程

- C语言实现FFT算法及互相关性能优化指南