人工智能实践:Tensorflow中的卷积神经网络解析

需积分: 0 8 浏览量

更新于2024-06-30

收藏 3.53MB PDF 举报

"本次讲解主要围绕人工智能实践,特别是通过Tensorflow框架进行的机器学习操作,重点介绍了全连接神经网络(FCN)和卷积神经网络(CNN)的基础知识及其在图像处理中的应用。"

在机器学习领域,尤其是深度学习中,神经网络是核心组成部分。全连接神经网络(FCN)是最基本的神经网络结构,其特点是每一层的神经元都与前一层的所有神经元相连。例如,一个简单的FCN可能包含输入层、隐藏层和输出层。在描述的例子中,如果输入层是784个像素点(对应28x28的灰度图像),第一层有128个神经元,第二层输出10个类别(如MNIST数据集的手写数字识别),那么第一层将有784*128个权重参数和128个偏置项,第二层有128*10个权重和10个偏置项,总计101770个参数。大量的参数虽然能提高模型的表达能力,但也可能导致过拟合,即模型在训练数据上表现优秀,但在未见过的数据上表现差劲。

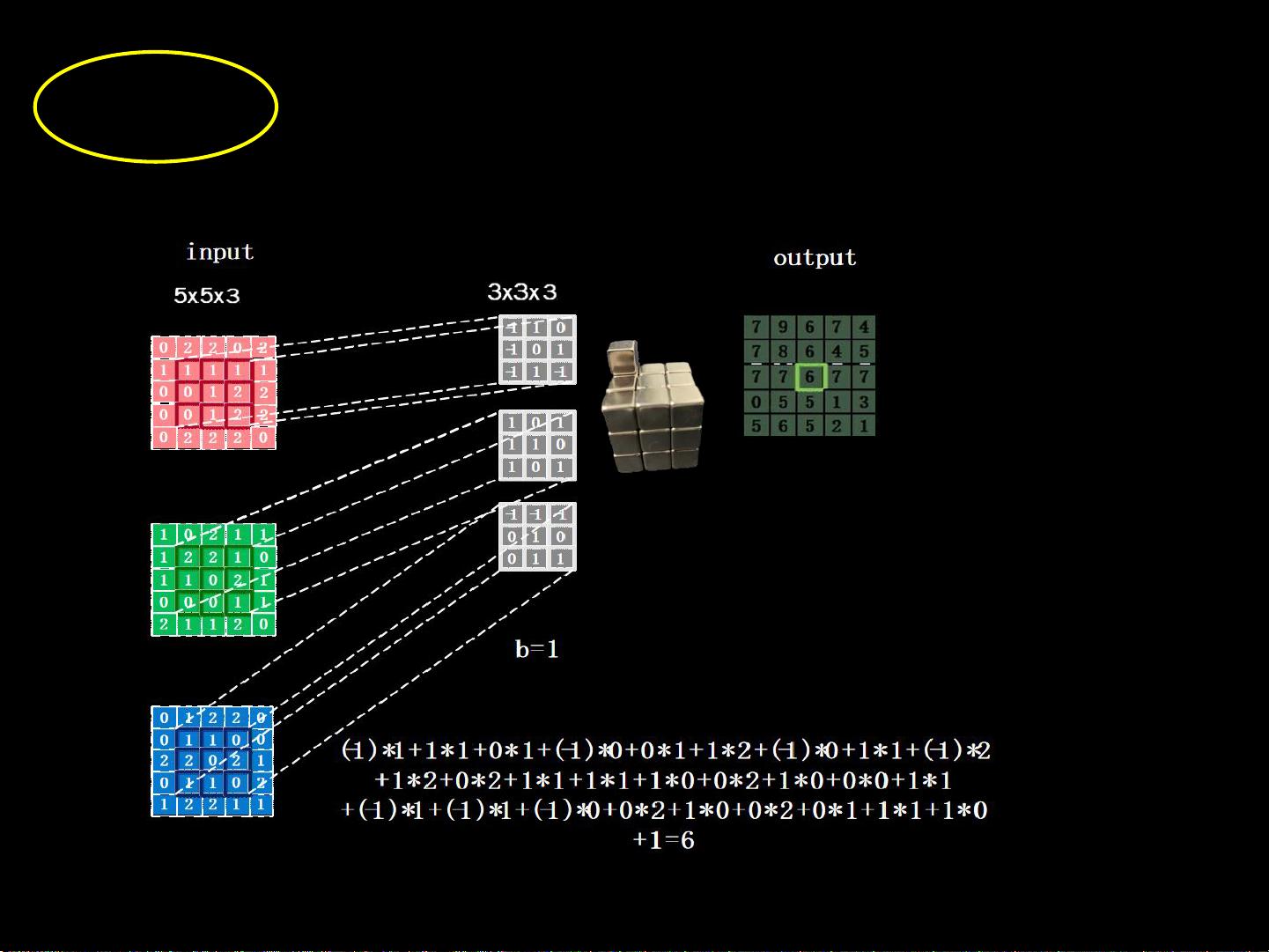

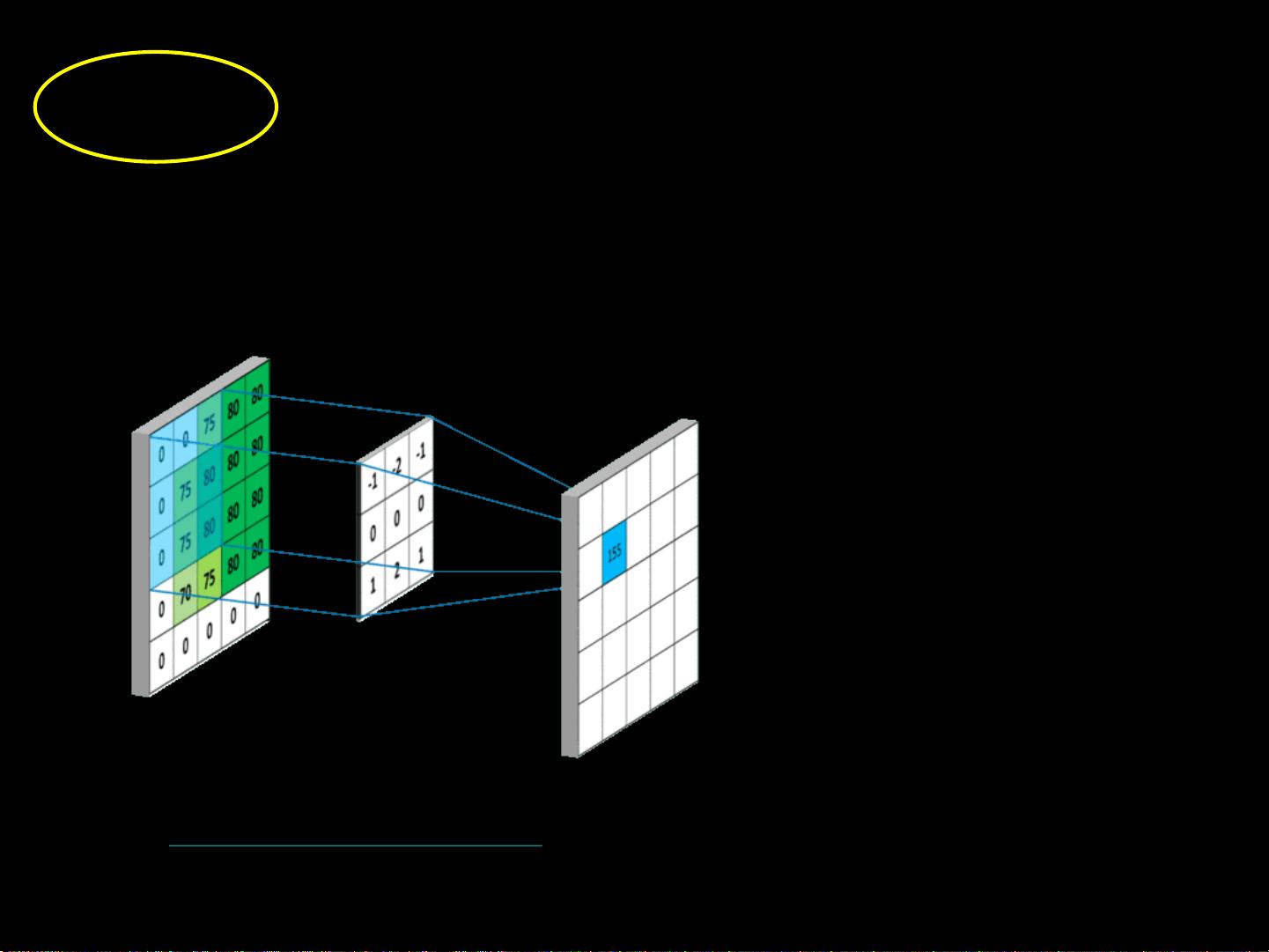

为了解决过拟合问题,并且更有效地处理高分辨率彩色图像,通常会采用卷积神经网络(CNN)。CNN的核心特征是卷积层,它能自动从图像中提取特征。对于单通道(如灰度图像)输入,卷积核是一个小正方形,通常为3x3或5x5,按特定步长在输入特征图上滑动,计算卷积。卷积核与输入特征图的重叠部分对应元素相乘、求和后加上偏置,生成输出特征图的一个像素。例如,一个3x3卷积核用于单通道输入,包含9个权重参数和1个偏置项;如果是3x3x3卷积核处理三通道(如RGB彩色图像),则有27个权重和1个偏置,总共28个参数。

CNN的另一个关键特性是深度,这表示网络中卷积层的数量。每一层的卷积核数量决定了输出特征图的深度,可以理解为提取的特征层次。更深的网络可以学习到更复杂的特征,但也会增加计算复杂度和参数数量。通过堆叠多个卷积层,可以逐步提取图像的不同层次特征,然后再通过全连接层进行分类或回归等任务。

在实际应用中,为了避免过拟合,我们通常会在原始图像输入到CNN之前进行预处理,比如特征提取。这可能包括图像缩放、归一化,甚至使用预训练的CNN模型(如VGG或ResNet)提取高层特征,这些特征具有更强的语义含义,然后将这些特征送入后续的全连接网络进行分类或其他任务。

总结来说,本讲主要涵盖了全连接神经网络的参数计算,以及卷积神经网络在图像处理中的应用,包括卷积计算原理、卷积核的参数数量以及网络深度的概念,这些都是理解和构建深度学习模型的基础。

2022-08-04 上传

2022-08-08 上传

2022-08-03 上传

2022-08-03 上传

2021-09-26 上传

2021-09-26 上传

2023-05-28 上传

艾闻

- 粉丝: 44

- 资源: 301

最新资源

- Postman安装与功能详解:适用于API测试与HTTP请求

- Dart打造简易Web服务器教程:simple-server-dart

- FFmpeg 4.4 快速搭建与环境变量配置教程

- 牛顿井在围棋中的应用:利用牛顿多项式求根技术

- SpringBoot结合MySQL实现MQTT消息持久化教程

- C语言实现水仙花数输出方法详解

- Avatar_Utils库1.0.10版本发布,Python开发者必备工具

- Python爬虫实现漫画榜单数据处理与可视化分析

- 解压缩教材程序文件的正确方法

- 快速搭建Spring Boot Web项目实战指南

- Avatar Utils 1.8.1 工具包的安装与使用指南

- GatewayWorker扩展包压缩文件的下载与使用指南

- 实现饮食目标的开源Visual Basic编码程序

- 打造个性化O'RLY动物封面生成器

- Avatar_Utils库打包文件安装与使用指南

- Python端口扫描工具的设计与实现要点解析