理解MPI:并行编程中的消息传递库而非语言

需积分: 9 163 浏览量

更新于2024-11-19

收藏 87KB DOC 举报

"并行复习笔记—MPI是一个库,而不是一门语言。许多人认为,MPI就是一种并行语言,这是不准确的。"

并行计算是计算机科学中的一个重要领域,它涉及到使用多台计算机或多个处理器同时处理任务以提高计算效率。MPI,全称Message Passing Interface,是一个广泛用于并行计算的标准库,而非编程语言。这个库提供了丰富的函数和机制,允许程序员在分布式内存环境中进行进程间通信。

1. **并行计算机**:并行计算机是由一组协同工作的计算机组成,共同解决一个计算问题。它们可以是超级计算机,工作站网络,或是具有多个处理器的工作站。

2. **并行计算需求**:并行计算主要应用于计算密集型和数据密集型问题。前者需要大量的数学运算,后者则涉及大量数据的处理和分析。

3. **并行算法特性**:并行算法的三个关键特性是并行性(算法可以被分解为独立的任务)、可扩展性(随着更多资源的加入,性能提升)和局部性(大部分计算和数据访问集中在一部分)。

4. **并行计算机分类**:MIMD(多指令流多数据流)和SIMD(单指令流多数据流)是两种基本类型的并行计算机。MIMD系统中每个处理器可以执行不同的指令,而SIMD系统所有处理器执行相同的指令但可能处理不同的数据。

5. **并行编程模型**:主要包括任务通道模型、数据并行模型和消息传递模型。MPI属于消息传递模型,其中进程通过发送和接收消息进行通信。

6. **并行计算划分**:区域划分和功能划分是常见的并行计算任务划分方式。前者按计算空间分割,后者按计算功能分配。

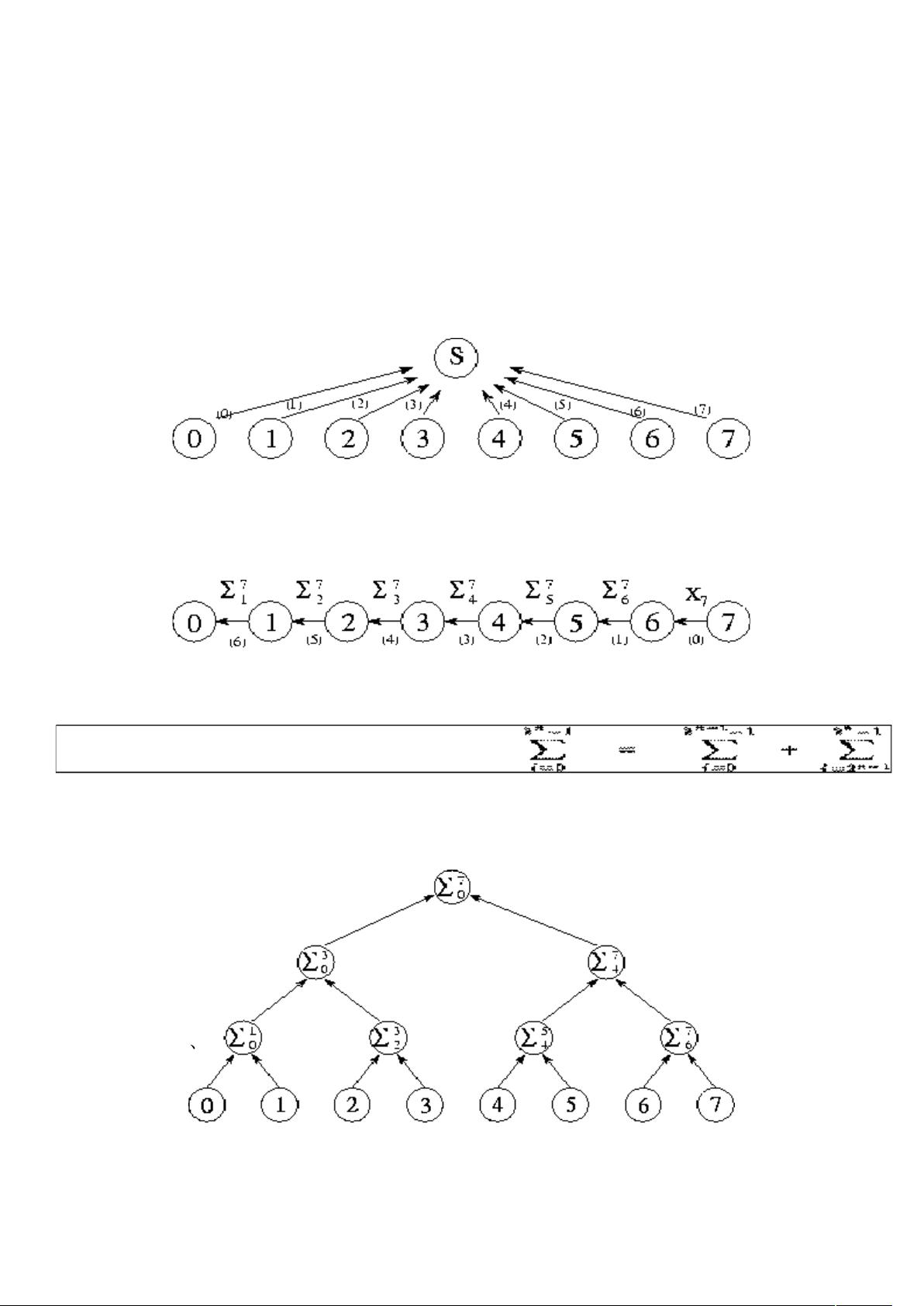

7. **全局通信**:例如,集中式求累加和操作通常涉及所有进程的全局通信,因为每个进程都需要参与计算总和。

8. **异步通信**:在共享数据结构的场景中,如读写操作,容易发生异步通信,即不同进程可能同时读写同一数据,需要同步机制来协调。

9. **MPI通信**:在MPI中,进程间的通信通过`MPI_Send`和`MPI_Recv`等函数实现,发送和接收消息是并行编程的关键。

10. **并行计算机形态**:并行计算机可以是拥有数百到数千处理器的超级计算机,也可以是工作站网络或多处理器工作站。

11. **负载均衡**:为了解决处理器负载不均的问题,使用负载均衡算法和任务调度算法来确保工作负载在各处理器间均匀分布。

12. **组合任务技术**:表面积-体积效应、重复计算和避免通信是优化并行程序性能的常用策略。表面积-体积效应指出,随着并行度增加,通信开销(表面积)相对于计算工作(体积)的比例会增加。

13. **Amdahl定律**:根据Amdahl定律,如果算法的串行部分占比为5%,那么理论上最大加速比可达20,意味着并行化可以将执行时间减少到原来的1/20。

14. **局部通信/全局通信**:局部通信仅涉及邻近任务,而全局通信需要所有任务之间的交互。

15. **同步通信/异步通信**:同步通信需要发送和接收方协同,而异步通信中接收方可以在任何时候接收数据,无需发送方的配合。

16. **Multicomputer模型**:这种模型中,多台独立的Von Neumann计算机通过网络连接,各自运行程序并能通过消息传递进行通信和数据交换。

17. **PCAM设计过程**:PCAM(并行计算抽象和映射)方法将并行程序设计分为划分、通信、组合和映射四个阶段,旨在优化并行性、可扩展性和性能。

18. **加速比**:加速比衡量并行系统相对于单处理器系统的性能提升,它是串行执行时间与并行执行时间的比率。

理解这些概念是掌握并行计算和使用MPI进行有效编程的基础。正确地利用并行计算和MPI可以显著提高大规模计算任务的效率。

2021-02-18 上传

161 浏览量

102 浏览量

125 浏览量

2022-03-23 上传

2022-09-24 上传

201 浏览量

BePatientDemos

- 粉丝: 1

最新资源

- 掌握PerfView:高效配置.NET程序性能数据

- SQL2000与Delphi结合的超市管理系统设计

- 冲压模具设计的高效拉伸计算器软件介绍

- jQuery文字图片滚动插件:单行多行及按钮控制

- 最新C++参考手册:包含C++11标准新增内容

- 实现Android嵌套倒计时及活动启动教程

- TMS320F2837xD DSP技术手册详解

- 嵌入式系统实验入门:掌握VxWorks及通信程序设计

- Magento支付宝接口使用教程

- GOIT MARKUP HW-06 项目文件综述

- 全面掌握JBossESB组件与配置教程

- 古风水墨风艾灸养生响应式网站模板

- 讯飞SDK中的音频增益调整方法与实践

- 银联加密解密工具集 - Des算法与Bitmap查看器

- 全面解读OA系统源码中的权限管理与人员管理技术

- PHP HTTP扩展1.7.0版本发布,支持PHP5.3环境