吴恩达机器学习课程:多元线性回归与梯度下降法详解

需积分: 10 196 浏览量

更新于2024-07-17

收藏 1.7MB PDF 举报

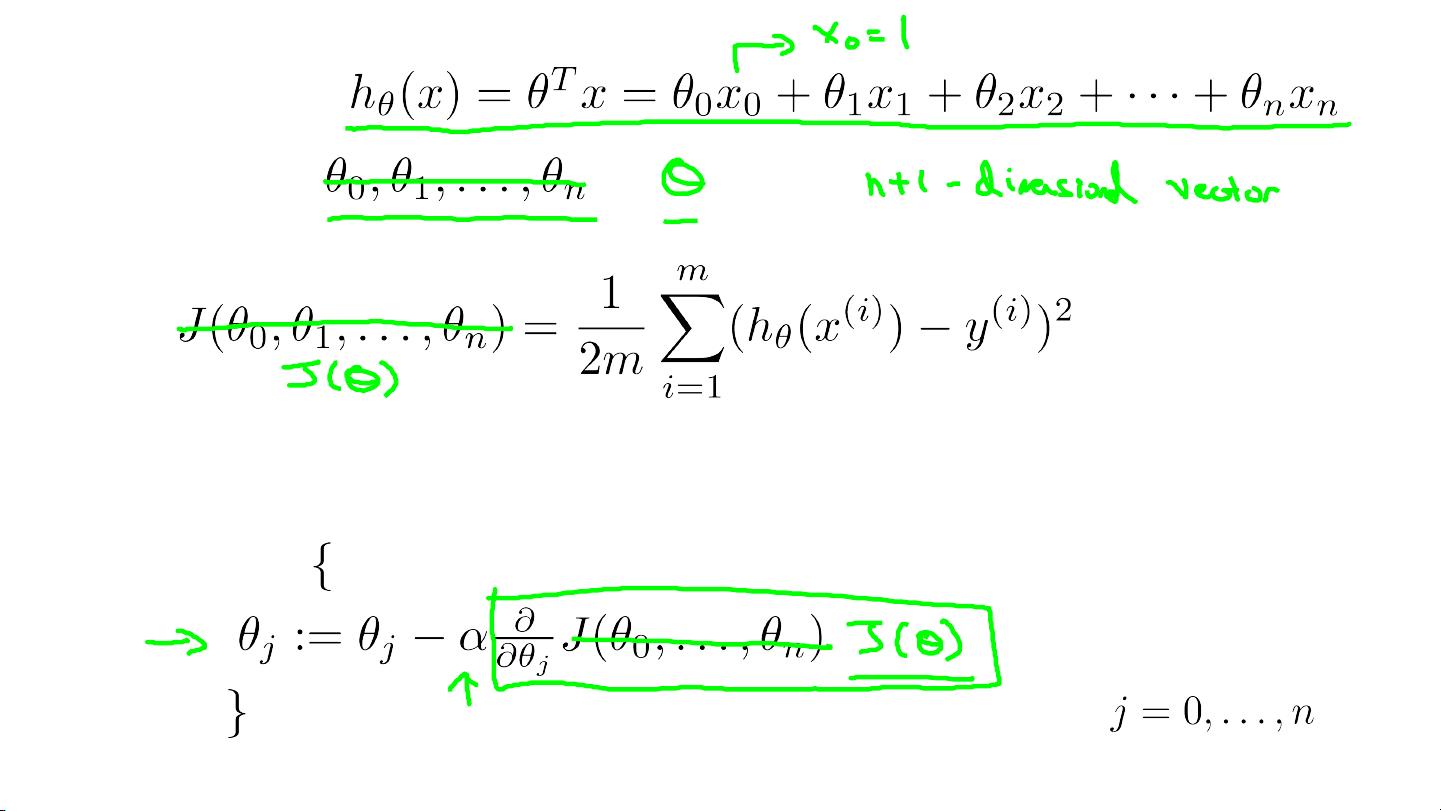

在" Lecture4.pdf"这门机器学习课程中,吴恩达教授讲解了多元线性回归的概念,特别是当涉及到多个特征(variables)时的应用。这部分内容主要集中在如何处理具有多个输入变量(features)的数据集,如房屋尺寸(feet2)、卧室数量、楼层数和年龄(years),预测房价($1000)。学习的目标是建立一个线性模型来预测因变量的价格,即通过找到一组合适的参数来拟合数据。

在讲解过程中,吴恩达教授引入了多元线性回归(Multivariate Linear Regression)的概念,这是一种统计方法,用于分析一个或多个自变量与一个响应变量之间的关系。在这个场景下,自变量是房屋的各种特征,而响应变量是价格。目标是找到一个函数形式,如 \( h_\theta(x) = \theta_0 + \theta_1 \cdot \text{Size} + \theta_2 \cdot \text{Number of bedrooms} + \theta_3 \cdot \text{Number of floors} + \theta_4 \cdot \text{Age of home} \),其中 \(\theta\) 是模型参数,\(x\) 是特征向量。

吴教授进一步介绍了梯度下降法(Gradient Descent)在处理多元线性回归中的应用。梯度下降是一种优化算法,它通过迭代更新参数 \(\theta\) 的值,使得成本函数(Cost Function)达到最小化。在这个场景中,成本函数可能表示为均方误差或平均绝对误差的形式,用来衡量模型预测值与真实值之间的差距。每一步,算法会计算梯度(gradient),即成本函数对每个参数的偏导数,然后沿着梯度的反方向调整参数,直到找到局部最优解。

在教学中,吴恩达强调了训练数据集中的每一个例子(training example)都由输入特征(input features)组成,每个特征的值对应于特定的特征变量。同时,他也提到为便于记笔记,定义了一些符号,如\(m\) 表示训练样本的数量,\(n\) 表示特征数量,\(x^{(i)}\) 和 \(y^{(i)}\) 分别代表第 \(i\) 个训练样例的特征向量和响应值。

"Lecture4.pdf"的内容涵盖了多元线性回归的基本概念、模型构建以及优化算法的实施,特别是如何通过梯度下降在有多个特征的情况下求解线性回归问题,这对于理解和应用机器学习算法进行数据分析具有重要意义。

2023-02-05 上传

2018-01-20 上传

2021-04-04 上传

2021-08-16 上传

三省少年

- 粉丝: 506

- 资源: 9

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程