台湾大学机器学习技法:寻找最优分类超平面

需积分: 9 50 浏览量

更新于2024-07-17

1

收藏 19.16MB PDF 举报

"这篇笔记来自台湾大学的机器学习课程,主要讨论了线性分类和大间隔超平面的概念,以及在面对多个可行的分类边界时如何选择最优的分类器。笔记中提到了Pocket算法用于线性可分情况下的分类,并探讨了分类边界的稳健性和对噪声的容忍度,强调了最大化间隔的重要性。"

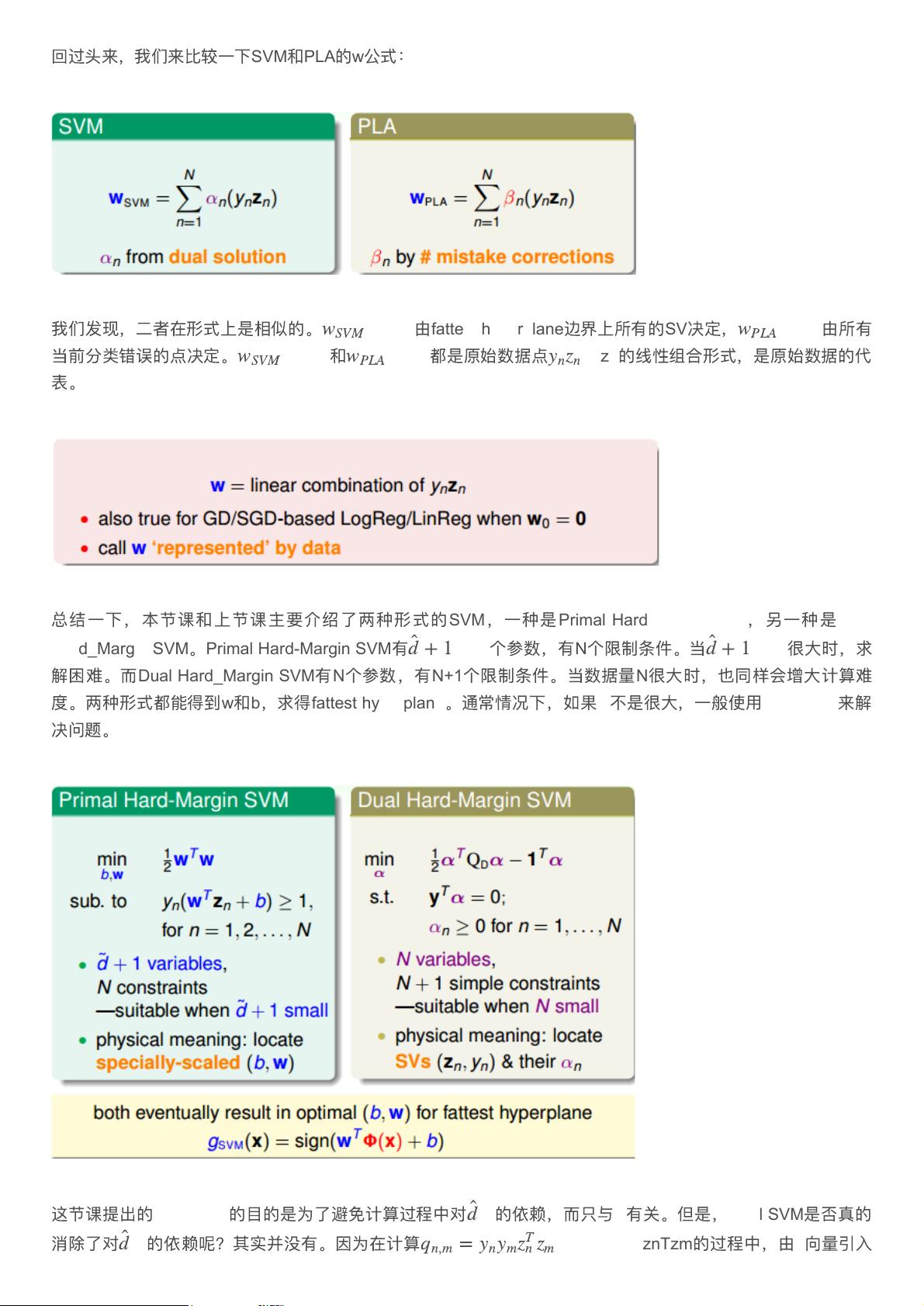

在机器学习领域,线性分类是一种基础且实用的技术,特别是在处理二维或高维数据时。台湾大学的机器学习技法笔记中提到的"Linear Classification",即线性分类,是指通过构建一个超平面(在二维空间中是一条直线,在更高维度中是超平面)来分割数据,将正类和负类分开。在这种情况下,Perceptron Learning Algorithm (PLA) 和 Pocket Algorithm 是常用的优化策略,它们能够迭代地更新超平面以减少错误分类。

"Large-Margin Separating Hyperplane"(大间隔超平面)是线性分类中的一个重要概念。它不只是寻找能够将数据集正确分开的超平面,而是寻找一个具有最大边距(margin)的超平面。边距是指从最近的正例点到超平面的距离,同时也指从最近的负例点到超平面的距离。当数据线性可分时,可能存在多个能够正确分类数据的超平面,但大间隔超平面更受青睐,因为它具有更好的泛化能力。

笔记中通过直观的示例解释了为何选择大间隔超平面。当样本点距离分类线越远,分类器对噪声或测量误差的容忍度越高,这意味着分类器更稳健,不容易因为数据的小偏差而误分类。这种对噪声的容忍度可以理解为每个样本点周围的“安全区域”,也就是样本点在保持正确分类的情况下可以允许的误差范围。大间隔的超平面使得这个“安全区域”更大,从而提高模型的鲁棒性,减少了过拟合的风险。

在实际应用中,寻找最大间隔的超平面通常可以通过支持向量机(SVM)实现,这是一种优化方法,它寻找能够最大化类别间隔的支持向量(离超平面最近的点)。SVM通过构建软间隔(允许一定程度的误分类)来处理非线性可分情况,进一步增强了模型的泛化能力。

机器学习中的大间隔思想是优化分类器性能的关键,它有助于在训练数据有限且存在噪声的情况下,构建出具有良好泛化性能的模型。台湾大学的这份笔记深入浅出地解释了这一核心概念,对于理解和应用线性分类技术是非常有价值的。

2023-07-05 上传

2023-08-01 上传

2023-05-03 上传

2023-11-04 上传

2024-01-08 上传

2023-10-13 上传

2023-09-18 上传

__盛夏光年__

- 粉丝: 482

- 资源: 9

最新资源

- zlib-1.2.12压缩包解析与技术要点

- 微信小程序滑动选项卡源码模版发布

- Unity虚拟人物唇同步插件Oculus Lipsync介绍

- Nginx 1.18.0版本WinSW自动安装与管理指南

- Java Swing和JDBC实现的ATM系统源码解析

- 掌握Spark Streaming与Maven集成的分布式大数据处理

- 深入学习推荐系统:教程、案例与项目实践

- Web开发者必备的取色工具软件介绍

- C语言实现李春葆数据结构实验程序

- 超市管理系统开发:asp+SQL Server 2005实战

- Redis伪集群搭建教程与实践

- 掌握网络活动细节:Wireshark v3.6.3网络嗅探工具详解

- 全面掌握美赛:建模、分析与编程实现教程

- Java图书馆系统完整项目源码及SQL文件解析

- PCtoLCD2002软件:高效图片和字符取模转换

- Java开发的体育赛事在线购票系统源码分析