Kettle ETL工具入门:简介、安装与基础使用

需积分: 40 166 浏览量

更新于2024-07-16

收藏 2.39MB PDF 举报

"这篇文档详细介绍了ETL工具Kettle,包括其简介、安装配置以及基本使用方法。Kettle是一款开源的Java编写的ETL工具,可在多种操作系统上运行,适用于数据抽取、转换和加载任务。它以图形化界面提供用户友好的操作体验,简化了数据处理流程的定义。在Kettle中,transformation用于执行具体的数据转换,而job则负责工作流的管理和调度。随着Pentaho套件的广泛应用,Kettle在国内外的项目中也越来越常见。"

在深入讨论Kettle之前,我们首先需要理解ETL(Extract, Transform, Load)的概念。ETL是数据仓库和大数据处理中的关键步骤,它从不同的源系统抽取数据,进行清洗、转换,并加载到目标系统,如数据仓库或大数据平台。Kettle作为ETL工具,以其灵活性、高性能和易用性而受到青睐。

Kettle的核心组件包括两个主要部分:

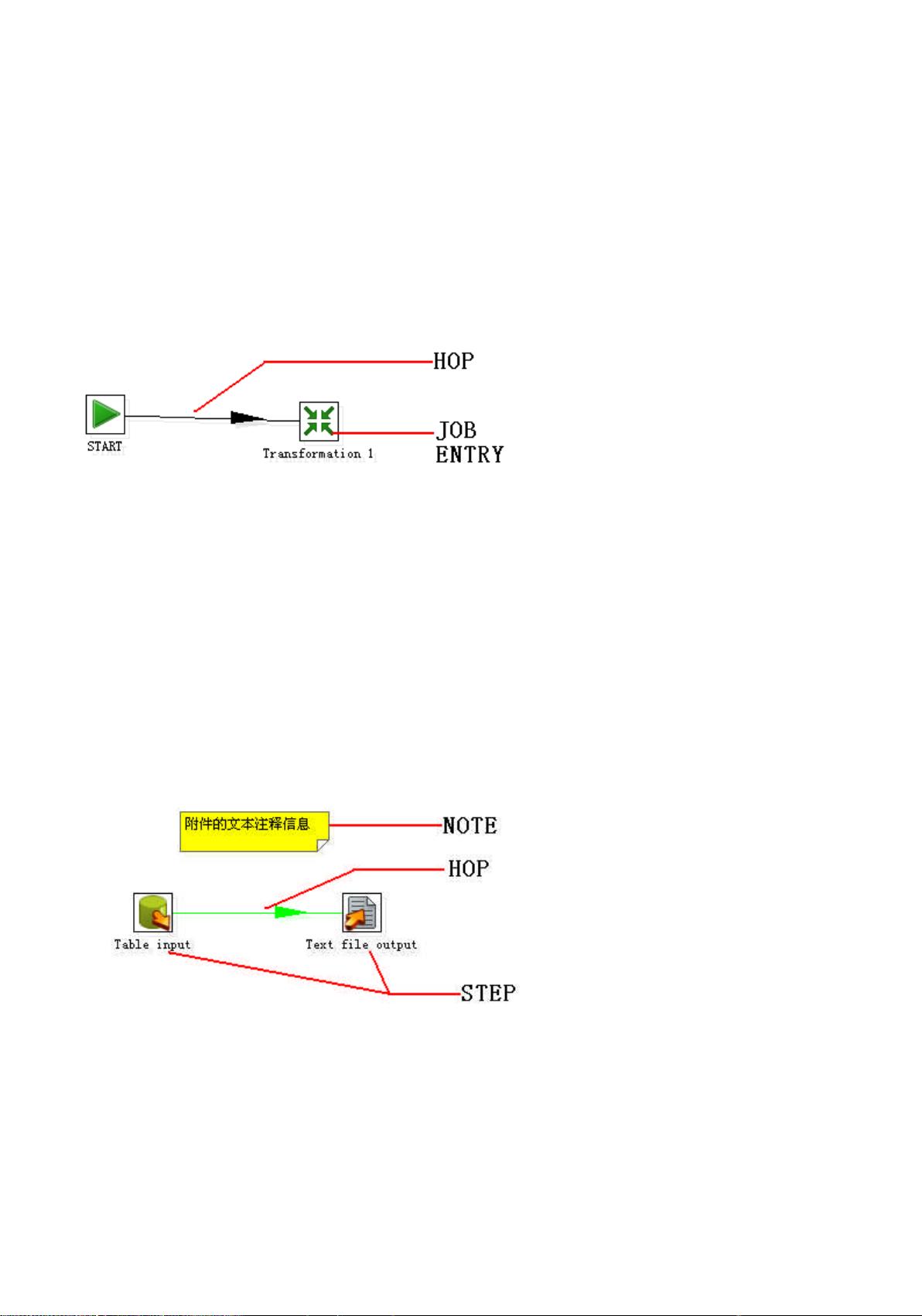

1. **Transformation(转换)**:这是Kettle的基本工作单元,用于处理和转换数据。在转换中,你可以定义一系列步骤(Steps),每个步骤负责特定的数据处理任务,如读取数据、过滤、清洗、聚合等。步骤之间通过连接(Connections)传递数据,形成数据流。转换可以是独立运行的,也可以在Job中作为一部分。

2. **Job(作业)**:作业是Kettle中的流程控制工具,用于组织和协调多个转换和/或其他作业的执行顺序。作业可以包含条件判断、循环、错误处理等控制结构,确保整个数据处理过程的完整性和正确性。

安装配置Kettle通常涉及以下步骤:

1. **下载Kettle的社区版本Pentaho Data Integration(PDI)**:从Pentaho官方网站或GitHub获取最新版本的Kettle软件包。

2. **解压并配置环境**:Kettle是绿色软件,解压缩后即可使用,无需安装。配置环境变量指向Kettle的安装目录,便于命令行操作。

3. **启动 Spoon**:Spoon是Kettle的图形化开发工具,用于设计和测试转换和作业。启动Spoon,你可以开始创建和编辑数据处理流程。

4. **连接数据源**:在Spoon中,配置连接到你需要抽取数据的数据库或其他数据源,如文件系统、API等。

5. **设计和测试转换和作业**:使用Spoon提供的拖放界面,构建你的转换和作业,进行预览和调试,确保它们按预期工作。

6. **运行和调度**:完成设计后,可以以批处理模式运行转换,或者使用Kettle的Job Control Server(Kitchen或Pan命令行工具)进行调度和自动化。

Kettle的强大之处在于其丰富的数据处理步骤库,覆盖了从数据源连接、数据转换到数据加载的广泛需求。此外,Kettle支持插件扩展,使得功能可以进一步增强。由于其开源特性,Kettle拥有活跃的社区支持,不断更新和完善。

在实际应用中,Kettle常用于数据整合、数据迁移、数据清洗等场景。例如,从多个数据库中提取数据,统一格式后加载到数据仓库;或者从CSV文件中抽取数据,经过清洗、转换,然后导入到Hadoop HDFS或NoSQL数据库。Kettle的可定制性和灵活性使其成为企业级数据处理解决方案的理想选择。

902 浏览量

436 浏览量

656 浏览量

2021-11-18 上传

169 浏览量

568 浏览量

qq_20534863

- 粉丝: 0

最新资源

- C++编程语言第三版权威指南

- ExtJS基础教程:快速入门和开发指南

- 华为Java面试深度解析

- IBM AIX系统:关键命令探秘硬件架构与资源管理

- AIX系统维护全方位指南:日常管理到高级技巧

- Trac软件项目管理平台使用手册

- MAX3471:低功耗锂电驱动器,确保远程读数与安全通信

- ASP技术驱动的留言板系统设计与实现

- XMLHttpRequest使用教程与示例

- Windows系统文件详解:关键实用工具与驱动

- Div+CSS布局全攻略:从入门到高级实战

- BIOS设置中英文对照全解

- Java初学者必备:Sun公司CoreJava经典源代码示例

- DOS批处理基础教程:简单易懂的命令行操作指南

- Linux服务器技术与配置实战

- 机电系统智能控制:神经网络与模糊控制期末试题解析