Python爬虫实战:抓取糗事百科段子

需积分: 5 12 浏览量

更新于2024-07-09

收藏 7.95MB DOCX 举报

"Python爬虫实战"

在Python爬虫实战中,我们将通过实例学习如何抓取糗事百科上的热门段子。这个实战项目旨在帮助我们掌握网络数据抓取的基本技巧,包括确定URL、处理HTTP请求、解析HTML代码以及利用正则表达式提取所需信息。

首先,我们需要明确目标:抓取糗事百科的热门段子,过滤掉含有图片的条目,并在每次按下回车键时显示段子的发布时间、发布人、内容和点赞数。由于糗事百科无需登录,因此不需要处理Cookie。

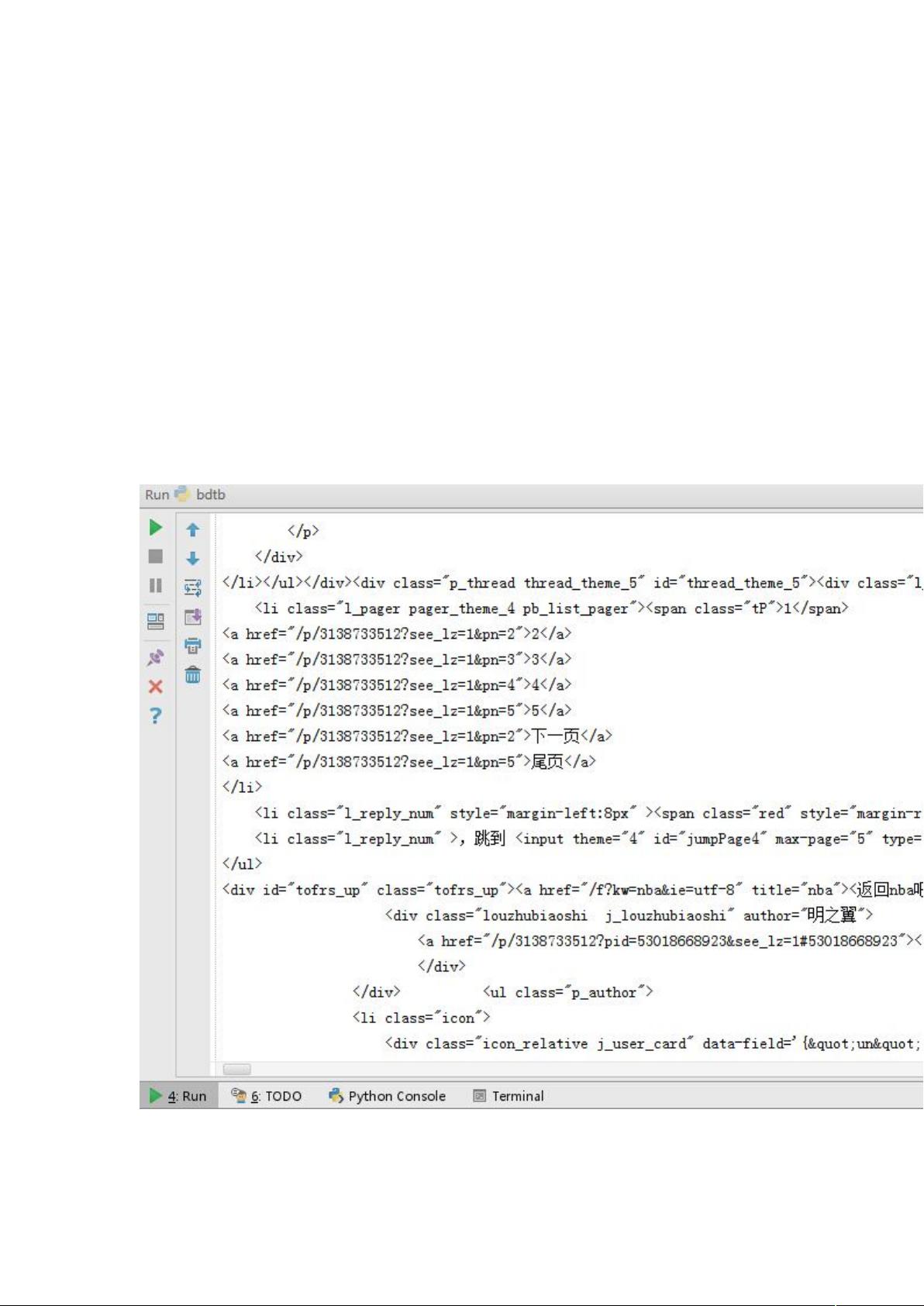

1. 确定URL并抓取页面代码

页面URL为`http://www.qiushibaike.com/hot/page/1`,这里的`1`代表页码,可以通过改变这个数字来抓取不同页面的段子。初版代码可能因为缺少必要的headers参数导致请求失败,我们需要添加合适的headers以模拟浏览器访问,例如设置`User-Agent`。

2. 提取某一页的所有段子

获取HTML页面后,我们需要解析出每个段子的信息。在HTML中,每个段子被`<div class="articleblock untagged mb15" id="...">...</div>`标签包围。为了提取这些信息,我们需要使用正则表达式或者HTML解析库,例如BeautifulSoup。

正则表达式在这里起到关键作用,用于筛选出不含图片的段子。一个基本的正则匹配模式可能如下:

```python

re.findall('<div class="articleblock untagged mb15" id="...">(.*?)</div>', html_content)

```

这里`.+?`是非贪婪匹配,会尽可能少地匹配字符,直到遇到下一个闭合标签。这样,我们就能获取到段子内容,而不会包含图片或其他非段子文本。

接下来,我们需要在每个匹配的段子内容中进一步提取发布日期、发布人和点赞数。这通常涉及查找特定的HTML标签,例如`<time>`标签用于时间,`<a>`标签用于用户名,以及查找点赞数的文本节点。可以使用正则表达式或BeautifulSoup的函数进行定位和提取。

在实际操作中,我们可能还需要处理分页问题,如果需要抓取多页的段子,我们需要循环改变URL中的页码并重复上述步骤。同时,为了防止频繁请求引起反爬机制,可以设置适当的延时。

通过这个实战项目,我们可以锻炼对Python爬虫的综合运用能力,包括requests库用于发送HTTP请求,正则表达式处理HTML文本,以及异常处理等技巧。这将有助于我们更好地理解和应用网络数据抓取技术,为后续的爬虫项目打下坚实基础。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-09-30 上传

2024-02-03 上传

2019-06-27 上传

2024-04-09 上传

2024-05-07 上传

2023-07-30 上传

chen965698098

- 粉丝: 1

- 资源: 321

最新资源

- WordPress作为新闻管理面板的实现指南

- NPC_Generator:使用Ruby打造的游戏角色生成器

- MATLAB实现变邻域搜索算法源码解析

- 探索C++并行编程:使用INTEL TBB的项目实践

- 玫枫跟打器:网页版五笔打字工具,提升macOS打字效率

- 萨尔塔·阿萨尔·希塔斯:SATINDER项目解析

- 掌握变邻域搜索算法:MATLAB代码实践

- saaraansh: 简化法律文档,打破语言障碍的智能应用

- 探索牛角交友盲盒系统:PHP开源交友平台的新选择

- 探索Nullfactory-SSRSExtensions: 强化SQL Server报告服务

- Lotide:一套JavaScript实用工具库的深度解析

- 利用Aurelia 2脚手架搭建新项目的快速指南

- 变邻域搜索算法Matlab实现教程

- 实战指南:构建高效ES+Redis+MySQL架构解决方案

- GitHub Pages入门模板快速启动指南

- NeonClock遗产版:包名更迭与应用更新