预训练模型揭示语言隐喻:跨数据集与语言的编码洞察

133 浏览量

更新于2024-06-19

收藏 879KB PDF 举报

预训练语言模型(PLMs)作为当今自然语言处理(NLP)领域的基石,已经在众多应用中展现出强大的表现,包括机器翻译、问答系统、对话管理和情感分析。然而,尽管它们在处理大量文本数据中展现出惊人的能力,但关于它们是否以及如何编码和处理隐喻这一关键的人类思维特征,仍存在研究空白。

隐喻是语言中的核心元素,通过概念隐喻理论(CMT),隐喻被视为认知过程,它在不同概念间建立了非字面的关联。这种关联对于人类理解和创新至关重要,因此在构建能够模仿人类思考的计算系统时,捕捉隐喻至关重要。然而,现有的PLMs是否能有效地捕捉并编码这些隐喻信息,尚未得到充分探究。

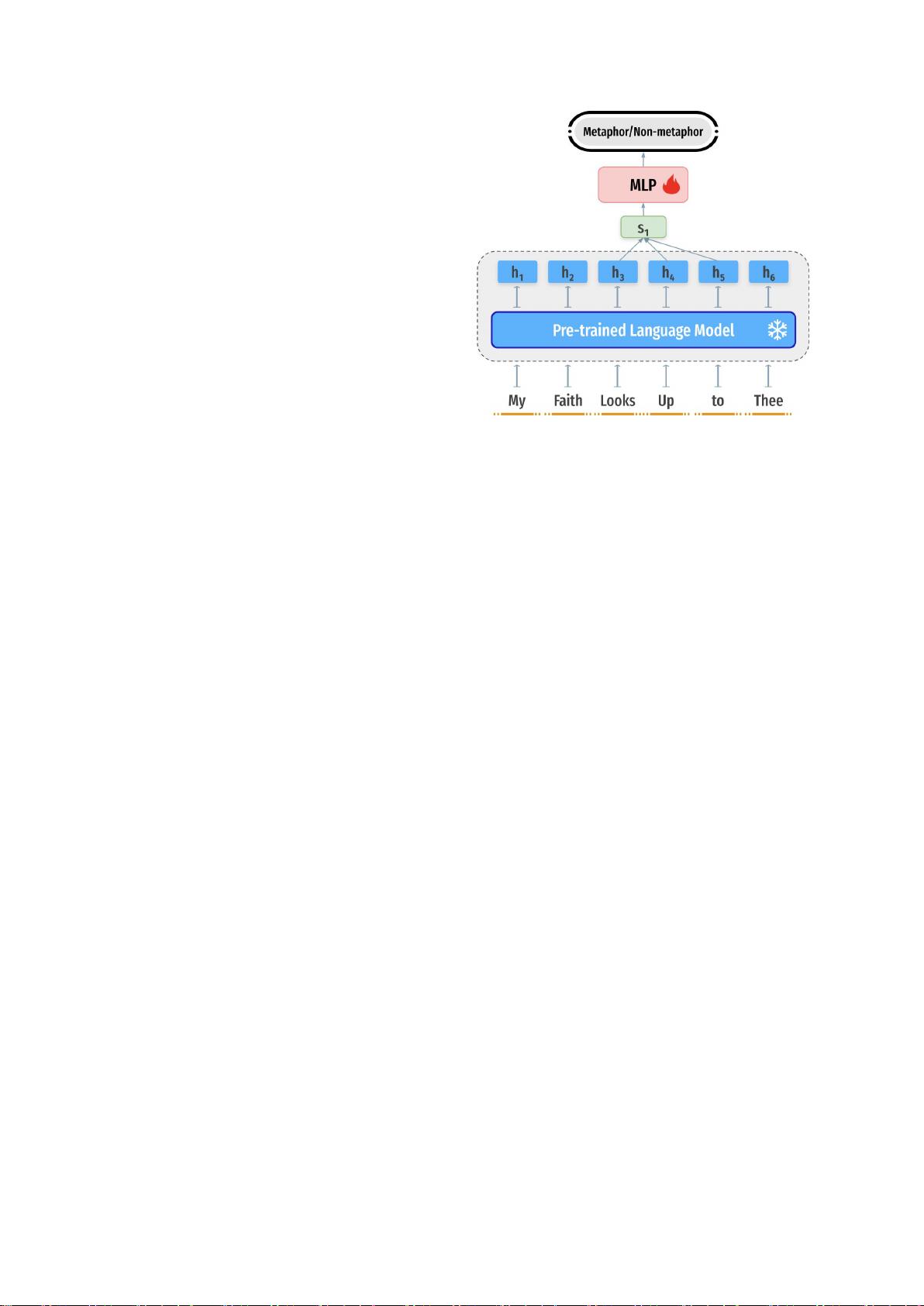

本文的主要目标是探索预训练语言模型中隐喻的编码情况,特别是在跨语言和跨文化背景下。研究者选择了英语、西班牙语、俄语和波斯语这四种语言的数据集,通过设计实验来测量PLMs在处理隐喻时的表征能力。实验结果显示,PLMs确实包含了隐喻性知识,尤其是在它们的中间层中,这暗示了模型可能在学习过程中捕捉到了抽象的语义关联。

研究发现,隐喻知识在不同语言和数据集之间具有一定的迁移性,尤其是当训练和测试数据集的注释保持一致时,这种迁移更为显著。这一发现对于认知科学和NLP社区来说,意味着PLMs可能在某种程度上捕捉到了人类认知的共通性,有助于开发更加智能和灵活的NLP系统。

然而,这项工作的局限性在于,它并未深入剖析模型内部的具体机制,也没有提供如何优化模型以更好地捕捉隐喻的指导。未来的研究可能会进一步探讨模型如何处理复杂的隐喻结构,以及如何结合人类语言学理论来改进模型的隐喻理解和生成能力。

总结来说,预训练语言模型中的隐喻探测与概括研究为我们揭示了模型在处理隐喻方面的潜在能力,为理解模型的内部工作原理和提升NLP系统的隐喻理解水平提供了有价值的方向。

2022-03-18 上传

2022-07-22 上传

2021-07-15 上传

2024-10-31 上传

2023-02-06 上传

2023-05-05 上传

2023-05-05 上传

2023-04-07 上传

2023-08-27 上传

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- SSM Java项目:StudentInfo 数据管理与可视化分析

- pyedgar:Python库简化EDGAR数据交互与文档下载

- Node.js环境下wfdb文件解码与实时数据处理

- phpcms v2.2企业级网站管理系统发布

- 美团饿了么优惠券推广工具-uniapp源码

- 基于红外传感器的会议室实时占用率测量系统

- DenseNet-201预训练模型:图像分类的深度学习工具箱

- Java实现和弦移调工具:Transposer-java

- phpMyFAQ 2.5.1 Beta多国语言版:技术项目源码共享平台

- Python自动化源码实现便捷自动下单功能

- Android天气预报应用:查看多城市详细天气信息

- PHPTML类:简化HTML页面创建的PHP开源工具

- Biovec在蛋白质分析中的应用:预测、结构和可视化

- EfficientNet-b0深度学习工具箱模型在MATLAB中的应用

- 2024年河北省技能大赛数字化设计开发样题解析

- 笔记本USB加湿器:便携式设计解决方案