无模型强化学习中的蒙特卡洛算法与策略评估

需积分: 10 156 浏览量

更新于2024-09-05

收藏 625KB DOCX 举报

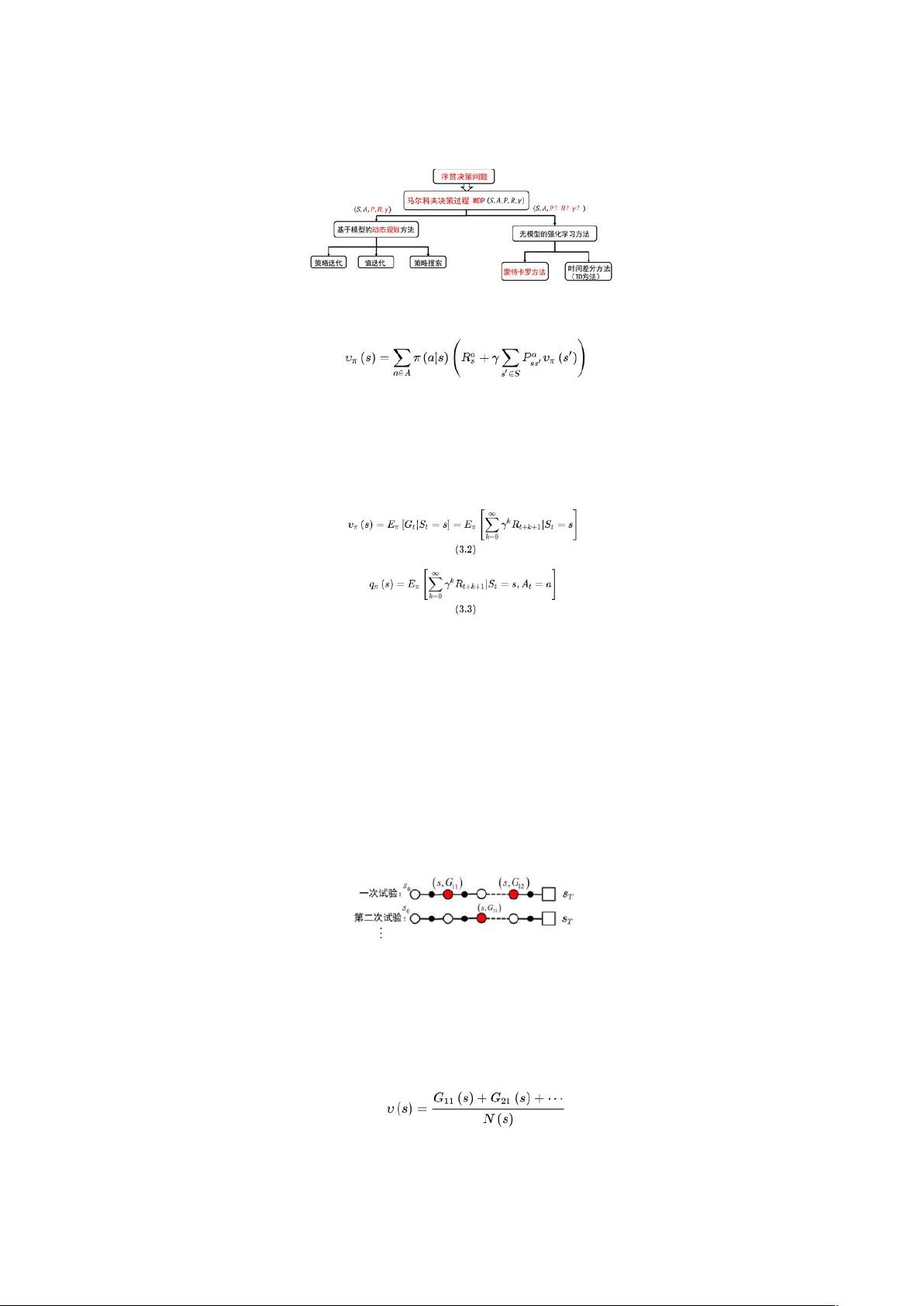

蒙特卡洛算法是一种无模型强化学习的重要方法,尤其在动态规划的值函数计算中,当模型不可知时,它提供了一种通过随机采样来估计期望值的方式。在传统的动态规划中,值函数(如状态值函数V(s)和行为值函数Q(s, a))是基于已知环境模型来计算的,即通过模拟未来的状态转移来求得返回值的期望。然而,在无模型强化学习中,这些模型是未知的,因此无法直接使用这种方法。

蒙特卡洛方法的核心思想是通过多次从任意状态开始执行策略,直到达到终止状态,然后根据实际路径上的回报来估算状态的价值。有两种主要的蒙特卡洛算法实现方式:

1. Firstvisit蒙特卡洛:只考虑状态S第一次出现时的回报,将其作为该状态的值。

2. Everyvisit蒙特卡洛:所有S的出现都会被纳入考虑,并在计算平均时除以其总出现次数,确保更全面地估计状态值。

这两种方法都是为了克服模型不确定性,通过对实际经验的累积,不断更新和优化策略。其中,贪婪策略偏向于选择立即带来最大价值的动作,而软策略则允许有一定的随机性,即使执行其他动作的概率较低,也有助于状态空间的充分探索。

在无模型强化学习中,获取足够的经验至关重要。确保所有状态至少有一次被访问到是评估策略价值函数的基础。这可以通过探索性初始化来实现,即随机选择初始状态,尽管这可能导致效率低下。另一种方法是使用软策略,通过允许所有可能的动作被执行,即使它们带来的回报可能不如贪婪策略明显,也能保证状态空间的遍历。

区分On-Policy和Off-Policy方法是无模型强化学习的另一个关键概念。On-Policy方法是指策略与实际执行的策略一致,而Off-Policy则指学习的策略与执行策略不一致。On-Policy方法通常更容易保证探索,但可能收敛速度较慢;Off-Policy方法在理论上可能更快收敛,但实际应用中需要处理数据重采样等复杂问题。

蒙特卡洛算法在无模型强化学习中扮演了至关重要的角色,它通过随机探索、经验积累和策略调整,为在缺乏环境模型的情况下估计和优化策略提供了有效的手段。理解并掌握这种算法对于理解和实施无模型强化学习至关重要。

2024-04-11 上传

121 浏览量

128 浏览量

2023-02-23 上传

2022-11-30 上传

155 浏览量

2023-02-23 上传

2022-05-31 上传

Josephq_ssp

- 粉丝: 3

最新资源

- 昆仑通态MCGS嵌入版_XMTJ温度巡检仪软件包解压教程

- MultiBaC:掌握单次与多次组批处理校正技术

- 俄罗斯方块C/C++源代码及开发环境文件分享

- 打造Android跳动频谱显示应用

- VC++实现图片处理的小波变换方法

- 商城产品图片放大镜效果的实现与用户体验提升

- 全新发布:jQuery EasyUI 1.5.5中文API及开发工具包

- MATLAB卡尔曼滤波运动目标检测源代码及数据集

- DoxiePHP:一个PHP开发者的辅助工具

- 200mW 6MHz小功率调幅发射机设计与仿真

- SSD7课程练习10答案解析

- 机器人原理的MATLAB仿真实现

- Chromium 80.0.3958.0版本发布,Chrome工程版新功能体验

- Python实现的贵金属追踪工具Goldbug介绍

- Silverlight开源文件上传工具应用与介绍

- 简化瀑布流组件实现与应用示例