模型验证:选择与过拟合防范

需积分: 50 168 浏览量

更新于2024-07-18

收藏 1.22MB PDF 举报

模型验证与模型选择是数据科学和机器学习中至关重要的步骤,它涉及到评估和优化模型的性能,确保模型不仅能在训练数据上表现良好,还能有效地泛化到新的、未知的数据集。在IT行业中,过度简化的模型可能预测精度不足,而过于复杂的模型则容易捕捉到噪声,导致过拟合,即模型在训练数据上的表现很好,但在新数据上预测能力下降。

模型复杂度的选择是关键,它决定了模型的拟合能力。理想情况下,我们希望找到一个既能准确捕捉数据模式又不会过度拟合的平衡点。模型的复杂度可以通过各种统计量来衡量,如模型在训练数据集的误差,这可以帮助我们理解模型的拟合程度。常用的检验方法包括样本内检验和样本外检验。

样本内检验是将数据划分为训练集、验证集和测试集,通过一次抽样评估模型性能。例如,在 JoinLearn 的示例中,分析客户行为时,模型会在训练和验证阶段使用前期数据,而当期数据用于检验模型的预测能力。样本内检验在建模过程中较为常见。

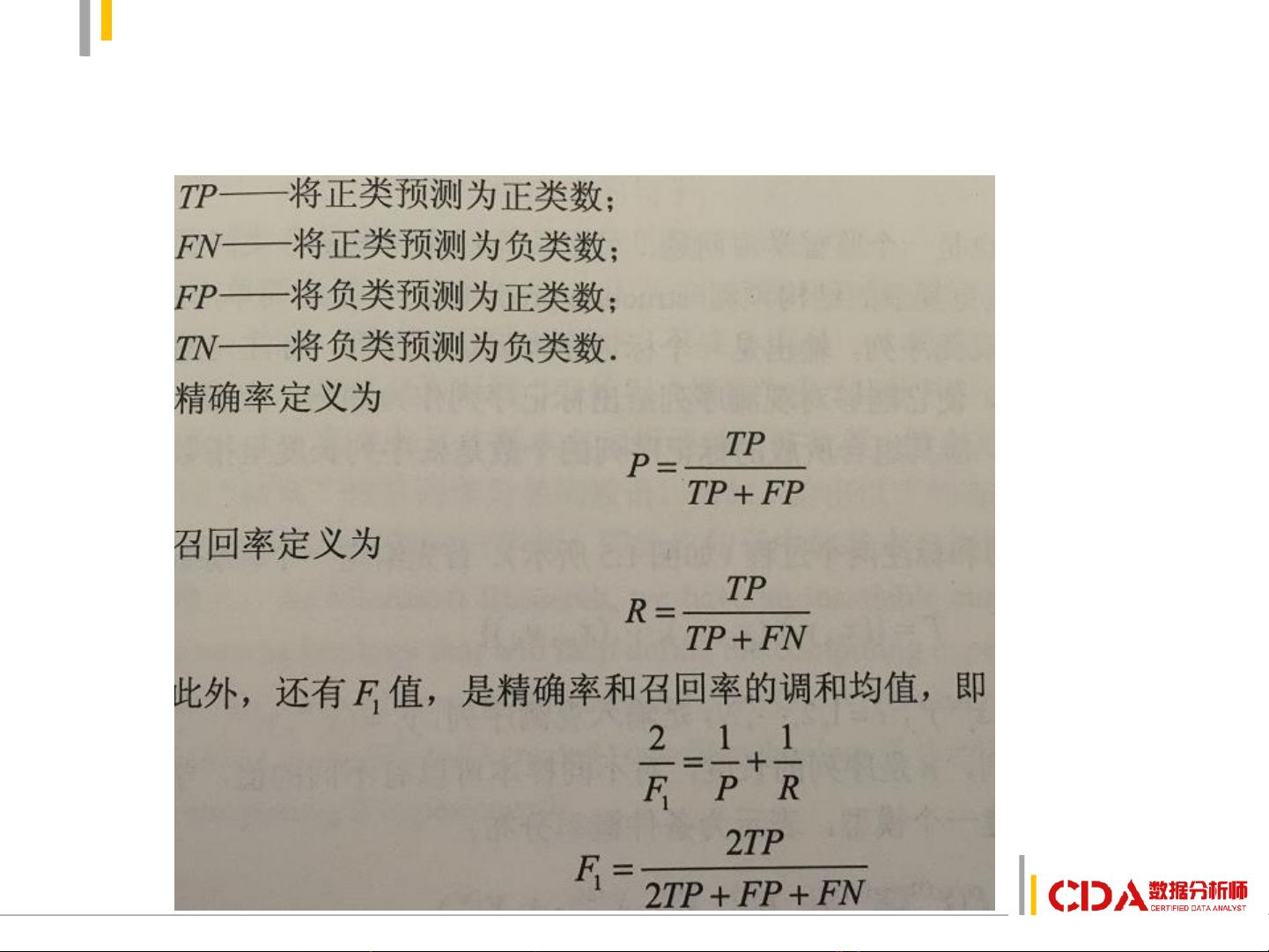

样本外检验,也称为滚动预测或交叉验证,通过移动时间窗口来评估模型,比如决策树模型可能需要后剪枝以提高泛化能力。评估指标包括精确性、误分类率、利润/成本、排序性能(如ROC曲线和Gini指数)以及估计误差等。这些指标帮助我们全面了解模型的性能,尤其是在预测类型多样化的场景下。

在实际应用中,评估数据集也需要预处理,包括数据清洗、缺失值填充、分类变量的WOE(Weight of Evidence)转换等。处理数据时,需要谨慎使用训练数据集的统计信息,避免在验证过程中引入偏差。

决策模型的主要评价指标通常包括打分值(如预测分类的准确性),如真正例(TP)、假阴性(FN)、总预测为正但实际为负的情况等,这些指标共同揭示模型在不同情况下的识别能力和效率。

模型验证与选择是数据科学家必须掌握的关键技能,它通过一系列严谨的方法和指标,帮助我们找到最佳的模型配置,从而在实际业务中实现有效和可靠的数据驱动决策。

2019-04-01 上传

2019-07-05 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

qilong0

- 粉丝: 2

- 资源: 11

最新资源

- SE21项目

- torch_sparse-0.6.2-cp36-cp36m-win_amd64whl.zip

- APScheduler-3.0.0rc1-py2.py3-none-any.whl.zip

- json-rpc-error:JSON RPC 2.0错误

- 语音合成的Arduino

- InOut

- ACM-Portfolio-Presentation

- Vision.NET-开源

- netflix克隆

- dubtechradiopage:dub techno shoutcast流页面

- torch_spline_conv-1.2.0-cp36-cp36m-win_amd64whl.zip

- Atalantis:狂野黑客 2014

- :fire:一个用于Android原生精灵的PLT钩子库

- aidanblog

- 窗口对象

- timerpool-开源