深度卷积神经网络:图像处理中尺寸与参数的关系详解

153 浏览量

更新于2024-08-28

1

收藏 388KB PDF 举报

图像处理中的深度卷积神经网络是一种广泛应用在计算机视觉任务中的模型,特别是用于图像分类和特征提取。其核心是卷积层,通过一系列参数如核尺寸(kernel size)、padding、stride等来控制输出尺寸。在深度神经网络架构中,这些参数对于保持空间信息和网络的可解释性至关重要。

输出尺寸(oho_hoh,owo_wow)是由输入尺寸(nhn_hnh,nwn_wnw)以及卷积操作中的几个关键因素决定的。具体计算公式如下:

- o_h = (n_h + p_h - k_h + s_h) / s_h

- o_w = (n_w + p_w - k_w + s_w) / s_w

其中,n_h 和 n_w 分别代表输入的高度和宽度,p_h 和 p_w 是padding的数量(两侧各加pad/2),k_h 和 k_w 是核的尺寸,s_h 和 s_w 是stride的值。padding的作用是增加输入的空间,使得在不改变输出尺寸的情况下,可以保留更多的上下文信息,而stride则控制了卷积核在输入上的移动步长。

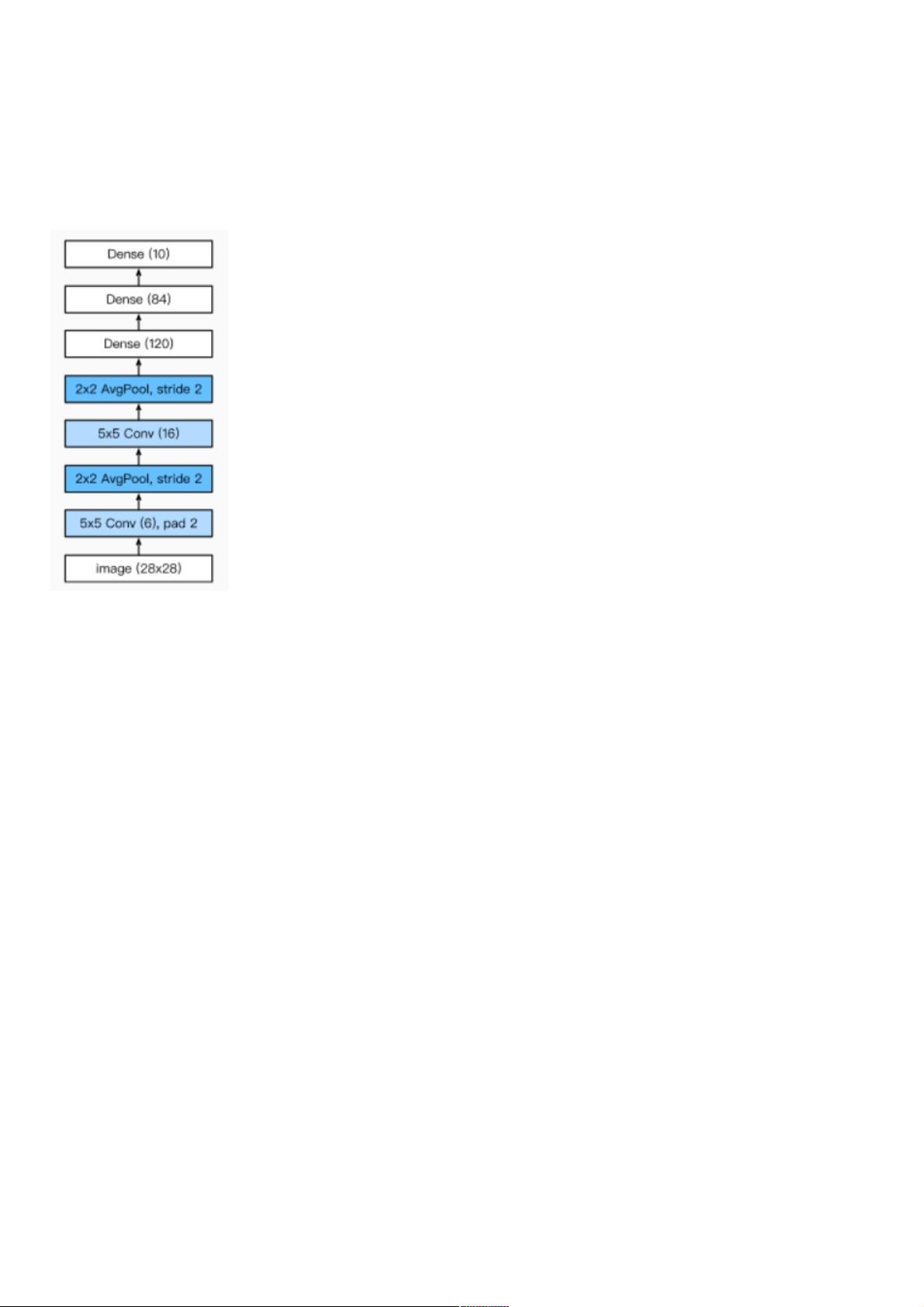

举个例子,LeNet是早期的卷积神经网络模型,应用于MNIST数据集,其结构包括两个卷积层、两次平均池化(MaxPooling)和全连接层。在LeNet的第一层卷积中,kernel大小为6x5x5,pad为2,stride为1,这导致输出尺寸从28x28变为28x28。第二层卷积和池化则进一步缩小了特征图的尺寸,最终展平成一个400维的向量,用于全连接层的输入。

AlexNet是更复杂的深度卷积神经网络,它针对ImageNet数据集设计,输入尺寸为3通道的224x224。AlexNet通常包含多个卷积层、池化层和全连接层,每个部分都有不同的参数设置,旨在提取丰富的特征并进行精确的分类。

理解这些参数之间的关系对于构建和调整深度卷积神经网络至关重要,因为它们直接影响模型的性能和计算效率。通过调整这些参数,可以实现从低级特征的提取到高级语义的理解,使得深度卷积神经网络在图像识别、物体检测、人脸识别等领域取得了显著的进步。

4019 浏览量

2025 浏览量

2022-12-16 上传

点击了解资源详情

点击了解资源详情

159 浏览量

164 浏览量

225 浏览量

477 浏览量

weixin_38672731

- 粉丝: 5

- 资源: 952

最新资源

- Android MVP 快速开发框架Android-ZBLibrary-master

- subject1_raw_mri.zip

- 程序员必须知晓的11个C++要点-供大家学习研究参考

- 4.4 RT-Thread 完成对AT2402 一个字节的读写

- 欧盟GDPR新版数据跨境转移标准合同条款(SCCs)

- 基于STM32F407的TCS230颜色识别的程序

- 基因测序-利用psa方法对基因测序进行开发

- WPF房屋租售管理系统

- 基因二代测序-分别对blast和bwa比对结果进行统计比较-20230506

- 使用HTML和JavaScript编写的猜数字游戏

- 基因测序-统计扩增子引物对应数据库的不同碱基的情况-20230529

- Unity地图随机生成插件 TileWorldCreator 3 v3.1.2p1

- YOLOv8 缺陷检测之AnyLabeling标注格式转换成YOLO格式, YOLO数据集划分为训练集,验证集和测试集

- 新路由3 newifi3 d2刷老毛子Padavan固件

- 答案.rar

- Web-Design-Challenge