XGBoost:GBDT的优化与回归树集成详解

需积分: 0 21 浏览量

更新于2024-08-05

收藏 1.49MB PDF 举报

GBDT(Gradient Boosting Decision Trees)和XGBoost都是基于梯度提升(Gradient Boosting)的机器学习算法,特别用于解决回归和分类问题。它们的核心思想是通过迭代地添加新的弱预测模型(如决策树),每个模型针对前一轮模型的残差进行修正,以逐步提高整体预测精度。

XGBoost是GBDT的一种优化版本,它引入了多项改进。首先,XGBoost使用了二阶导数来估计模型的拟合优度,这使得它在处理非线性和复杂数据时更为精确。其次,正则化项的加入控制了模型的过拟合,增强了模型的泛化能力。这种正则项通常基于树的复杂度,例如树的深度、叶节点数量和特征的重要性。

回归树,特别是CART(Classification and Regression Tree),在XGBoost中扮演了基础角色。每个决策树的叶子节点存储一个值,用于预测输出。决策树的集成方法,如GBM(Gradient Boosting Machine)和随机森林,因其诸多优点而被广泛应用在数据挖掘领域,如易用性、对特征尺度不敏感、能捕捉高阶特征交互和良好的可扩展性(Scalability)。可扩展性涉及到算法能否有效地利用多处理器资源,XGBoost的设计考虑了这一点,使得它在大规模数据和计算资源上表现优秀。

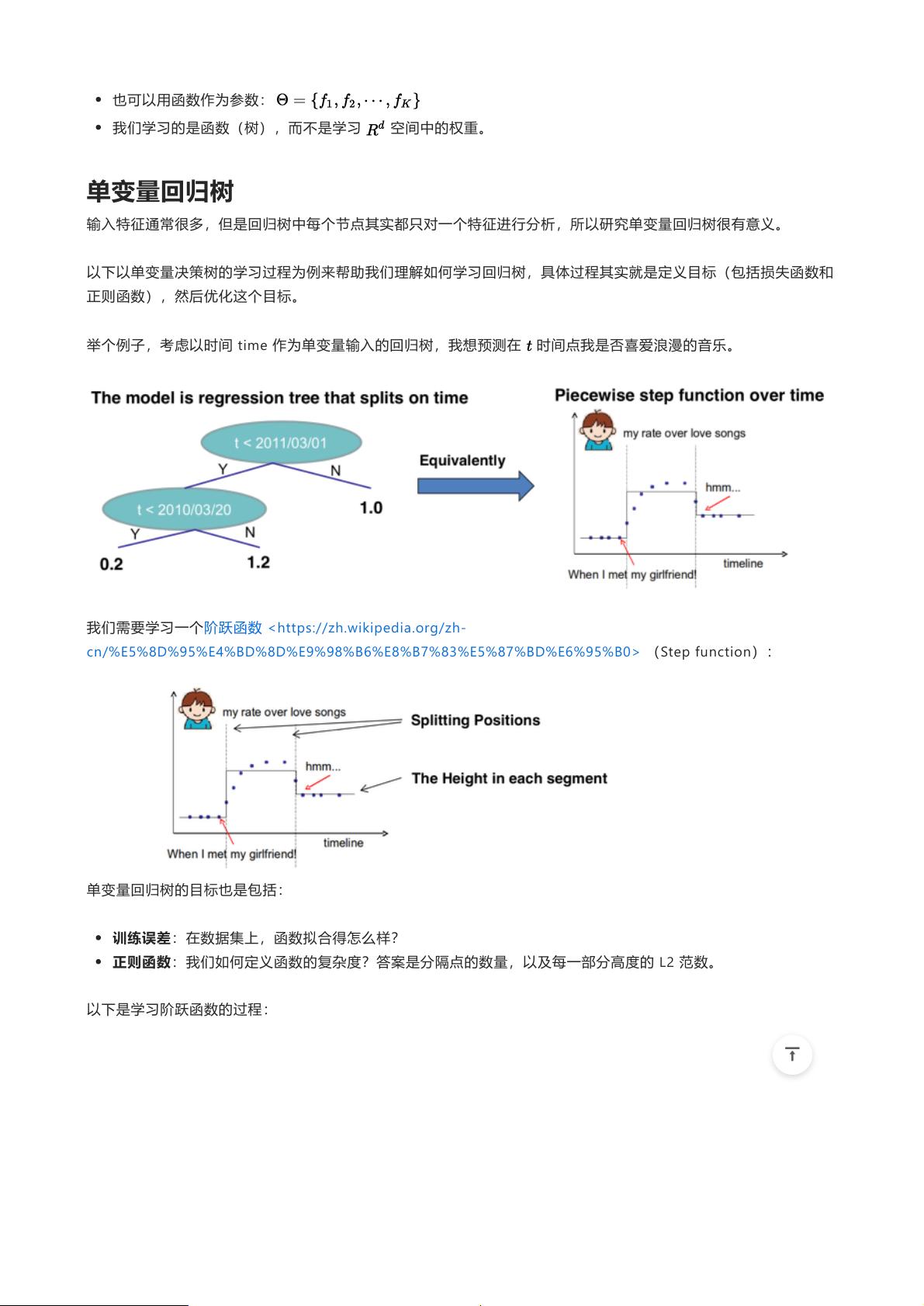

回归树的优势在于其参数化表示:学习的是整个函数(树),而非权重向量,这意味着即使面对大量输入特征,每个决策树只需关注单个特征,从而简化了模型构建。学习过程涉及定义损失函数和正则项,如训练误差(衡量模型对训练数据的拟合程度)和正则函数(控制模型复杂度,如分隔点数量和叶子区域的平方和)。

在XGBoost中,学习单变量回归树是一个具体示例,如预测一个人在特定时间点是否喜欢浪漫音乐。通过递归分割数据,构建一个阶跃函数,以最小化训练误差和正则项,实现模型的优化。

总结来说,XGBoost是GBDT的一个进化,通过增强优化技术,提供了更高效和稳健的回归与分类解决方案。它的可扩展性和对复杂数据的处理能力使其成为工业界首选的机器学习工具之一。

213 浏览量

2649 浏览量

209 浏览量

170 浏览量

839 浏览量

2649 浏览量

423 浏览量

209 浏览量

286 浏览量

大禹倒杯茶

- 粉丝: 24

最新资源

- VB通过Modbus协议控制三菱PLC通讯实操指南

- simfinapi:R语言中简化SimFin数据获取与分析的包

- LabVIEW温度控制上位机程序开发指南

- 西门子工业网络通信实例解析与CP243-1应用

- 清华紫光全能王V9.1软件深度体验与功能解析

- VB实现Access数据库数据同步操作指南

- VB实现MSChart绘制实时监控曲线

- VC6.0通过实例深入访问Excel文件技巧

- 自动机可视化工具:编程语言与正则表达式的图形化解释

- 赛义德·莫比尼:揭秘其开创性技术成果

- 微信小程序开发教程:如何实现模仿ofo共享单车应用

- TrueTable在Windows10 64位及CAD2007中的完美适配

- 图解Win7搭建IIS7+PHP+MySQL+phpMyAdmin教程

- C#与LabVIEW联合采集NI设备的电压电流信号并创建Excel文件

- LP1800-3最小系统官方资料压缩包

- Linksys WUSB54GG无线网卡驱动程序下载指南