Ceph源码解析:深入理解OSD数据处理机制

需积分: 5 120 浏览量

更新于2024-06-22

1

收藏 1.71MB PDF 举报

"Ceph源码分析:osdc.pdf"

Ceph是一个开源的分布式存储系统,以其高可用性、可扩展性和高性能而闻名。在Ceph系统中,对象存储设备(OSD)是负责实际数据存储的组件,而数据的管理和分布则通过一系列复杂的映射机制来实现。本文件主要关注Ceph中的OSD操作,特别是数据写入过程中的对象到PG(Placement Group)的映射,以及PG到OSD的映射。

首先,文件写入时,数据会被按照预设的块大小进行切分。在这个例子中,object_size设置为4M,而stripe_unit为1M,stripe_count为6,意味着每个对象由6个1M的条带组成。此外,还有buffer_offset和buffer_length用于管理缓冲区。对象的编号从obj-0到obj-8,表示有9个对象参与存储。

在数据写入过程中,`AbstractImageWriteRequest::send_request()`方法起着关键作用。它将写入请求封装为`ObjectOperation`,并添加了pool的地址信息,形成`Objector::Op`对象。然后,这些操作通过`objecter->op_submit`提交给对应的OSD进行处理。

Ceph的对象(object)是基本的数据单元,每个对象都有一个唯一的标识(oid),由文件ID(ino)和对象顺序ID(ono)组成。对象被进一步划分为多个PG,以优化数据的分布和定位。PG是一种逻辑概念,通过哈希算法将对象均匀分布在OSD上,避免因对象过多导致的管理复杂性。

对象到PG的映射是通过哈希算法实现的。以RBD(RADOS Block Device)为例,对象名如`rbd_data.10a06b8b4567.0000000000001200`,其哈希值与PG数量取模,确定PGID。这种哈希与取模的策略确保了相同后缀的对象会落在相同的PG内。例如,哈希值的后八位、四位或更少位相同时,对象会落在同一PG。

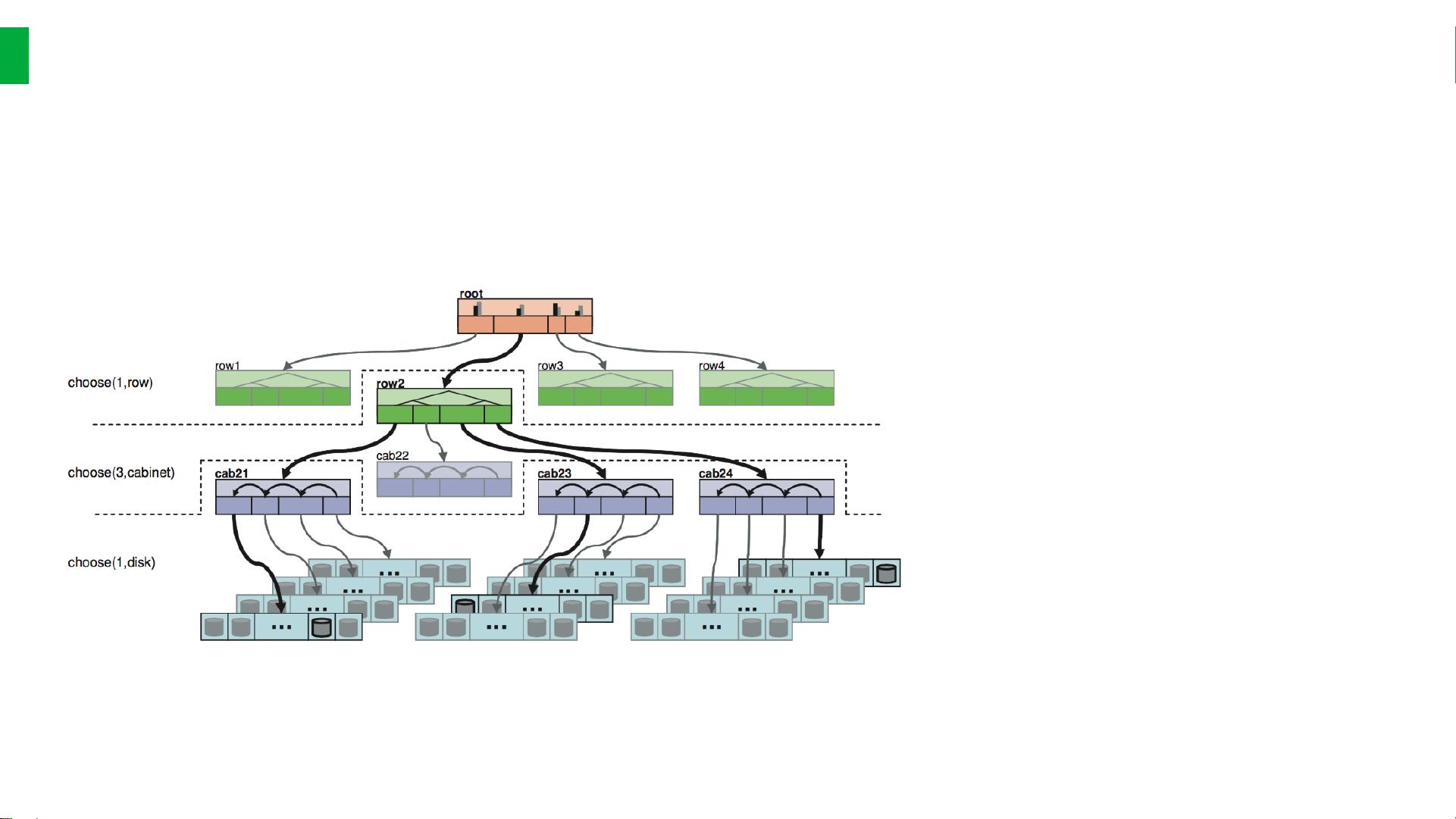

PG到OSD的映射则涉及更复杂的策略,确保数据的冗余和容错能力。通常,PG会复制到多个OSD上,以防止单点故障。具体复制策略可以根据Ceph集群的配置进行调整,如CRUSH(Controlled Replication Under Scalable Hashing)算法就是一种常用的策略。

在实际应用中,rbd_data对象存储实际的数据,而rbd_directory记录了当前pool的相关信息,如PG的位置和状态。这些信息对于Ceph的高效运行和数据一致性至关重要。

Ceph源码分析涉及了数据在Ceph存储系统中的切分、映射和分布,深入理解这些机制对于优化Ceph集群的性能和可靠性具有重要意义。通过分析源码,开发者可以更好地了解Ceph内部工作原理,并可能发现性能瓶颈或进行定制化开发。

2015-06-30 上传

2017-10-24 上传

2022-09-13 上传

2021-09-23 上传

2021-10-12 上传

2021-10-16 上传

2019-07-25 上传

cigarL

- 粉丝: 9

- 资源: 5

最新资源

- lrucacheleetcode-LeetCode:力码

- matlab傅里叶变换源码-dl_ofdm:深度波形:一种基于深度复数值卷积网络的学习型OFDM接收机

- hendone:基于Rust的快速,轻便且功能强大的Web框架

- VB俄罗斯方块游戏课程设计(源代码+论文).zip

- 讯飞农作物生长情况识别挑战赛-复赛数据.zip

- better-intellij-file-templates:IntelliJ的更强大的代码生成文件模板

- ClearURLs-crx插件

- koperasi

- 易语言-易语言找回已清空回收站内文件模块

- intro-a-dataweave

- 商业源码-编程源码-Menalto Gallery v1.5.10 多国语言版.zip

- vb大学社团管理系统设计(论文+源代码+开题报告+答辩PPT).zip

- javalist源码-Visualized_linked_List:在此存储库中包含链接列表源代码(java)由Eclipse开发

- leetcode-top-problems:我在Python中解决的顶级leetcode解决方案,并附有注释

- cordova-serve-4.0.0.tgz

- 易语言-易语言自动调节控件大小模块