UniVIP:创新的自我监督视觉预训练解决方案

4 浏览量

更新于2024-06-20

收藏 1000KB PDF 举报

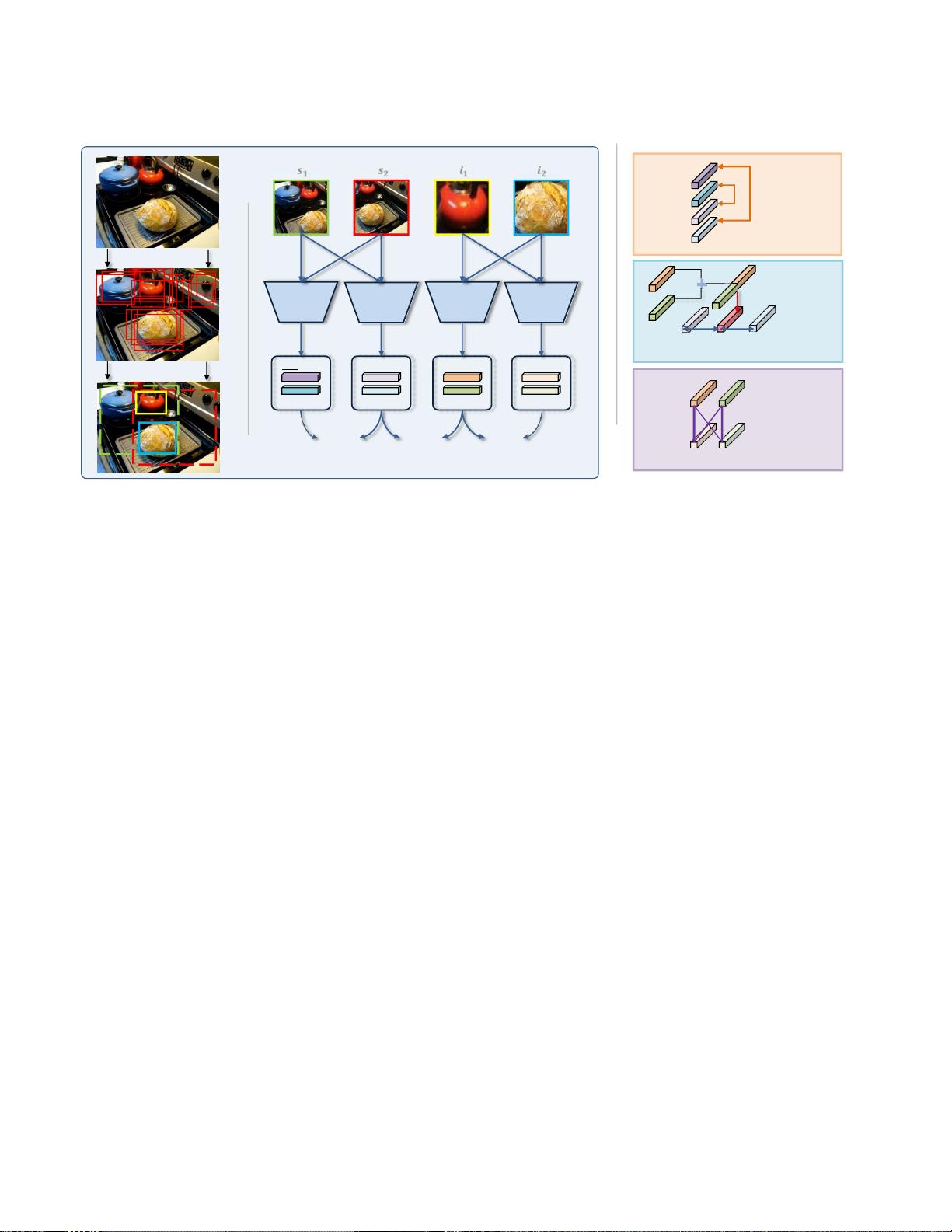

本文介绍了“UniVIP:一个统一的自我监督视觉预训练框架”,该框架旨在克服现有的自监督学习(SSL)方法在处理多中心对象和复杂场景时的局限性。传统SSL方法通常在如ImageNet这样的单一中心对象数据集上表现出色,但忽视了场景与实例之间的关联以及实例之间的差异。UniVIP提出了一种新的自监督框架,能够学习通用的视觉表示,适用于单中心对象或非图标数据集。

在 UniVIP 框架中,作者关注了三个层次的表示学习,并引入了最优迁移算法来自动评估实例的区分度。这一创新方法使得模型能够在非图标数据集如COCO上进行预训练,进而展现出优秀的下游任务性能,包括图像分类、半监督学习、对象检测和分割。实验结果证实,使用UniVIP预训练的模型在这些任务上的表现超越了现有方法,尤其是在线性探测任务中,优于BYOL 2.5%,并在COCO数据集上的对象检测任务中超过了当前的自监督方法。

文章指出,深度学习在计算机视觉领域的成功很大程度上依赖于大量标注数据,而自监督学习则为利用未标注数据提供了可能。UniVIP通过考虑实例间的关联性和差异性,增强了模型在复杂场景下的泛化能力,这在现实世界的应用中具有重要意义,如智能城市的监控、自动驾驶等场景,其中图像往往包含了丰富的多中心对象和复杂背景。

1. 知识点:

- 自监督学习(Self-Supervised Learning, SSL):一种机器学习方法,通过利用数据本身的结构作为监督信号,无需人工标注,从而学习特征表示。

- 实例区分度:衡量不同实例之间的差异性,对于理解和识别多中心对象和场景中的多样性至关重要。

- 最优迁移算法:在 UniVIP 中用于自动评估实例区分度的策略,有助于优化表示学习过程。

- 单中心对象数据集:如 ImageNet,主要包含单一主体的图像,适用于特定类型的学习任务。

- 非图标数据集:如 COCO,包含多中心对象和复杂场景,更接近实际应用中的图像。

- 通用视觉表示:能够适应不同任务和数据集的特征表示,提高模型的泛化能力。

- 下游任务:基于预训练模型进行的特定计算机视觉任务,如图像分类、对象检测和分割。

- 线性探测:评估预训练模型性能的一种方法,通过将预训练权重直接应用于线性分类器并进行测试。

通过 UniVIP,研究者希望推动自监督学习在处理多样化和复杂视觉数据时的效能,进一步降低对大规模标注数据的依赖,提升模型在真实世界应用中的实用性。

121 浏览量

840 浏览量

169 浏览量

2025-03-06 上传

2025-03-06 上传

2025-03-06 上传

2025-03-06 上传

cpongm

- 粉丝: 6

最新资源

- Saber仿真下的简化Buck环路分析与TDsa扫频

- Spring框架下使用FreeMarker发邮件实例解析

- Cocos2d捕鱼达人路线编辑器开发指南

- 深入解析CSS Flex布局与特性的应用

- 小学生加减法题库自动生成软件介绍

- JS颜色选择器示例:跨浏览器兼容性

- ios-fingerprinter:自动化匹配iOS配置文件与.p12证书

- 掌握移动Web前端高效开发技术要点

- 解决VS中OpenGL程序缺失GL/glut.h文件问题

- 快速掌握POI技术,轻松编辑Excel文件

- 实用ASCII码转换工具:轻松实现数制转换与查询

- Oracle ODBC补丁解决数据源配置问题

- C#集成连接器的开发与应用

- 电子书制作教程:你的文档整理助手

- OpenStack计费监控:使用collectd插件收集统计信息

- 深入理解SQL Server 2008 Reporting Services