Hadoop分布式文件系统(HDFS)详解:容错性与高吞吐量

需积分: 0 95 浏览量

更新于2024-07-01

收藏 864KB PDF 举报

"本文介绍了Hadoop分布式文件系统(HDFS)的基本概念、特点以及其架构组成,同时探讨了HDFS的容错机制和数据压缩算法。"

HDFS,全称为Hadoop Distributed File System,是一种专为大数据处理设计的分布式文件系统。它能够在由普通硬件组成的集群上运行,提供高容错性和高吞吐量的数据访问。HDFS的设计目标之一是应对机器故障,通过错误检测和快速恢复机制确保系统的稳定运行。文件系统中,数据分散存储在各个Datanode上,当某个节点故障时,系统能够自动检测并恢复数据,确保服务的连续性。

HDFS的一个显著特点是支持流式数据访问,这使得它非常适合大规模数据集的应用,如大数据分析和处理。文件的大小通常非常大,以G或T为单位,最小分配单位为64M,并且文件总大小必须是这个单位的整数倍。此外,HDFS采用一次写入、多次读取的一致性模型,简化了数据管理,增强了读取效率。

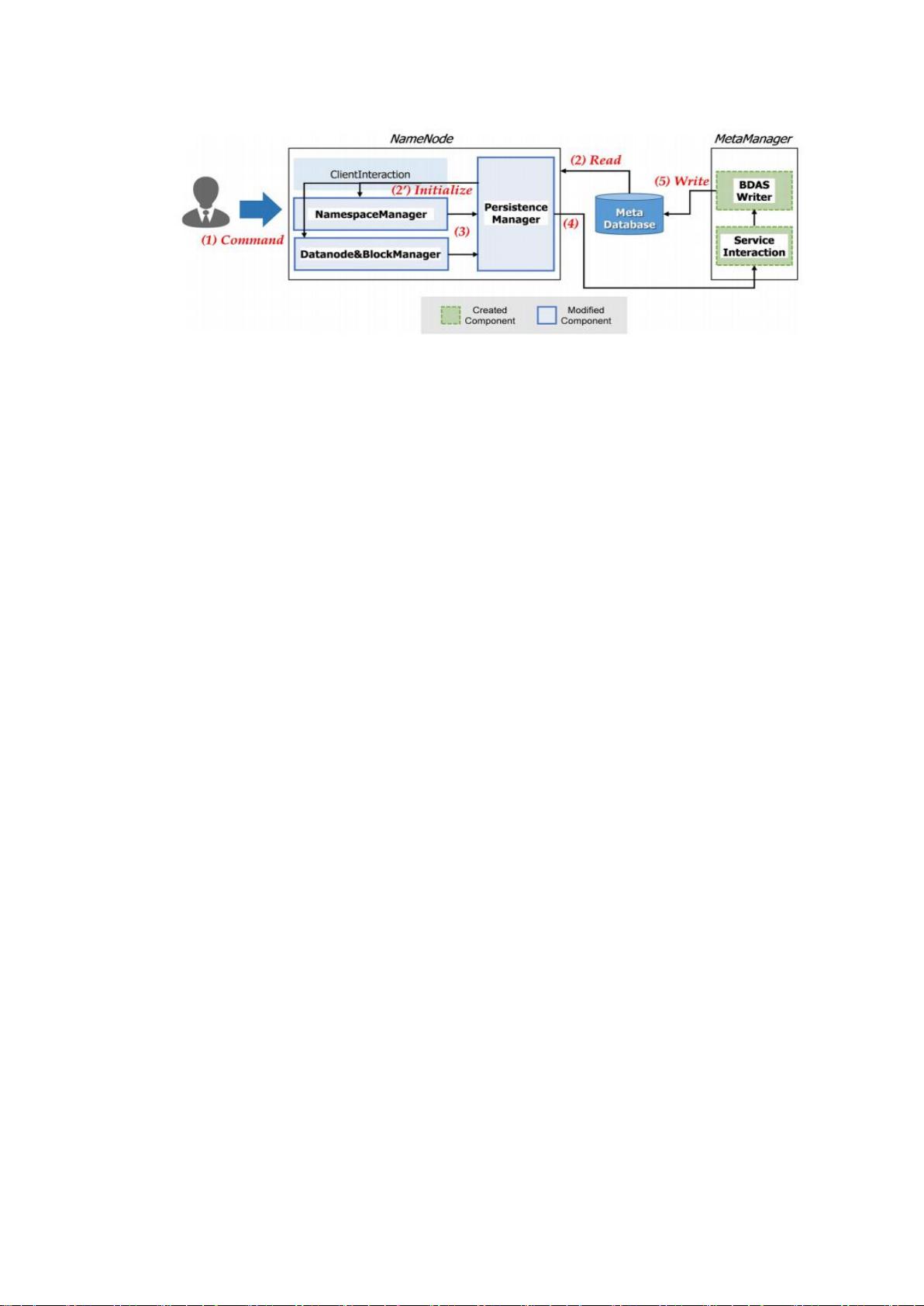

HDFS架构主要由Namenode和Datanode构成。Namenode负责元数据管理,包括文件系统的命名空间和文件位置信息。Datanode则负责实际的数据存储,它们通常分布在多台运行Linux操作系统的机器上。Java语言的使用使得HDFS具有良好的跨平台性,可以轻松部署在各种硬件环境中。一个集群通常有一个Namenode,多个Datanode,但也可以根据需求在同一台机器上运行多个Datanode。

在数据压缩方面,HDFS支持两种类型的压缩:可拆分和不可拆分。可拆分的压缩算法允许在不完全解压整个文件的情况下,对数据块进行局部处理,提高了处理效率。不可拆分的压缩算法则需要先完全解压,然后进行处理,适合对完整文件进行一次性处理的场景。

HDFS是为处理大规模数据而生的分布式文件系统,它的设计原则是高可用性、高吞吐量和低成本,通过巧妙的架构设计和数据处理策略,实现了在普通硬件上的高效大数据存储和处理。

2021-01-20 上传

2021-01-07 上传

2021-01-20 上传

2022-08-08 上传

2022-08-08 上传

2021-09-15 上传

2013-08-25 上传

2018-11-15 上传

2020-09-09 上传

啊看看

- 粉丝: 37

- 资源: 323

最新资源

- stm32学习代码.zip

- Python自动化神器-PyAutoGUI(1)

- 简历-求职简历-word-文件-简历模版免费分享-应届生-高颜值简历模版-个人简历模版-简约大气-大学生在校生-求职-实习

- torch_scatter-2.0.7-cp39-cp39-win_amd64whl.zip

- torch_cluster-1.5.9-cp39-cp39-win_amd64whl.zip

- torch_scatter-2.0.7-cp39-cp39-linux_x86_64whl.zip

- torch_cluster-1.5.9-cp39-cp39-linux_x86_64whl.zip

- torch_scatter-2.0.8-cp39-cp39-win_amd64whl.zip

- torch_scatter-2.0.7-cp38-cp38-win_amd64whl.zip

- torch_scatter-2.0.9-cp39-cp39-win_amd64whl.zip

- torch_cluster-1.5.9-cp38-cp38-win_amd64whl.zip

- torch_scatter-2.0.8-cp38-cp38-win_amd64whl.zip

- torch_scatter-2.0.7-cp38-cp38-linux_x86_64whl.zip

- torch_cluster-1.5.9-cp37-cp37m-win_amd64whl.zip

- torch_scatter-2.0.9-cp39-cp39-linux_x86_64whl.zip

- torch_scatter-2.0.7-cp37-cp37m-linux_x86_64whl.zip