深入理解RNN与LSTM:解决长期依赖问题

需积分: 0 67 浏览量

更新于2024-08-04

收藏 1.2MB DOCX 举报

"2017-7-26周报-王旭1"

这篇周报主要探讨了两种类型的循环神经网络(RNN)模型,即基本的RNN和长短期记忆网络(LSTM),以及它们在处理序列数据时的能力。

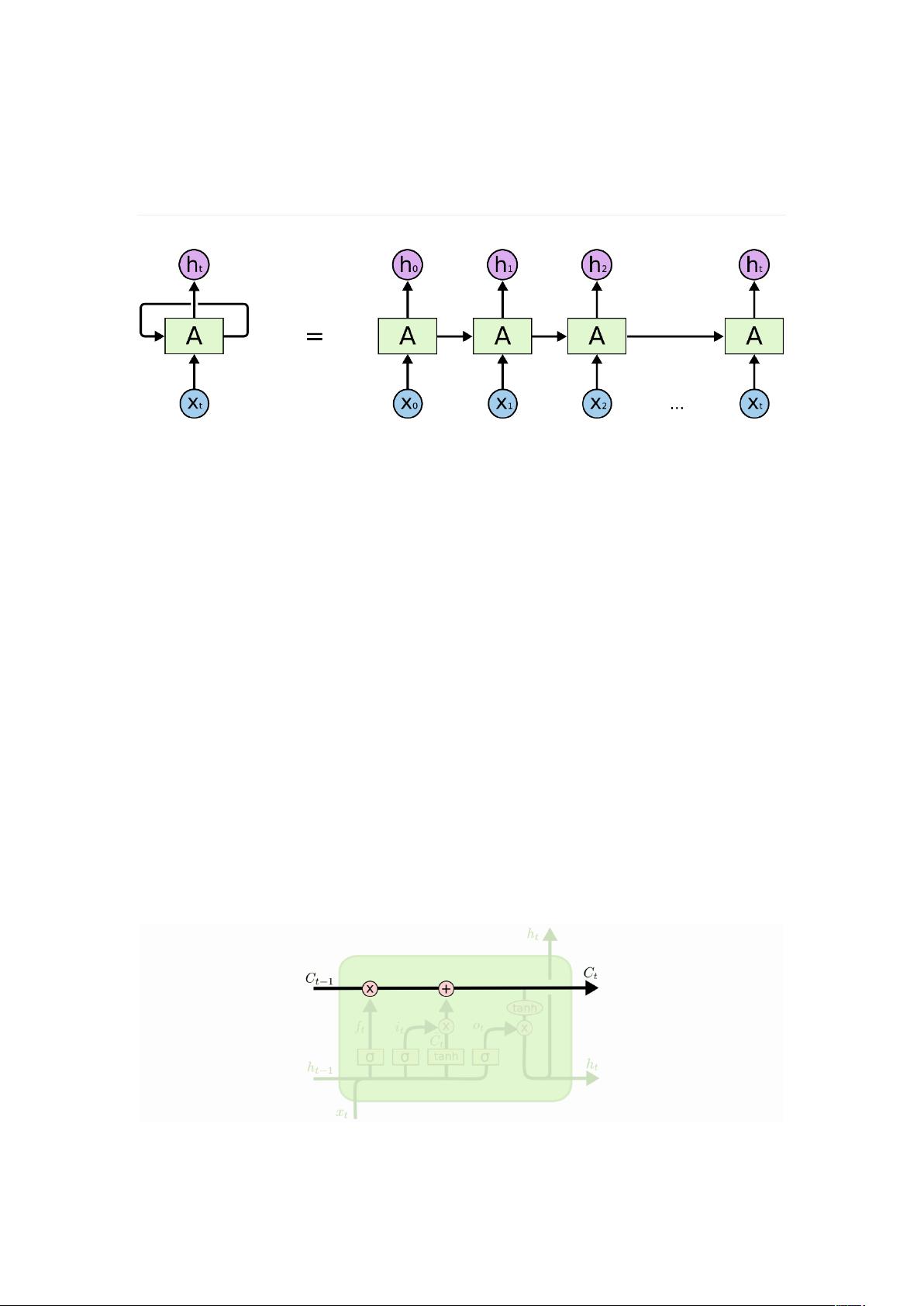

RNN(Recurrent Neural Networks)是一种具有循环结构的神经网络,这种结构允许信息在时间步骤之间传递。每个时间步的RNN单元接收当前时刻的输入和上一时刻的状态,从而能够考虑先前的上下文信息。在处理如语言、音频或时间序列数据的任务时,RNN非常有用。然而,RNN存在一个问题,即当需要捕捉远距离的依赖关系时,它们可能会遭遇梯度消失或梯度爆炸问题,导致学习效率降低。

为了解决这个问题,LSTM(Long Short-Term Memory Network)应运而生。LSTM的核心创新在于引入了单元状态(cell state),它是一个贯穿整个序列的“记忆通道”,允许信息无损地从序列的开始传递到结束。LSTM通过门控机制(gates)来控制单元状态中的信息流。门控包括遗忘门、输入门和输出门,它们都是基于sigmoid激活函数的层,能够输出介于0和1之间的值,用于控制信息的添加、移除和输出。

遗忘门负责决定保留或丢弃单元状态中的哪些信息。输入门则控制新信息如何进入单元状态,通常先通过一个sigmoid层决定哪些新信息应该被考虑,然后通过一个tanh层生成一个新的候选状态向量。输出门则决定了根据单元状态应当输出的内容,它同样先通过sigmoid层决定输出的量,然后将经过tanh激活的单元状态与sigmoid门的输出相乘,得到最终的输出。

除了标准的LSTM结构,还有对其的改进,例如窥视孔连接(peephole connections),这种连接方式允许门控层直接看到单元状态,从而更精确地控制信息流动。另一种变体是门控循环单元(Gated Recurrent Unit, GRU),它将输入门和遗忘门合并为一个单一的更新门,简化了LSTM的结构,同时在某些情况下可以达到类似的性能。

LSTM和GRU等变种通过增强RNN的能力,有效解决了长距离依赖的学习问题,提高了在序列数据建模任务中的表现,尤其在自然语言处理、语音识别和时间序列预测等领域有着广泛的应用。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传