视觉SLAM基础:从传感器到优化

需积分: 14 143 浏览量

更新于2024-07-19

收藏 9.53MB PPTX 举报

"The Basics about Visual SLAM 是高翔(半闲居士),在清华大学自动化系于2016.7年的ROS暑期学校中讲解的关于视觉SLAM的基础知识。讲座内容涵盖了视觉SLAM的基本概念、应用、传感器类型、视觉SLAM的实现方式及其挑战,以及SLAM的数学模型和框架。"

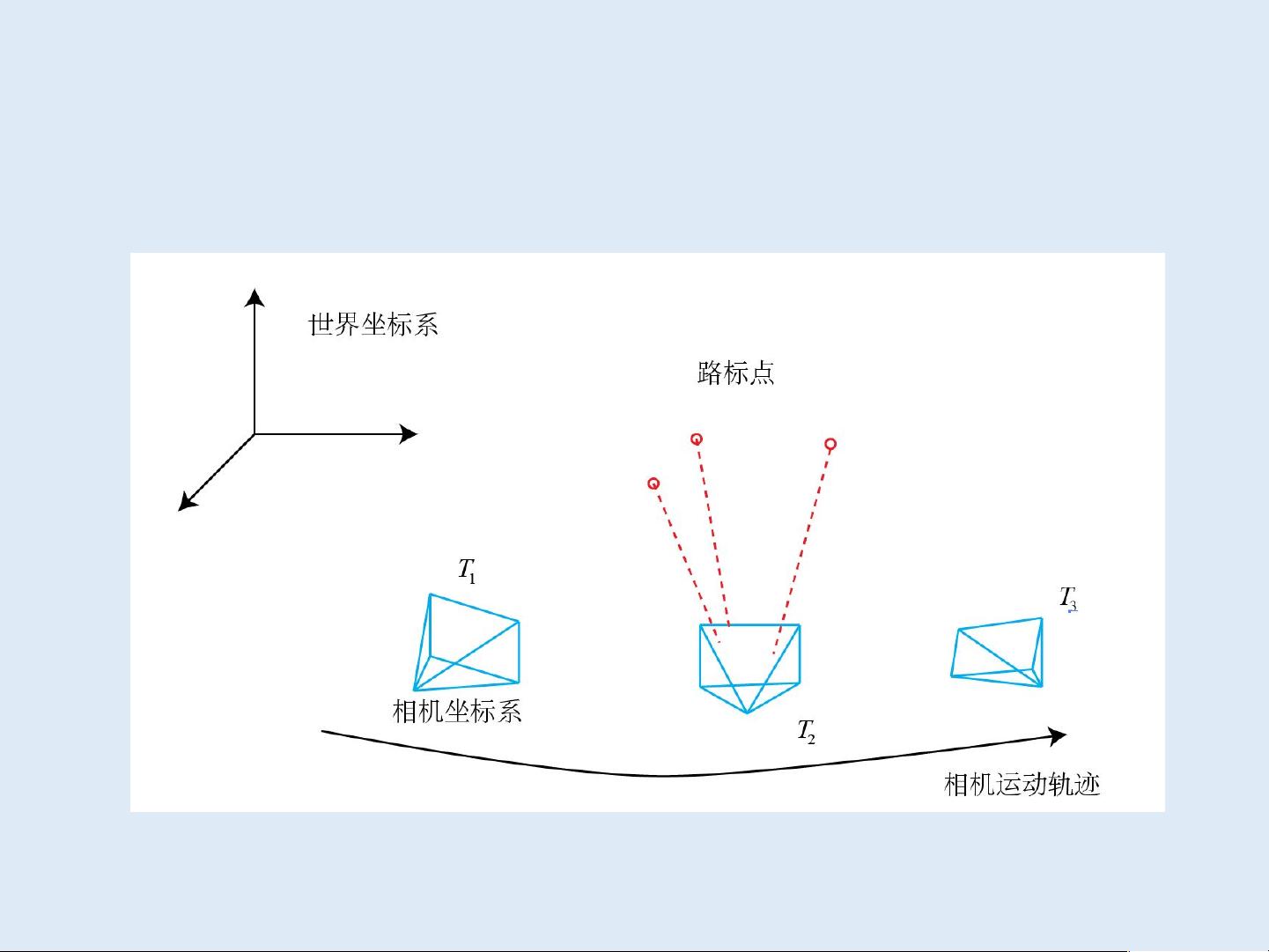

视觉SLAM(Simultaneous Localization and Mapping)是机器人领域的一个关键问题,它涉及机器人在未知环境中同时定位自身位置并构建环境地图。SLAM的应用广泛,包括机器人导航、无人机控制、增强现实(AR)、虚拟现实(VR)以及智能硬件等领域。

在SLAM过程中,内部传感器如视觉、激光雷达(LiDAR)、惯性测量单元(IMU)和轮速计等扮演重要角色。内部传感器无需对外部环境做特定假设,因此适用于各种环境,但它们的观测通常较为间接且易受噪声影响。视觉传感器,特别是摄像头,因其成本低、体积小、信息丰富而被广泛采用,但处理视觉数据的计算量大,且容易受到光照变化和动态物体的影响。

视觉SLAM根据传感器的不同可以分为单目、双目和RGB-D(彩色+深度)等类型。单目SLAM仅使用一个摄像头,计算复杂度相对较低,但解算相对困难;双目SLAM利用视差计算深度信息,提供更丰富的三维信息;RGB-D传感器则同时提供颜色和深度信息,但数据处理要求较高。

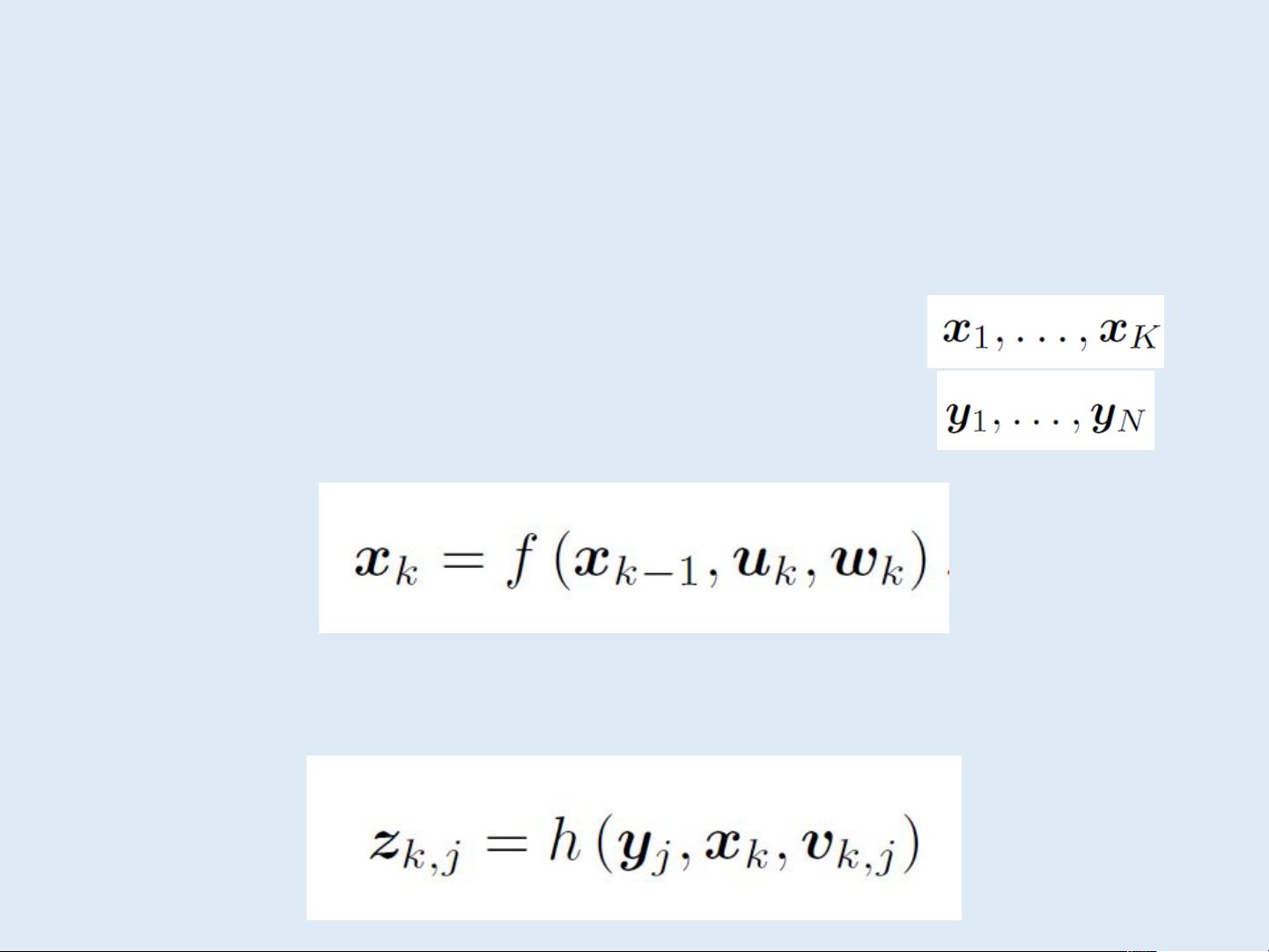

SLAM的过程通常包括前端和后端两部分。前端,即视觉里程计,负责估算相机在连续帧间的运动和路标的初始位置,通过解决特征匹配和几何校正问题。而后端则负责对前端的估计进行全局优化,确保整个轨迹的一致性和准确性。后端优化通常采用滤波器(如扩展卡尔曼滤波)或非线性优化方法(如BA,Bundle Adjustment)。

回环检测是SLAM中的另一个关键环节,用于识别机器人是否回到了先前已经访问过的区域,以修正累积误差,保持全局一致性。这通常依赖于特征匹配和场景相似性比较。

视觉SLAM是一个涉及多领域知识的复杂问题,包括图像处理、几何代数、概率统计以及优化算法等多个方面。它不仅需要处理传感器数据的噪声,还要解决不确定性问题,同时构建和更新地图,是机器人自主导航的关键技术之一。

2018-09-29 上传

247 浏览量

2018-08-28 上传

2019-04-02 上传

2022-12-04 上传

RGiant

- 粉丝: 91

- 资源: 8

最新资源

- 高清艺术文字图标资源,PNG和ICO格式免费下载

- mui框架HTML5应用界面组件使用示例教程

- Vue.js开发利器:chrome-vue-devtools插件解析

- 掌握ElectronBrowserJS:打造跨平台电子应用

- 前端导师教程:构建与部署社交证明页面

- Java多线程与线程安全在断点续传中的实现

- 免Root一键卸载安卓预装应用教程

- 易语言实现高级表格滚动条完美控制技巧

- 超声波测距尺的源码实现

- 数据可视化与交互:构建易用的数据界面

- 实现Discourse外聘回复自动标记的简易插件

- 链表的头插法与尾插法实现及长度计算

- Playwright与Typescript及Mocha集成:自动化UI测试实践指南

- 128x128像素线性工具图标下载集合

- 易语言安装包程序增强版:智能导入与重复库过滤

- 利用AJAX与Spotify API在Google地图中探索世界音乐排行榜