深入解析HiveSQL:技术原理、优化与面试关键点

需积分: 1 5 浏览量

更新于2024-06-14

收藏 598KB PDF 举报

"本文详细介绍了HiveSQL的技术原理、优化方法以及在面试中的相关知识,包括HiveSQL如何被编译成MapReduce任务,以及在处理千亿级数据倾斜问题上的策略。此外,还涵盖了Hive的执行计划和底层执行架构,为读者提供了全面的理解。”

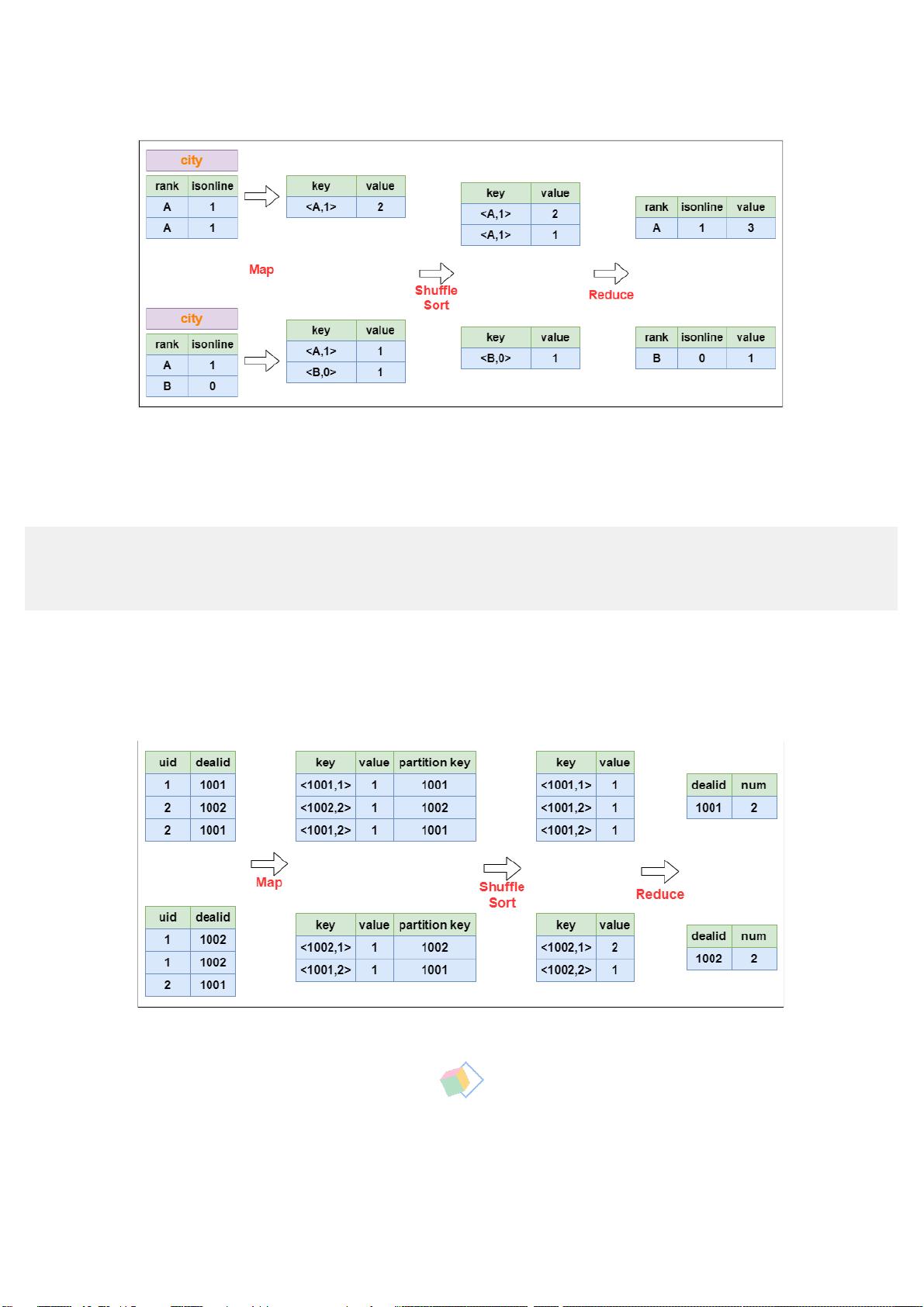

在大数据领域,Hive作为一款基于Hadoop的数据仓库工具,被广泛用于处理大规模数据集的查询和分析。HiveSQL是其核心,它允许用户使用类似SQL的语法来操作存储在Hadoop中的数据。本文深入探讨了HiveSQL的编译过程,这对于理解和优化Hive查询至关重要。

首先,HiveSQL的编译过程分为六个阶段:

1. 词法、语法解析:使用Antlr工具,将SQL语句解析成抽象语法树(ASTTree)。Antlr是一个强大的解析工具,可以自定义词法规则和语法规则,生成解析树,为后续处理提供基础。

2. 语义解析:遍历ASTTree,识别查询的基本结构,如查询块(QueryBlock)。

3. 生成逻辑执行计划:将QueryBlock转换为操作树(OperatorTree),这是逻辑层面的执行流程。

4. 优化逻辑执行计划:通过逻辑层优化器对OperatorTree进行调整,例如合并操作,减少MapReduce作业的数量,降低数据传输和shuffle的负担。

5. 生成物理执行计划:将优化后的OperatorTree转化为实际的MapReduce任务。

6. 优化物理执行计划:物理层优化器进一步调整MapReduce任务,生成最终的执行计划,以提高效率。

以一个简单的查询为例,如“select * from dim.dim_region where dt='2021-05-23'”,这个查询经过词法和语法解析后,形成ASTTree,接着通过语义解析抽象出QueryBlock,然后逐步生成并优化执行计划,最终转化为MapReduce任务执行。

在处理大数据时,尤其是面对千亿级数据倾斜的问题,Hive需要采取特殊策略。数据倾斜可能导致某些节点处理的数据远多于其他节点,从而影响整体性能。解决数据倾斜可能涉及重新分区、哈希分桶、动态分区等方法,以确保数据均匀分布。

此外,了解Hive的执行计划和底层执行架构有助于优化查询性能。执行计划包括Map和Reduce任务的分配,数据读取、转换和写入的步骤。而底层执行架构则涉及到HDFS、HBase等组件的交互,以及如何利用Hadoop集群资源。

在求职面试中,对HiveSQL技术原理的掌握,以及对优化和数据倾斜问题的解决能力,都是评估候选人技能的重要标准。因此,深入理解这些内容对于在大数据领域求职者来说非常关键。

2023-04-21 上传

2023-05-11 上传

2023-07-22 上传

2024-01-29 上传