斯坦福CS231N 2017:卷积神经网络架构讲座

需积分: 9 166 浏览量

更新于2024-07-19

收藏 2.34MB PDF 举报

"这是斯坦福大学2017年CS231N课程的幻灯片,专注于计算机视觉领域的深度学习框架及其应用。"

在CS231N的第9次讲座中,主要讨论了卷积神经网络(CNN)的设计与架构。这门课程由Fei-Fei Li、Justin Johnson和Serena Yeung主讲,于2017年5月2日进行。讲座涵盖了多项管理事项,包括A2作业将在5月4日星期四截止,期中考试将于5月9日星期二进行,内容涵盖至5月4日的讲座,以及6月6日的海报展示会。

讲座上一次的主题是深度学习框架,其中提到了多种流行的框架,如Caffe(来自加州大学伯克利分校)、Torch(由纽约大学和Facebook开发)、Theano(蒙特利尔大学)、TensorFlow(谷歌)、Caffe2(Facebook)、PyTorch(也是Facebook)、CNTK(微软)、Paddle(百度)和MXNet(亚马逊)。这些框架主要由各大科技公司支持,并且在不同的领域和场景中被广泛使用。例如,MXNet是由华盛顿大学、卡内基梅隆大学、麻省理工学院等机构开发的,但在AWS(亚马逊网络服务)中作为主要的框架选择。

深度学习框架的核心优势在于它们能够轻松构建大型计算图,并能高效地计算这些图中的梯度,充分利用GPU的性能,如通过cuDNN和cuBLAS库。这些框架的模块化设计使得定义和实现神经网络层变得简单,允许研究人员和工程师快速实验和部署新的模型。

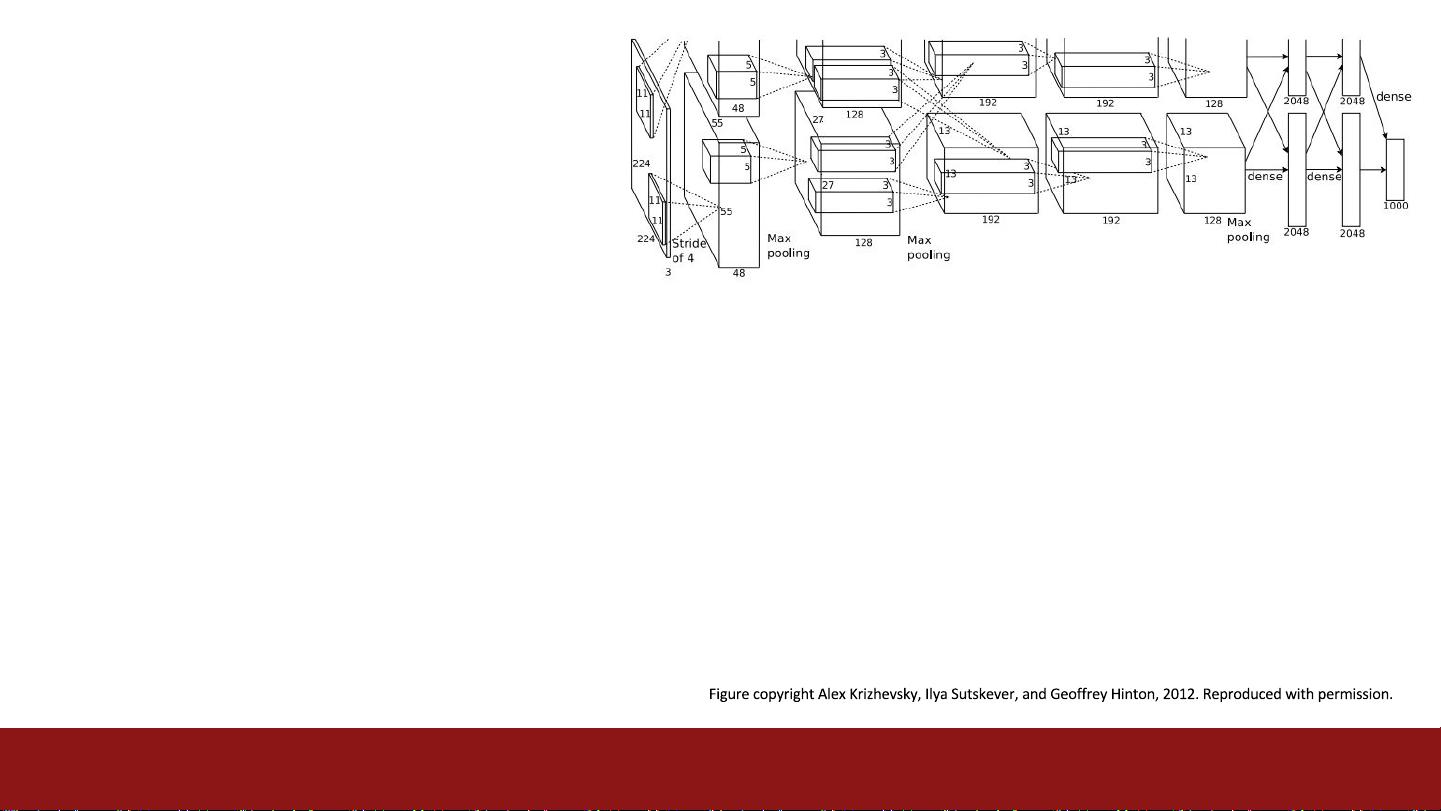

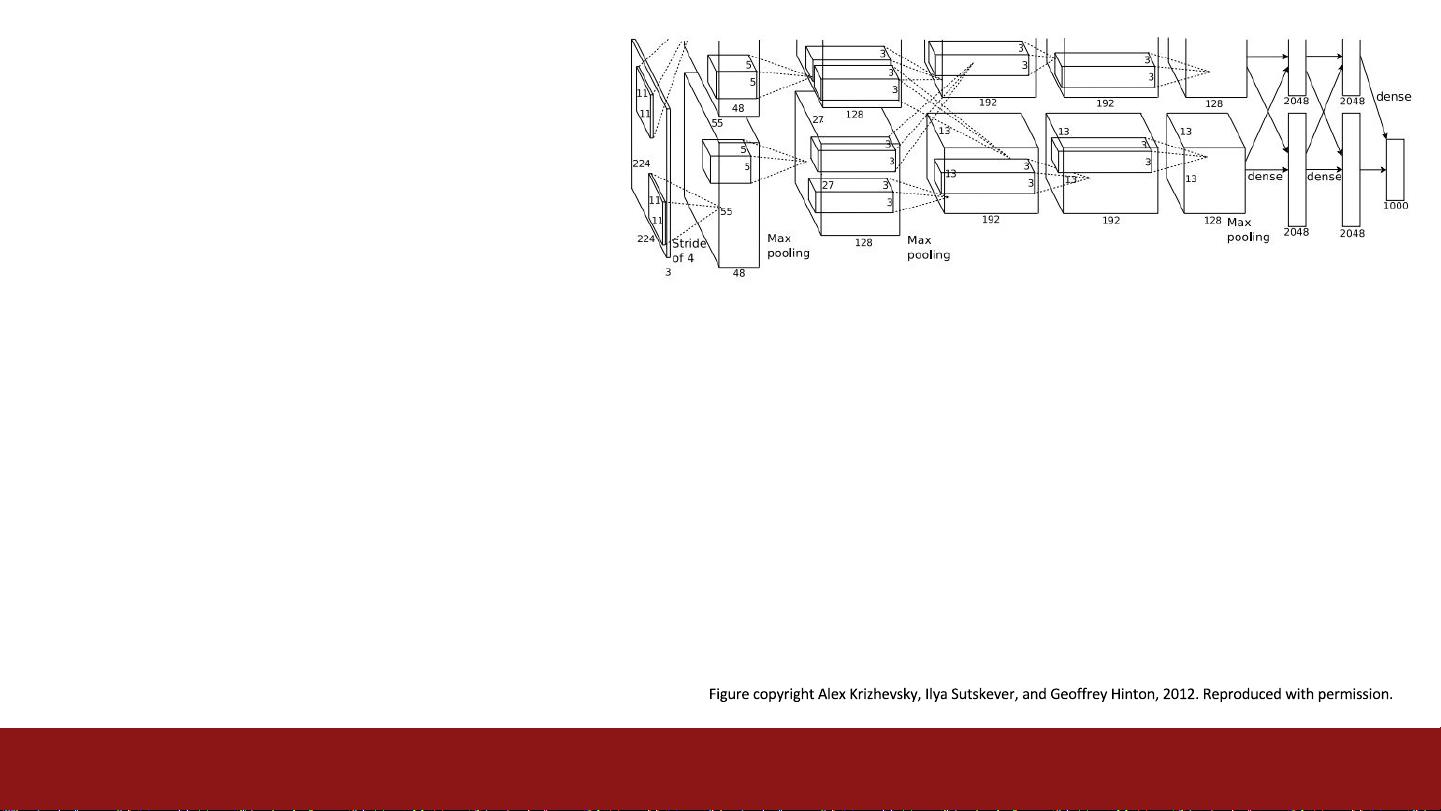

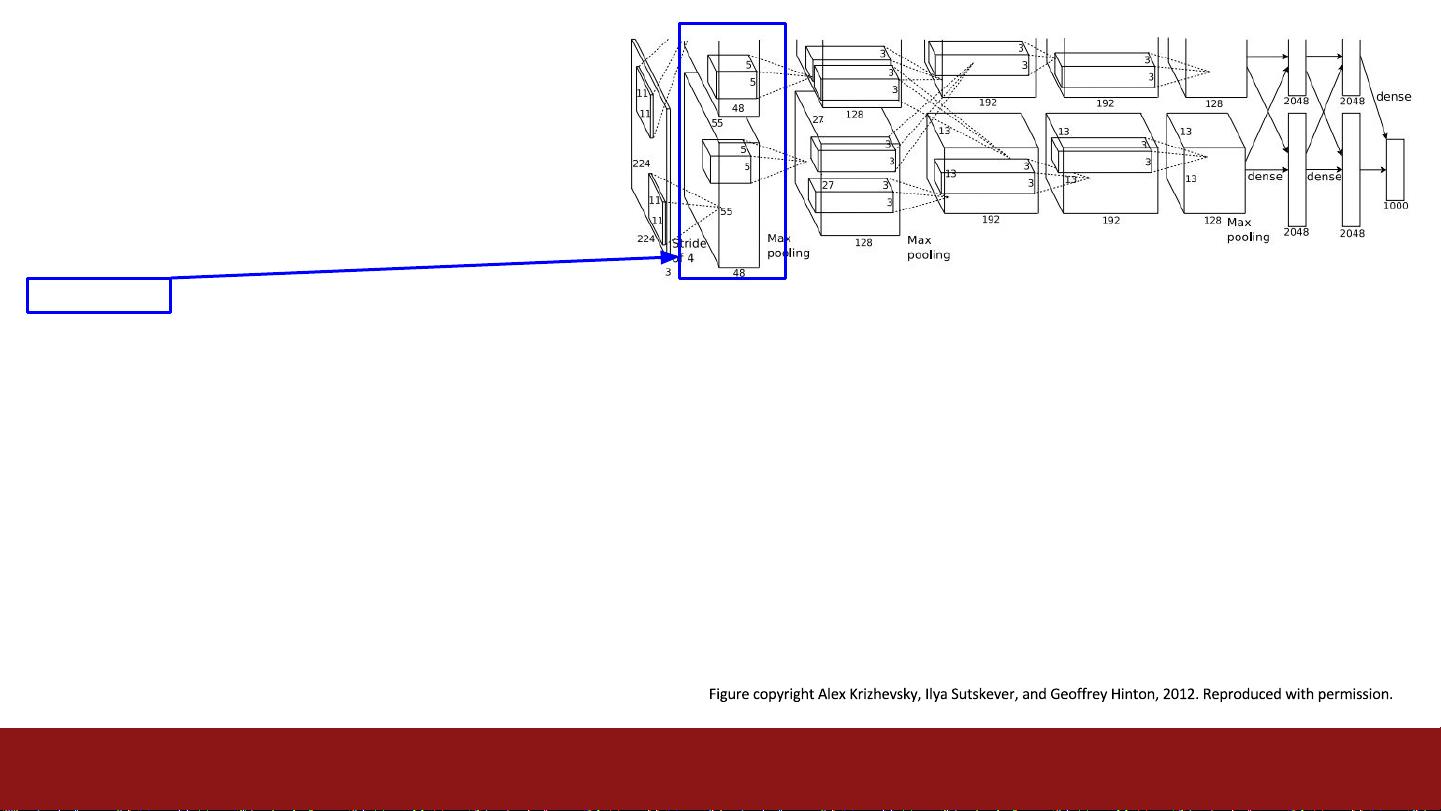

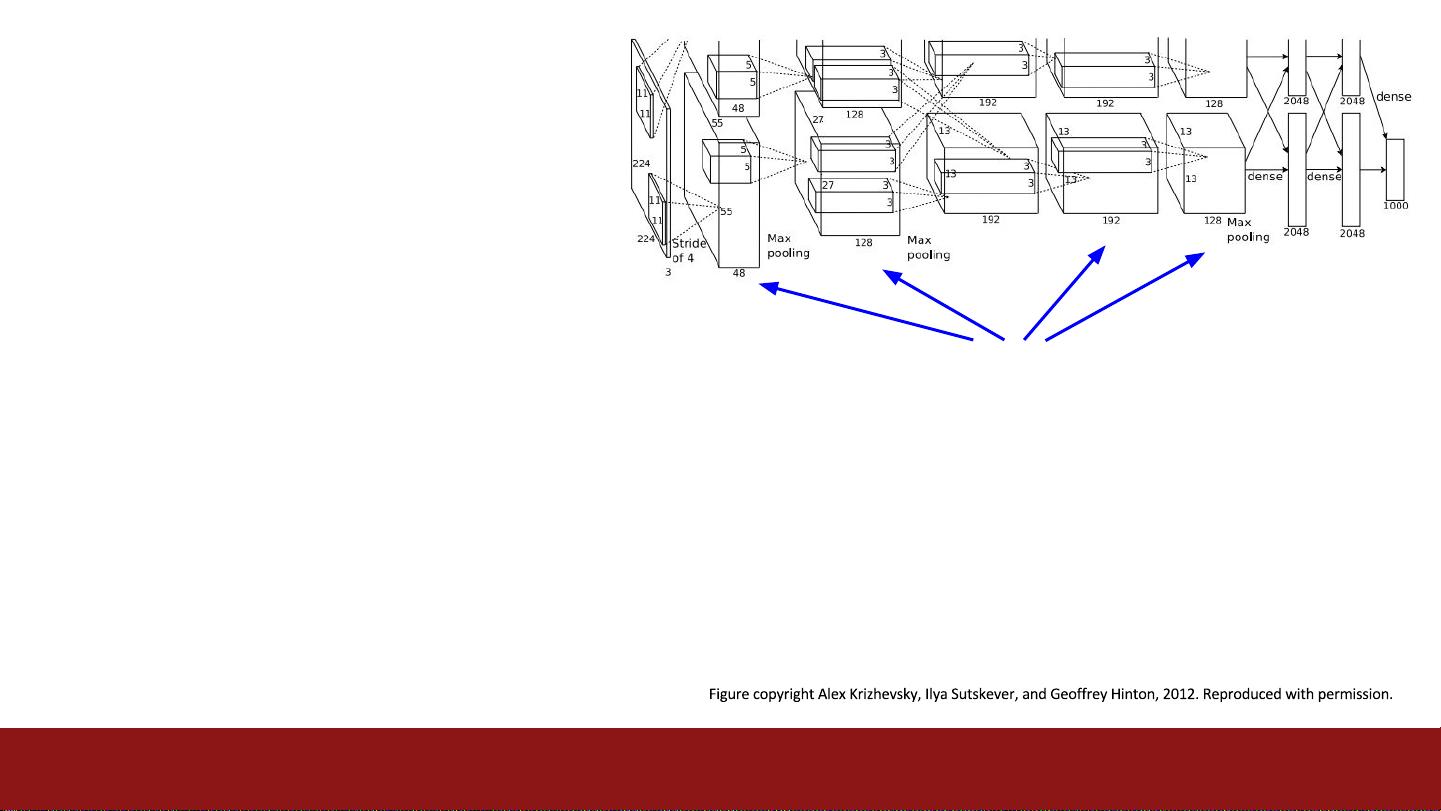

在讨论CNN架构时,课程可能涉及了各种经典和现代的网络结构,如LeNet、AlexNet、VGG、GoogLeNet (Inception)、ResNet以及当时可能新兴的网络设计。这些网络在图像分类、目标检测、语义分割等计算机视觉任务中表现出色。例如,ResNet通过引入残差块解决了深度网络训练中的梯度消失问题,允许构建非常深的网络,从而提高了模型的表达能力。

此外,课程可能还探讨了卷积层、池化层、全连接层、激活函数(如ReLU)、正则化技术(如dropout和weight decay)以及优化算法(如SGD和Adam)在构建和训练CNN中的作用。同时,数据增强技术如旋转、翻转和缩放等也被提及,这些方法可以增加模型的泛化能力,防止过拟合。

总而言之,CS231N的这次讲座深入讲解了CNN架构的关键元素,以及当时主流的深度学习框架如何支持这些架构的研究和实现,这对于理解现代计算机视觉系统的基石至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-05-02 上传

2021-05-01 上传

2024-04-06 上传

2019-03-16 上传

2021-04-22 上传

2021-04-22 上传

qq_40804229

- 粉丝: 0

- 资源: 1

最新资源

- 20210218_z中文latex-lshort.zip

- dynamic-programming:动态编程问题的解决方案

- cryptoverse-wars-backend

- NHSRdatasets:这是CRAN R软件包系统信息库的只读镜像。 NHSRdatasets —用于教育和培训的与NHS和医疗保健相关的数据。 主页

- LUA5.3支持库1.6版(lua4.fne)-易语言

- three-squirrels-web

- Q00CPU与HITECH触摸屏的通讯的示例。.zip三菱PLC编程案例源码资料编程控制器应用通讯通信例子程序实例

- petGame

- todos-app:使用Laravel框架php解决我的100daysofcode挑战的TODO应用程序

- AI Partition(银灿U盘分区工具)V2.0.0.3

- Stranger-Things:使用JS,jQuery和封闭源社区数据库构建了“消费者对消费者”(C2C)在线交易平台

- 屏蔽win键-易语言

- zenn

- flash_unde_noaxu

- pokedex-react-app-ts

- WiseBot:怀斯(Wise)打造的神奇机器人