物流人工智能:集成学习与强化分类器

版权申诉

195 浏览量

更新于2024-06-28

收藏 3.84MB PPTX 举报

该文件是关于物流人工智能领域中机器学习的集成学习方法的介绍,主要涵盖了强分类器与弱分类器的概念、bagging与随机森林的算法原理、以及boost算法的演变,包括adaboost、GBDT(梯度提升决策树)以及现代的轻量级GBDT实现如LGB(LightGBM)、XGB(XGBoost)和CATBoost。文件旨在提升学习者的实践能力和技术创新,促进产业变革。

集成学习是一种强大的机器学习技术,它通过结合多个弱分类器来创建一个强分类器。弱分类器通常是那些只有轻微优势的模型,而强分类器则是由这些弱分类器组合而成,其性能优于单个弱分类器。在集成学习中,有两种主要的方法:bagging和boosting。

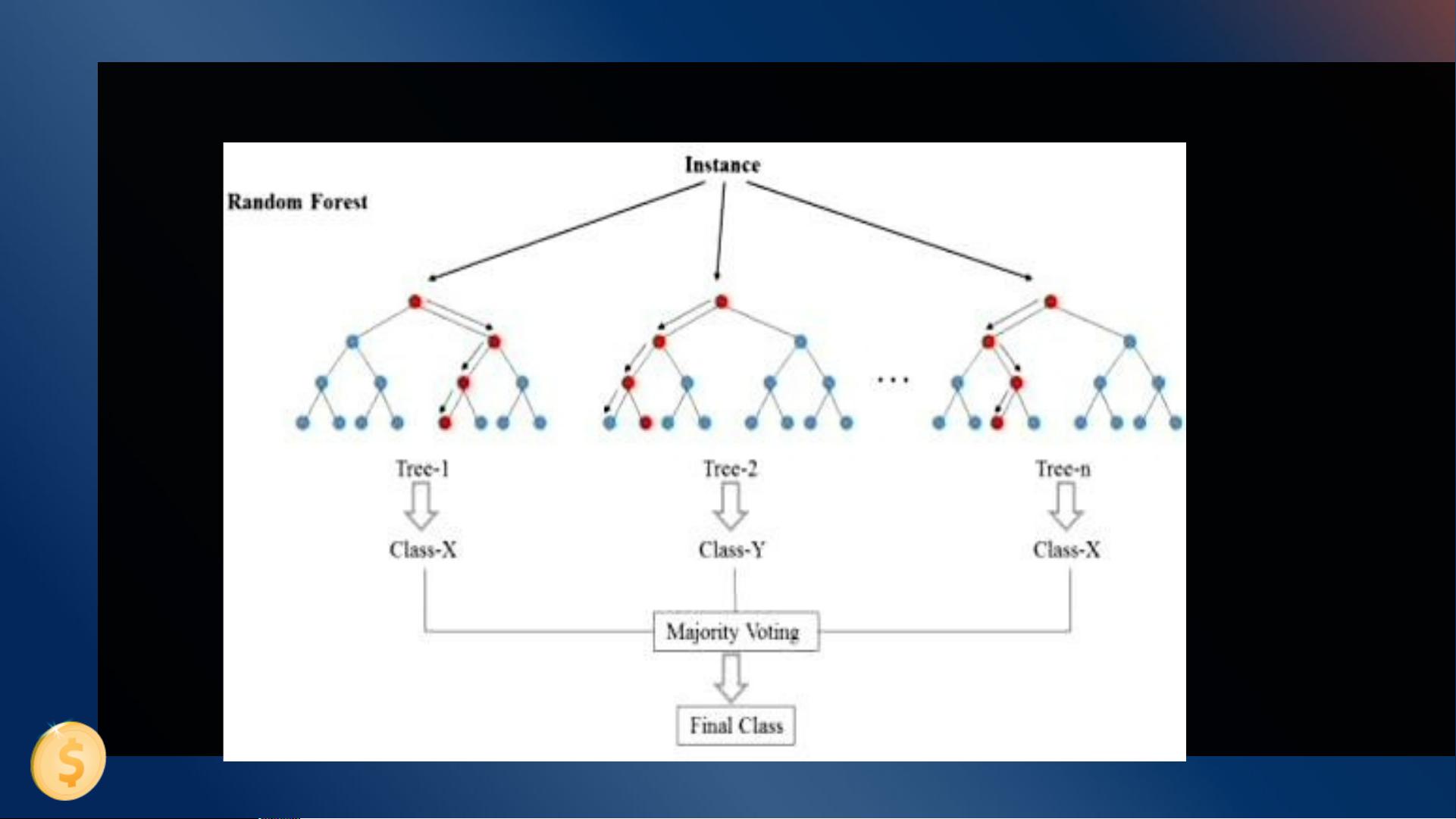

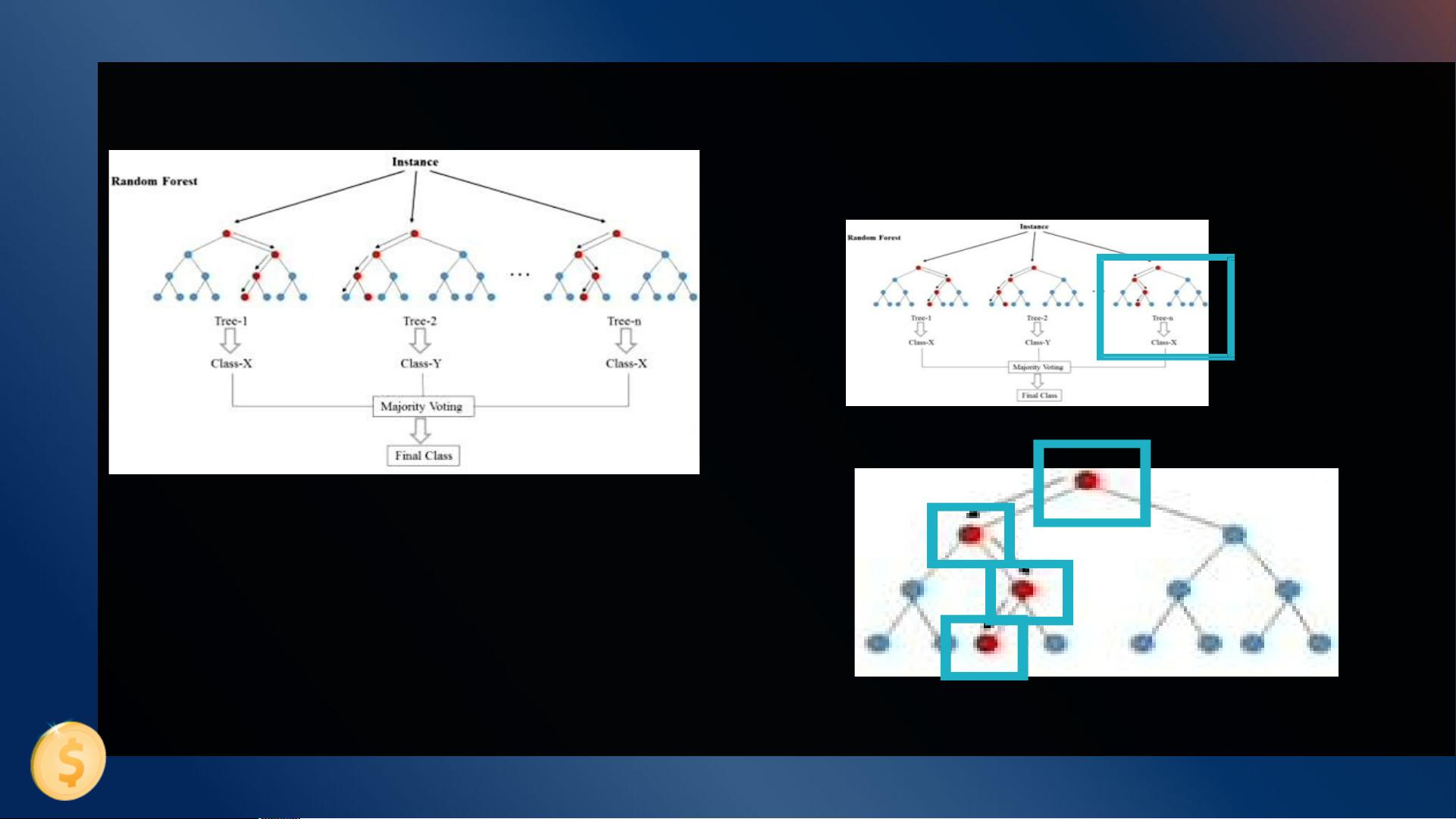

1. **Bagging(Bootstrap Aggregating)** 和 **随机森林(Random Forest)**:

Bagging是一种并行化的集成方法,通过从原始数据集中抽样生成多个子样本(带放回抽样),然后训练多个弱分类器(如决策树)。这些分类器的结果通过投票或平均等方式综合,形成最终的预测。随机森林是bagging的一种特殊形式,它在构建决策树时引入了特征选择的随机性,不仅对数据进行抽样,还对特征进行抽样,从而增加模型多样性,提高预测准确性。

2. **Boosting**:

Boosting是一种序列化的方法,它逐步优化弱分类器的组合。每个新加入的弱分类器会重点关注前一轮分类错误的数据,通过调整这些错误样本的权重,使得后续的分类器更关注这些难以分类的样本。Adaboost是最早的boosting算法之一,它通过迭代调整弱分类器的权重,使得整体模型对错误分类的样本有更高的敏感度。

3. **Gradient Boosting Decision Tree (GBDT)**:

GBDT是boosting的一个变种,它通过最小化残差(预测值与真实值的差异)来迭代地构建决策树。每个新树都试图修正前一棵树的错误,从而逐步提升模型性能。GBDT在许多实际应用中表现优秀,但计算复杂度相对较高。

4. **LightGBM (LGB), XGBoost, and CATBoost**:

这些是GBDT的现代实现,它们针对GBDT的计算效率和内存使用进行了优化。LightGBM采用了梯度提升树的 leaf-wise 生长策略,相比于传统的 depth-wise 策略,可以更快地找到最优分裂点,同时减少过拟合。XGBoost引入了并行化处理和优化的缓存利用,提升了训练速度。CATBoost则在处理类别特征方面表现出色,支持类别特征的排序和离散化。

集成学习的优势在于它能利用多个模型的多样性,减少过拟合,提高泛化能力。在物流领域,集成学习可以应用于路线规划、库存管理、需求预测等场景,通过综合多种模型的预测,提供更准确、更稳健的决策支持。学习和掌握这些算法对于提升物流行业的智能化水平具有重要意义。

2021-09-22 上传

2021-09-21 上传

2021-09-21 上传

2022-11-21 上传

2021-09-21 上传

2021-09-21 上传

知识世界

- 粉丝: 373

- 资源: 1万+

最新资源

- 正整数数组验证库:确保值符合正整数规则

- 系统移植工具集:镜像、工具链及其他必备软件包

- 掌握JavaScript加密技术:客户端加密核心要点

- AWS环境下Java应用的构建与优化指南

- Grav插件动态调整上传图像大小提高性能

- InversifyJS示例应用:演示OOP与依赖注入

- Laravel与Workerman构建PHP WebSocket即时通讯解决方案

- 前端开发利器:SPRjs快速粘合JavaScript文件脚本

- Windows平台RNNoise演示及编译方法说明

- GitHub Action实现站点自动化部署到网格环境

- Delphi实现磁盘容量检测与柱状图展示

- 亲测可用的简易微信抽奖小程序源码分享

- 如何利用JD抢单助手提升秒杀成功率

- 快速部署WordPress:使用Docker和generator-docker-wordpress

- 探索多功能计算器:日志记录与数据转换能力

- WearableSensing: 使用Java连接Zephyr Bioharness数据到服务器