AI大模型时代的存储挑战与解决方案

需积分: 5 135 浏览量

更新于2024-06-16

收藏 12.32MB PDF 举报

"02Hardware.pdf - 介绍的是AI集群中的大模型数据存储现状、挑战以及相关的硬件和连接方式。内容涵盖了存储技术架构的发展、硬件介质的种类、存储架构的类型,以及大模型训练中涉及的数据存储问题和CKPT优化。"

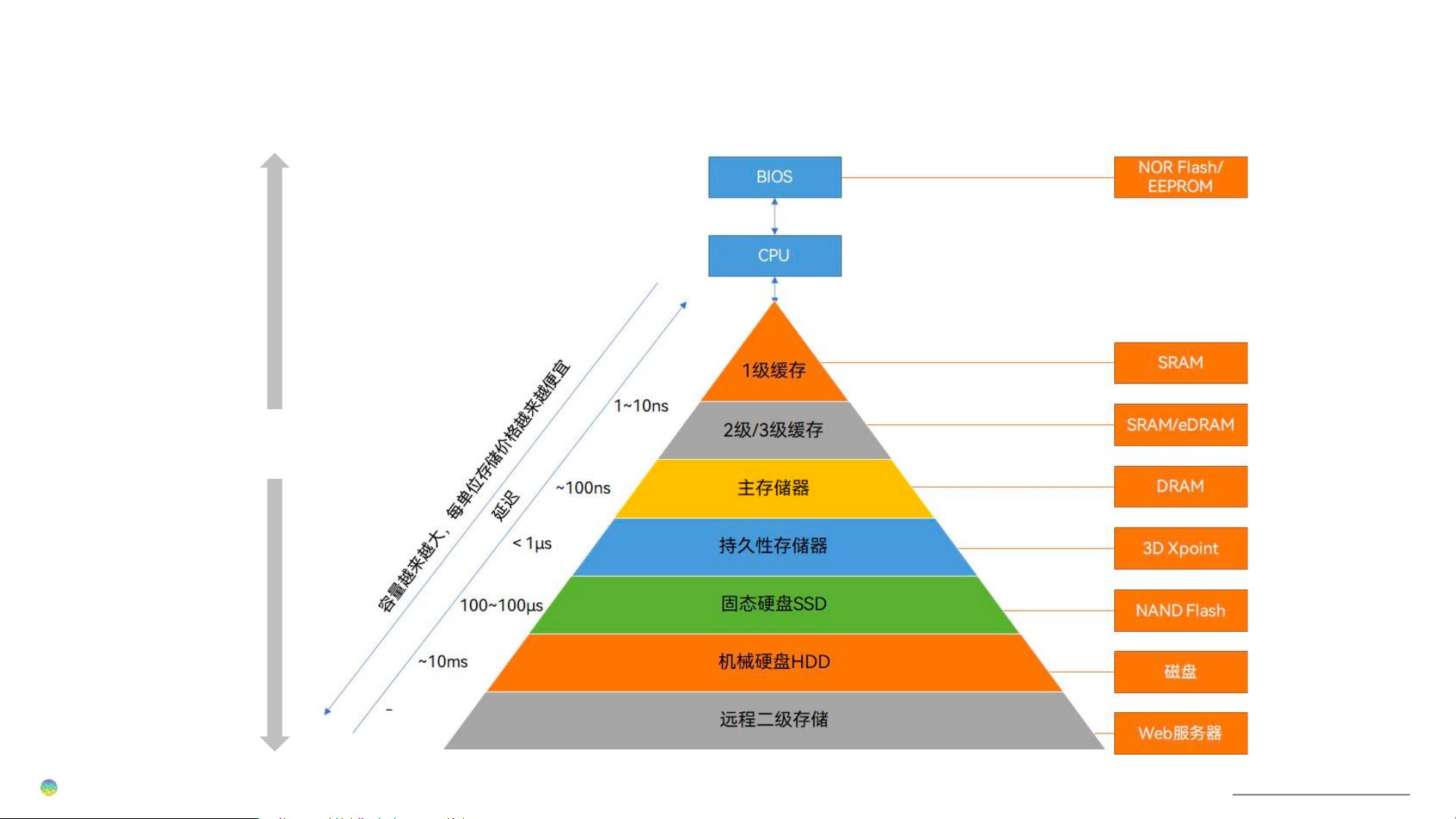

在AI集群和大模型的背景下,数据存储扮演着至关重要的角色。存储技术的架构和硬件介质是支撑AI应用,特别是大模型训练的基础。传统的硬件介质包括机械硬盘(HDD)、固态硬盘(SSD)、光盘和磁带,其中固态硬盘因其高速度和低延迟特性在大数据处理和AI领域受到青睐。

存储架构分为多种类型,如分布式存储和集中式存储,分别适用于不同的应用场景。分布式存储通过网络将多个独立的存储设备连接起来,提供高可用性和扩展性,适合大规模数据处理;而集中式存储则倾向于提供高性能和统一的访问接口。连接方式有DAS(直接连接存储)、NAS(网络附加存储)和SAN(存储区域网络),各有优缺点,其中DAS适用于单机系统,NAS适合文件共享,而SAN则提供块级数据访问,常用于企业级应用。

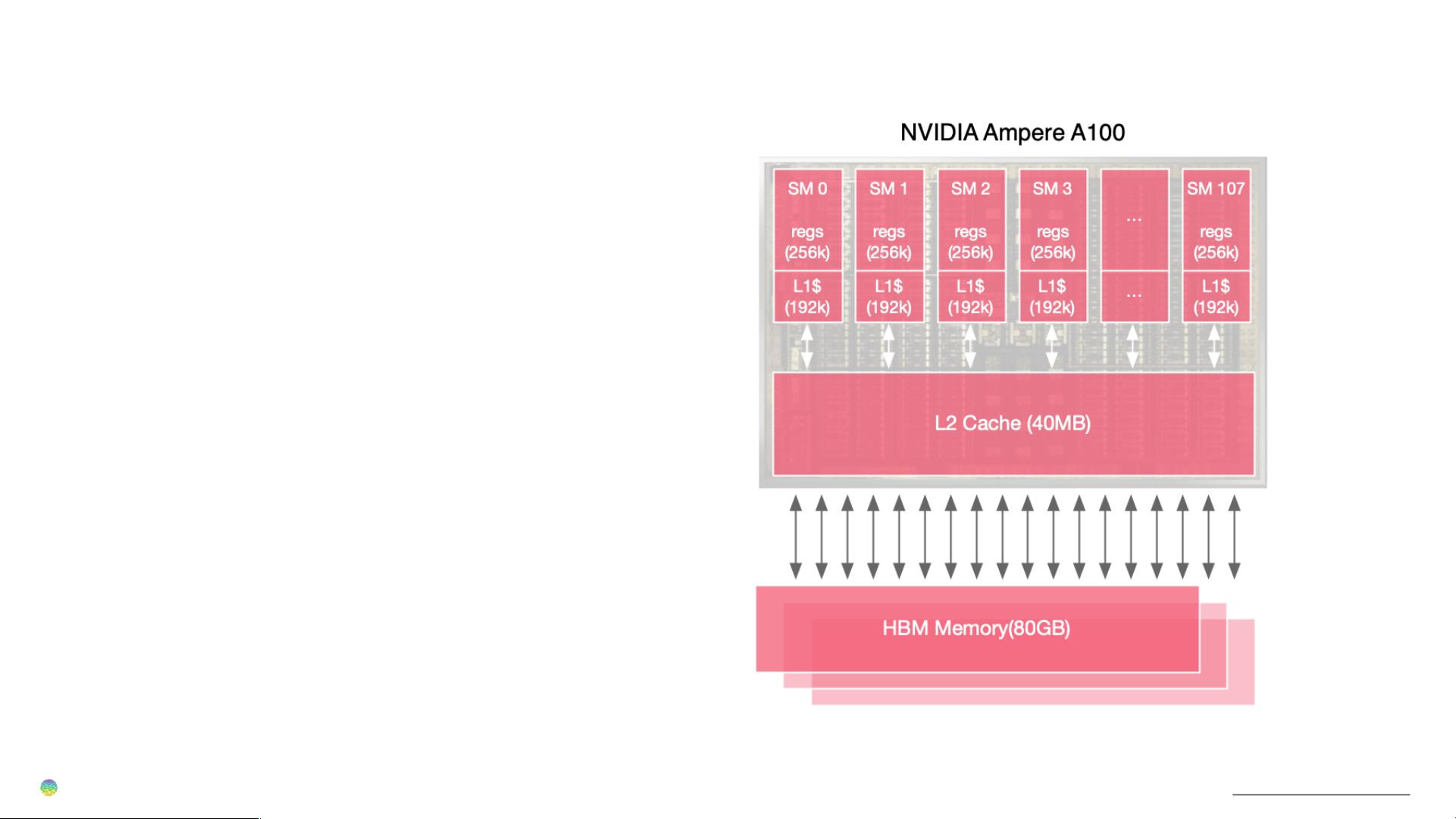

在大模型训练过程中,训练数据的量级庞大,因此对存储性能提出了高要求。CheckPoint(检查点)技术是训练过程中保存模型状态的关键,优化CKPT可以减少存储开销和恢复时间。多级存储系统,如结合高速缓存和慢速持久存储,可以有效地平衡性能与成本。

随着AI技术的发展,多模态大模型如LLM(Large Language Models)如LLAMA的出现,对存储提出了新的挑战。存储对象、存储协议(如对象存储、块存储、文件存储对应的NFS、HDFS、NVMe、SCSI等)的选择需要适应AI模型的特性和工作负载。例如,TensorFlow和PyTorch等框架通常会利用块存储进行高效计算。

在AI大模型时代,理想的存储架构应具备高速读写能力、高容错性和可扩展性,同时要能应对不断增长的数据量和模型复杂性。因此,对于存储架构的选取和设计,需要综合考虑性能、成本、可靠性和未来扩展的可能性。

2008-09-02 上传

2019-10-22 上传

2019-10-09 上传

2019-10-28 上传

LittleBrightness

- 粉丝: 0

- 资源: 145

最新资源

- Aspose资源包:转PDF无水印学习工具

- Go语言控制台输入输出操作教程

- 红外遥控报警器原理及应用详解下载

- 控制卷筒纸侧面位置的先进装置技术解析

- 易语言加解密例程源码详解与实践

- SpringMVC客户管理系统:Hibernate与Bootstrap集成实践

- 深入理解JavaScript Set与WeakSet的使用

- 深入解析接收存储及发送装置的广播技术方法

- zyString模块1.0源码公开-易语言编程利器

- Android记分板UI设计:SimpleScoreboard的简洁与高效

- 量子网格列设置存储组件:开源解决方案

- 全面技术源码合集:CcVita Php Check v1.1

- 中军创易语言抢购软件:付款功能解析

- Python手动实现图像滤波教程

- MATLAB源代码实现基于DFT的量子传输分析

- 开源程序Hukoch.exe:简化食谱管理与导入功能