数据挖掘:相似性与相异性度量探索

版权申诉

29 浏览量

更新于2024-07-07

收藏 91KB DOCX 举报

"数据挖掘化功大法(8)——相似性和相异性"

在数据挖掘领域,理解和计算相似性和相异性是至关重要的,因为这些概念是众多算法的基础,如聚类分析、最近邻分类和异常检测。相似度衡量了两个对象之间的接近程度,而相异性则反映了它们之间的差异。相似度通常以非负值表示,范围在0(完全不相似)到1(完全相似)之间。相异性通常用“距离”来量化,距离越小,相似度越高。

1. 欧氏距离(Euclidean Distance)

欧氏距离是最常见的距离度量方式,特别是在二维和三维空间中。但在高维空间中,由于未考虑变量间的相关性,欧氏距离可能不准确。它通过计算两个向量各分量差的平方和的平方根来得出距离。公式为:d = sqrt(∑(xi1 - xi2)^2),其中i=1,2,...,n。欧氏距离适用于数据点分布均匀且各维度权重相等的情况。然而,当不同属性的重要性不同时,欧氏距离可能不适用。

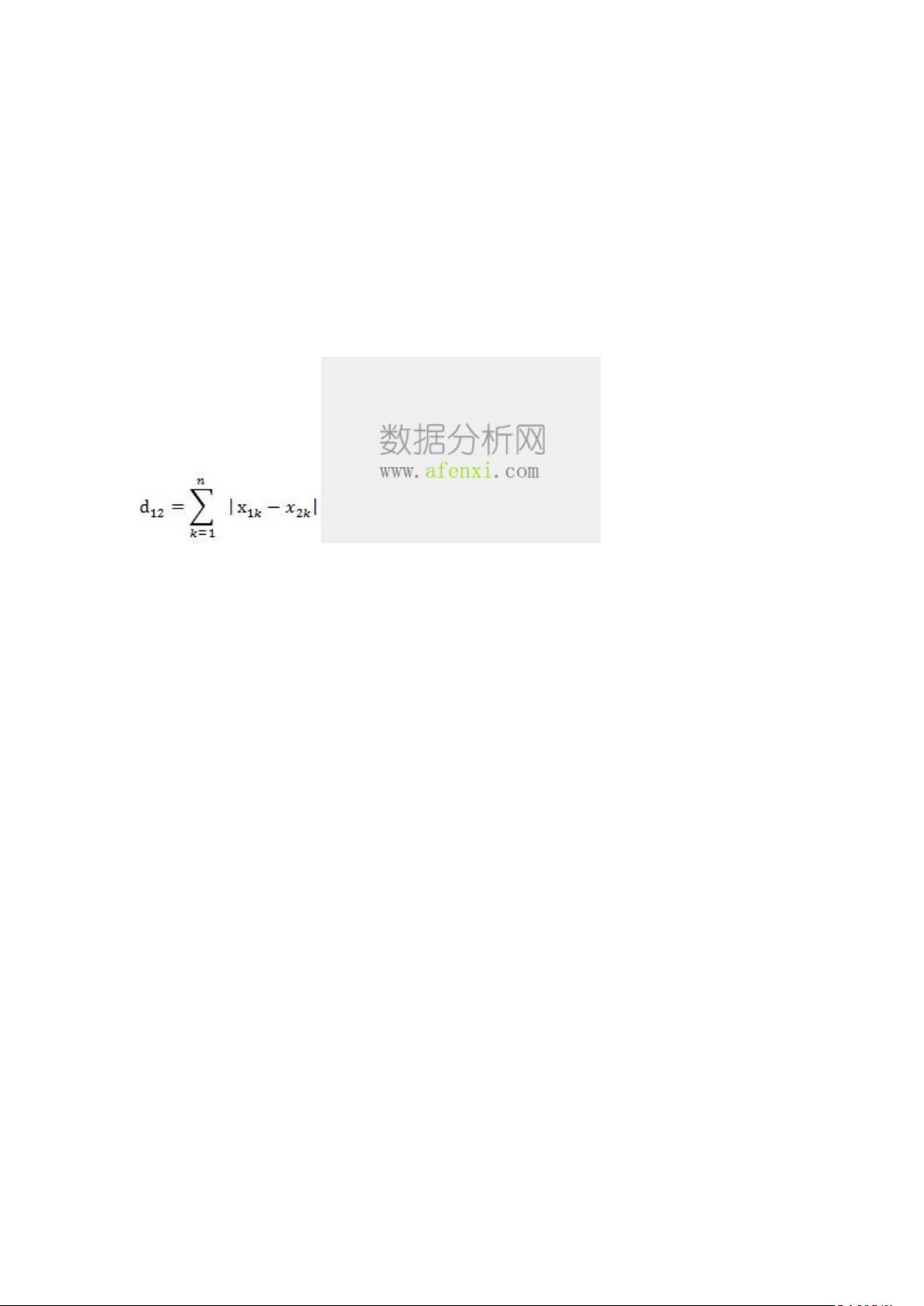

2. 曼哈顿距离(Manhattan Distance)

曼哈顿距离源于城市街区的直观概念,即沿着网格状道路行走的距离。对于两个n维向量A和B,其曼哈顿距离为各分量绝对差的总和,即D(A,B) = ∑|xi1 - xi2|。曼哈顿距离不受变量尺度影响,适合处理各维度独立且具有相同重要性的数据。

除了上述两种距离,还有其他多种相似性和相异性度量方法:

3. 切比雪夫距离(Chebyshev Distance)

切比雪夫距离是两个向量各分量差的绝对值的最大值,适用于需要强调最大差异的场景。

4. 马氏距离(Mahalanobis Distance)

马氏距离考虑了变量间的相关性和数据的方差,提供了一个标准化的距离度量,尤其适用于多变量分析。

5. Jaccard相似度(Jaccard Similarity)

用于比较集合的相似性,计算的是两个集合交集的大小除以并集的大小,适用于二元属性或类别数据。

6. 余弦相似度(Cosine Similarity)

衡量两个向量在高维空间中的角度,适用于文本分析和其他基于向量的空间。

选择合适的相似性和相异性度量取决于具体的应用场景和数据特性。例如,如果数据包含不同重要性的属性,可能需要使用加权距离;如果数据具有大量缺失值,可以选择能够处理缺失值的度量;在文本分析中,可能需要使用能捕捉词汇关联性的相似度度量。

理解和选择正确的相似性与相异性度量是数据挖掘成功的关键步骤,因为它直接影响到算法的性能和结果的解释。在实际应用中,可能需要尝试不同的度量方法,以找到最适合特定问题的那一种。

2021-12-23 上传

weixin_41031635

- 粉丝: 0

最新资源

- 全面详实的大学生电工实习报告汇总

- 利用极光推送实现App间的消息传递

- 基于JavaScript的节点天气网站开发教程

- 三星贴片机1+1SMT制程方案详细介绍

- PCA与SVM结合的机器学习分类方法

- 钱能版C++课后习题完整答案解析

- 拼音检索ListView:实现快速拼音排序功能

- 手机mp3音量提升神器:mp3Trim使用指南

- 《自动控制原理第二版》习题答案解析

- 广西移动数据库脚本文件详解

- 谭浩强C语言与C++教材PDF版下载

- 汽车电器及电子技术实验操作手册下载

- 2008通信定额概预算教程:快速入门指南

- 流行的表情打分评论特效:实现QQ风格互动

- 使用Winform实现GDI+图像处理与鼠标交互

- Python环境配置教程:安装Tkinter和TTk